Глава 3: Социальный разум

Кибернетика

Любовь и война Мы видели, как даже простейшие формы жизни, такие как бактерии, эволюционируют, чтобы предсказывать свою среду, внутренние состояния и действия. Нормативность (хорошо против плохо) и базовые чувства (такие как голод, насыщение и боль) возникают как следствие предсказания. Однако обсуждение до сих пор велось в рамках игры для одного игрока: как «я» может эволюционировать, чтобы повысить свою динамическую стабильность в мире, который, если не враждебен, то по крайней мере безразличен. Пищевые молекулы, которые бактерия преследует во время хемотаксиса, не убегают; молекулы, вызывающие хеморепеллентный эффект, тоже не являются активными агрессорами. Хемотактические бактерии моделируют молекулярную концентрацию, но эти маленькие молекулы, вероятно, не моделируют бактерии в ответ.

Когда дело доходит до волков и кроликов, однако, действуют несколько агентов, моделирующих друг друга — будь то в испуганном тревожном состоянии (кролик) или с убийственными намерениями (волк). У животных с большим мозгом, таких как мы (и волки, и кролики), тоже есть детализированные модели самих себя, а также своих близких и родных — надеемся, без испуганной тревоги и убийственных намерений. Такие богатые социальные, субъективные и «интерсубъективные» переживания кажутся далекими от простой механики программ bff или бактерий. Тем не менее, я утверждаю, что умы, подобные нашим, являются естественным следствием тех же эволюционных динамик. В частности, умы возникают, когда моделирование других умов становится важным.

Необходимость такого моделирования уходит корнями в далекое прошлое. Она связана с двумя основными эволюционными переходами: возникновением полового размножения, вероятно, около двух миллиардов лет назад, и охотой, которая стала распространенной во время кембрийского взрыва, 538,8 миллиона лет назад. Поскольку половое размножение так древно, впервые возникнув среди наших далеких одноклеточных предков, его происхождение остается неясным. Секс мог быть неотъемлемой частью еукариотической революции, произошедшей два миллиарда лет назад.

Поскольку эукариоты являются каноническим примером симбиогенеза, неудивительно, что секс сам по себе является симбиотическим: женская и мужская формы вида зависят друг от друга для размножения, взаимно выигрывая от более быстрого эволюционного обучения. (Таким образом, при большинстве обстоятельств и равенстве всех других факторов, вид, размножающийся половым путем, будет иметь преимущество над тем, который размножается бесполым способом, даже несмотря на то, что каждый отдельный член бесполого вида сталкивается с меньшими барьерами для размножения.)

Для наших целей половое размножение имеет значение, потому что оно требует от организма распознавания своего сородича и, как правило, различения мужского и женского пола с соответствующей модификацией поведения. Это важно: когда размножение требует полово-избирательного сотрудничества или конкуренции, другие представители того же вида (и тонкие различия между индивидами) становятся обязательной частью их окружающего мира.

Ископаемое из Эдиакарской биоты

Теперь давайте переместимся вперед на полтора миллиарда лет. Хотя многие аспекты древнего ископаемого запаса остаются спорными, существует широкое согласие в том, что жизнь в докембрии была доминирована мягкотелыми организмами с разнообразными формами и симметриями, от трубчатых до стеганых и более аморфных. Мы можем только догадываться, как эти древние эдиакарцы передвигались, но вполне вероятно, что граница между растениями и животными была бы нечеткой, и многие организмы либо дрейфовали по океанским течениям, либо были прикреплены к камням, их листья или придатки лениво колыхались в поисках питательных веществ. Нервные системы в этот период, если они вообще присутствовали, могли выглядеть как распределенные нервные сети гидр или гребневиков.

Марелла спленденс

ископаемое из сланцев Бёрджесса, средний кембрий

Затем произошла кембрийскаяExplosion: внезапное появление огромного разнообразия морских существ с выпуклыми глазами, броневыми пластинами, устрашающими клешнями и острыми зубами. Невозможно не представить их, быстро и активно передвигающихся, охотящихся, убегающих, убивающих и будучи убитыми. Началась гонка вооружений, сопровождаемая потоком инноваций и контрмер в искусстве атаки и защиты. Впервые для разумной координации быстрого, восприимчивого, целенаправленного движения потребовались бы сложные, централизованные нервные системы.

Были открыты (односторонние) радости хищничества.

Учитывая ранее обсуждение термодинамики и ее связь с динамической стабильностью, стоит остановиться и разъяснить дарвиновский мотив хищничества, даже если он кажется интуитивно очевидным. Почему мы, собственно, едим?

Напомним, что жизнь требует вычислений для воспроизводства (согласно главе 1) и для реагирования на изменения в окружающей среде или внутреннем состоянии (согласно главе 2). Вычисления, в свою очередь, требуют свободной энергии — хотя стоит отметить, что этот термин может быть обманчивым. Энергия не может быть создана или уничтожена; мы не «истощаем» ее.

Свободная энергия на самом деле означает источник порядка или низкой энтропии. Напомним, что в термодинамике классической низкоэнтропийной системой является прессованный поршень: цилиндр с воздухом, в котором большинство молекул газа сосредоточены с одной стороны перегородки, оставляя частичный вакуум с другой стороны. Вероятность того, что такая ситуация возникнет спонтанно — как если бы случайно отскакивающие бильярдные шары вдруг образовали треугольник на одном конце стола — крайне мала, но при заблокированном поршне, предотвращающем перераспределение газа более случайным образом, давление может поддерживаться.

Эта низкоэнтропийная конфигурация подобна сжатой пружине или взведенному пистолету.

В тот момент, когда поршень получает возможность двигаться, он начинает двигаться с силой, пока давления с обеих сторон не уравновесятся — то есть, пока энтропия снова не достигнет максимума. Это «израсходует» свободную энергию, хотя общее количество фактической энергии в системе (пропорциональное сумме квадратов скоростей всех молекул газа) останется неизменным. Когда Ньюкомен и Уатт использовали движение поршня для работы насоса или вращения нагруженного коленчатого вала, молекулы замедлялись, охлаждая газ.

Теперь вспомните, что как только жизнь начинает развиваться, она создает предсказуемость и порядок; её энтропия падает. Это тоже требует работы. Это также означает, что само существо является своего рода прессованным поршнем — или нагруженной пружиной, или взведенным пистолетом. Другими словами, это замечательный источник свободной энергии. (Особенно жирные части; все эти вкусные углеродно-водородные связи!) Таким образом, хищничество: одна форма жизни использует порядок, или «отрицательную энтропию», накопленную в теле другой формы жизни, чтобы поддерживать или увеличивать свой собственный порядок или отрицательную энтропию.

Здесь есть конфликтующие интересы. В лучшем случае (для жертвы) хищник просто сделает безобидный укус или укол — так действуют блохи, клещи, мухи и комары. Мы все равно их недолюбливаем; поведенческие реакции среди приматов и размахивание хвостами у лошадей эволюционировали, чтобы отпугивать такие микро-хищничества. (И, частично в ответ, мухи стали молниеносно быстрыми, комары эволюционировали, чтобы вводить анестетики, а клещи стали настойчивыми «плотоядными».) Что касается хищничества, которое проявляется в более крупных, смертельных укусах — то избегание этого любой жертвой становится первоочередной задачей.

На первый взгляд, две великие революции, о которых я только что рассказал — секс и хищничество — кажутся совершенно не связанными, как любовь и война. Однако и любовь, и война требуют от вас способности распознавать и формировать внутренние модели других живых существ в стремлении к динамической стабильности.

Им требуется, другими словами, эффективное предсказание чего-то, что само по себе является предсказателем.

О любви мы поговорим позже в книге. А сейчас сосредоточимся на войне — оригинальном «убийственном приложении» — с вычислительной точки зрения. Вернемся ненадолго в Лондон девятнадцатого века.

Убийственное приложение

Бэббидж изо всех сил пытался найти финансирование для своего Аналитического двигателя. Рынок жаккардовых текстилей был очевиден, но кому нужны были массово производимые «аналитические формулы»? Чтобы продать идею математических таблиц как популярного товара, он прибегал к простым примерам, таким как «количество фунтов мяса от 1 до 100 фунтов по различным ценам за фунт».

Таблицы цен для деревенского мясника? Вряд ли. Чутье подсказывает, что мелкие торговцы не могли бы стать жизнеспособной клиентской базой для громоздкой промышленной машины, такой как Аналитический двигатель.

Государственное управление, на которое ставил Прон, было ближе к истине; информационные потребности бюрократических правительств росли.

Тем не менее, было еще слишком рано. Французское правительство прекратило финансирование проекта Прон задолго до его завершения.

Настоящим убийственным приложением была война. Британская армия и флот стали бы очевидными спонсорами Бэббиджа, и в конечном итоге именно их отсутствие инвестиций погубило его предприятие.

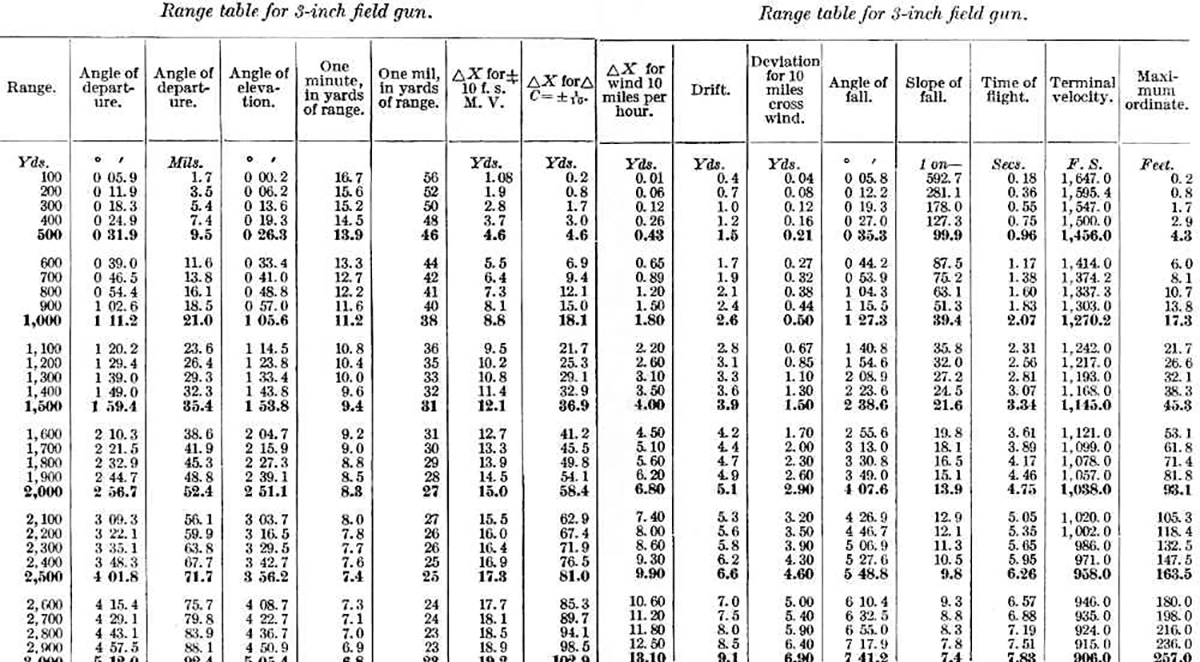

Таблицы дальности для американской 3-дюймовой полевой пушки, модели 1902–1905 годов, снаряд весом 15 фунтов.

К моменту начала девятнадцатого века артиллерийская таблица уже стала образцовым продуктом человеческих вычислений. Для каждой крупной пушки требовалась новая таблица, включая коррекции для таких факторов, как высота, ветер и атмосферное давление. С каждым крупным мировым конфликтом, начиная с Наполеоновских войн (1803–1815), артиллерийская стрельба становилась все более важной, а вместе с ней и табуляция. А выполнение расчетов вручную занимало много времени.

▶

Артиллерия Первой мировой войны

К моменту Первой мировой войны, первого полностью индустриализированного масштабного конфликта, как Союзники, так и Центральные державы активно использовали сложные таблицы. Артиллерийский огонь часто планировался за несколько дней, и его точность стала решающей для поддержки наступлений пехоты. Вычисления стали узким местом в ведении войны, и именно это, больше чем любой другой фактор, в конечном итоге побудило к серьезным инвестициям в автоматические вычисления между мировыми войнами.

Когда началось наращивание производства оружия для Второй мировой войны, Школа электротехники Университета Пенсильвании наняла как минимум двести женщин для работы над артиллерийскими таблицами. Их методы были бы в значительной степени знакомы Бэббиджу или Проне. Но, подстегнутые военными нуждами, технологии развивались с головокружительной скоростью. Шесть женщин из Школы Мура были выбраны, чтобы стать программистами

ENIAC.

Этот первый полностью универсальный программируемый компьютер был создан для автоматизации табуляции артиллерийских данных.

▶

Короткометражный фильм о ENIAC, 1946 год

К моменту, когда ENIAC стал оперативным в декабре 1945 года, приоритеты изменились. Немцы и японцы были побеждены, но холодная война началась прямо там, где закончилась Вторая мировая. Первой значительной программой нового компьютера стала симуляция «Суперпроблемы», исследующая возможность создания водородной бомбы.

Необходимая математика была значительно сложнее, чем расчет баллистических траекторий, а тысячи вакуумных трубок в машине часто выходили из строя, требуя почти ежедневного ремонта. Это стимулировало быстрое улучшение аппаратного обеспечения, положив начало тому, что позже стало известно как закон Мура.

Ранние компьютеры были далеки от всего, что мы имеем сегодня.

Удивительно осознавать, сколько лет капиталоемкого инкубирования в рамках военно-промышленного комплекса потребовалось, прежде чем технологии стали достаточно дешевыми, надежными и миниатюрными, чтобы вызвать настоящий интерес со стороны частного сектора, не говоря уже о деревенском мяснике.

Главный компьютер IBM 701, анонсированный 21 мая 1952 года и изначально названный «Оборонным калькулятором», стал первым компьютером, доступным для коммерческого использования в США. Существует апокрифическая цитата, обычно приписываемая Томасу Дж. Уотсону-младшему, президенту IBM, с собрания акционеров в 1953 году, в которой он утверждает, что верит в существование мирового рынка всего для пяти компьютеров. Это не совсем правда; Уотсон действительно сказал, что когда IBM разработала планы для 701 и представила их «около двадцати компаниям», которые, по их мнению, «могли бы использовать такую машину», они предполагали, что получат всего пять заказов, и были поражены, получив восемнадцать.

Сначала универсальные компьютеры не были предназначены для работы в реальном времени. Как и человеческие вычислители, которых они заменили, они поддерживали военные усилия, используя пакетную обработку. Такие вычисления были медленным, оффлайн-процессом. Вы отправляли свою задачу и шли пить кофе… или, скорее, дремали, пока техники занимались задачей, заменяя трубки, устраняя заедания считывателей перфокарт и меняя катушки магнитной ленты. На ENIAC выполнение bff заняло бы века для полной репликации ленты. К 1952 году на IBM 701 это все еще заняло бы годы, работая без остановки, и стоило бы миллионы долларов (по сегодняшним меркам).

▶ Рекламный ролик IBM 701, 1953 год

В 50-х годах действительно начались первые эксперименты с интерактивными архитектурами. Проект Whirlwind, запущенный в 1951 году, изначально был разработан для симуляции полетов и позже стал сердцем системы противовоздушной обороны SAGE ВВС США.

Важность вычислений в реальном времени возросла благодаря развитию радарных и сопутствующих радиосигнальных технологий, которые позволили одной машине физически обнаруживать другую — по крайней мере, одну из которых могло двигаться с высокой скоростью и с потенциально смертельными намерениями. Вскоре появились системы «Определение друга или врага» (IFF), использующие зашифрованные сигналы, чтобы пометить радарные точки, когда неопознанный объект оказывался «своим». Это, в свою очередь, создало стимул для взлома IFF-систем противника, подделывая сигнал «друга», чтобы незаметно проникнуть на вражескую территорию. Началась игра технического превосходства, не слишком отличающаяся от кембрийского взрыва.

Еще более «кембрийским» стало стремительное увеличение скорости, точности и смертоносности военной техники. Реактивные истребители, ракеты и системы противоракетной обороны начали массово производиться. GPS был в значительной степени разработан для обеспечения автономного управления оружием, так как было очевидно, что высокоскоростная война вскоре сделает невозможным участие человека в процессе; необходимая точность и время реакции превышали человеческие возможности. Даже перегрузки, возникающие при воздушных маневрах, вскоре начали превышать пределы человеческой выносливости.

Роботам необходимо было замкнуть сенсомоторные петли этих новых систем оружия.

Поведение, Цель и Телология

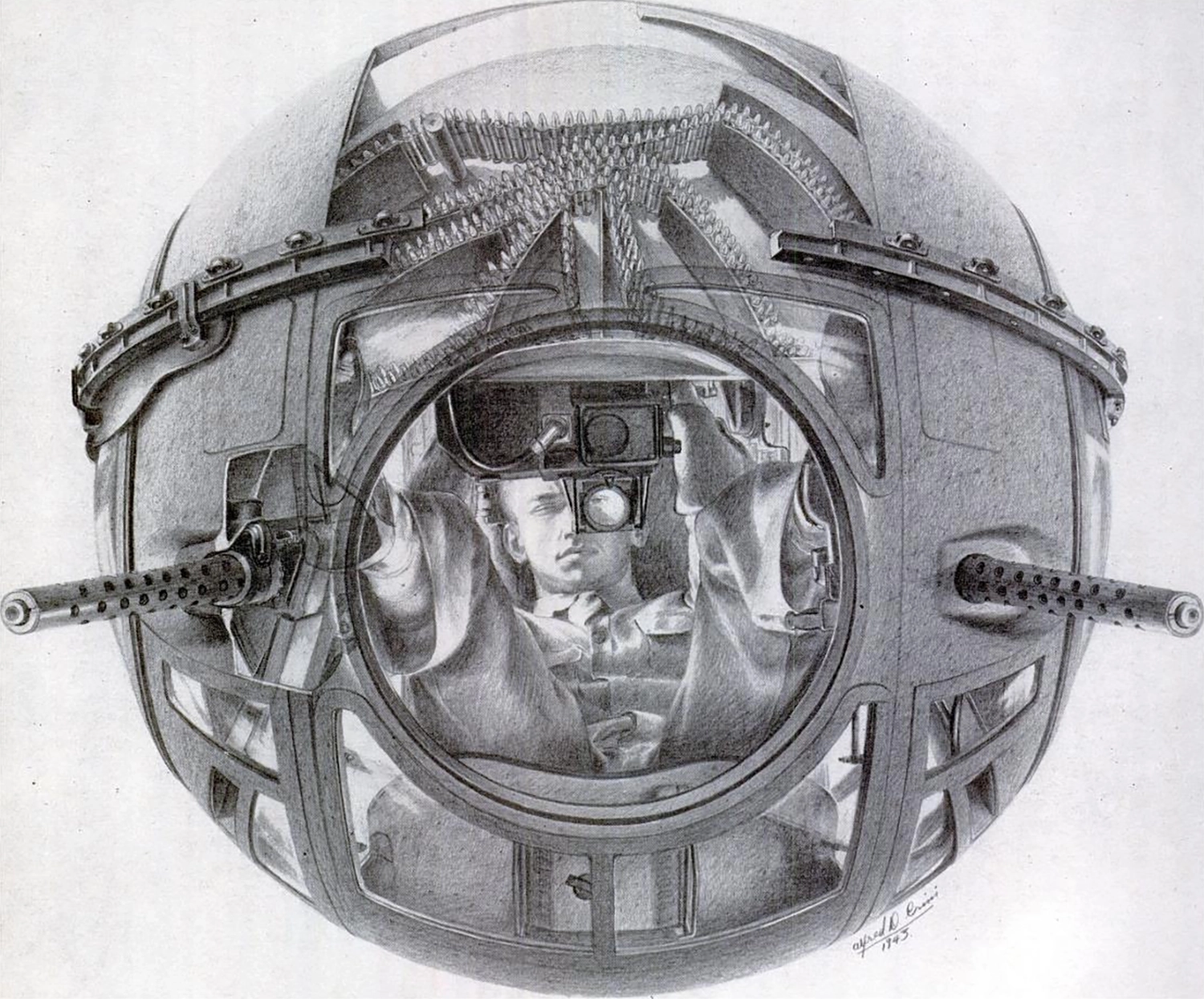

Сферическая турель времен Второй мировой войны, нарисованная Альфредом Д. Кримми, 1943 год

Таким образом, родилась область кибернетики, названная так в 1947 году математиком MIT Норбертом Винером, физиологом Артуро Розенблютом и их коллегами. В отличие от пакетных вычислений, кибернетика сосредоточилась на петлях обратной связи в реальном времени, включающих непрерывные временные сигналы, такие как положение, скорость и тяга. Ранние прототипы кибернетических технологий включали электромеханические башни орудий и автоматические системы прицеливания бомб, используемые для точного времени сброса боеприпасов с самолета на цель, часто с применением аналоговых кулачков и шестеренок. Кибернетики взялись за задачу обобщения таких систем для воздушных боев, в которых цель не является неподвижной.

В условиях шума и неопределенности такие задачи можно формулировать с помощью теории информации, в которой Винер сделал важные ранние вклады. Предполагая, что «мозг» системы наведения является линейным, то есть его выходы представляют собой взвешенные суммы входов, он также вывел элегантные теоретические результаты в области оптимальной фильтрации и управления. (Бактериальная хемотаксис, описанная в главе 2, может быть смоделирована с использованием той же математики.) Эти оптимальные линейные теории полезны как для создания систем вооружения, так и, при многих реальных условиях, могут быть трудны для улучшения: когда цель ясна и неизменна, все происходит очень быстро, а измерения шумные, времени на то, чтобы нелинейность имела значение, просто нет.

В высокоскоростных, целенаправленных и аналогичных противостоящих естественных контекстах, таких как летучая мышь или стрекоза, стремящиеся к добыче, мозги животных также могут осуществлять нечто близкое к кибернетически оптимальному линейному моделированию. То же самое происходит, когда вы тянетесь за предметом или ловите мяч.

▶ Летучая мышь использует сонар для охоты на мотыльков

Мячи не пытаются активно избежать вас — по крайней мере, вне вселенной Гарри Поттера. Однако мотылек ведет себя как настоящая «золотая снитч», когда летучая мышь приближается к ужину. Он не может лететь так быстро, как летучая мышь; его мозг и сенсорный аппарат тоже уступают. Но он может попытаться уклониться. Уклонения должны быть поистине непредсказуемыми, поскольку случайность — единственное кибернетическое преимущество мотылька. Летучая мышь, обладая гораздо большим мозгом, предвосхитит любой более последовательный план, который мог бы придумать мотылек. Таким образом, пока летучая мышь применяет нечто близкое к оптимальному прогнозированию, адаптированному к статистике полета мотылька, мотылек использует свою малую массу, чтобы хаотично порхать, размывая эти статистические данные. Вместо гладкой, предсказуемой кривой получившийся паттерн полета представляет собой извивающийся «случайный блуждание», занимающий объем в пространстве, ласково называемый «сосиской Винера». (Это правда.)

Симуляция частицы, случайно диффундирующей в 3D, ее путь примерно заключен в «сосиску Винера»

Как вы, вероятно, знаете, если когда-либо пытались — и не смогли — поймать, казалось бы, не слишком быструю бабочку, тактика «сосиски Винера» работает, по крайней мере, до определенной степени. Бабочка использует ее с помощью биологического генератора случайных чисел, вероятно, основанного на сочетании механической нестабильности крыльев и случайной нейронной активности. Если вы задаетесь вопросом, как нейронная активность может быть случайной, имейте в виду, что она всегда немного таковой. Биохимические процессы, приводящие к нейронному возбуждению, включают открытие и закрытие ионных каналов в клеточной мембране, а также высвобождение и захват синаптических пузырьков, содержащих нейротрансмиттеры. Тайминг этих событий никогда не бывает абсолютно точным, поскольку они зависят от тех же случайных молекулярных взаимодействий, которые движут всей клеточной активностью. Если нейронная цепь настроена на усиление этого шума, то, как и случайная инструкция компьютера Тюринга Ferranti Mark I, результатом будет вычисляемый случайный сигнал.

Существуют веские доказательства того, что жертвенные виды, такие как бабочки, используют такие цепи для генерации хаотичного поведения; испуганные тараканы, аналогично, используют их, чтобы метаться в случайном порядке.

Если случайность — это низкий путь к кибернетической непредсказуемости, то существует и более высокий путь: стать умнее сущности, пытающейся вас предсказать, и предсказать предсказания этой сущности. Мы исследуем эту более умную стратегию в главе 5.

Но сначала давайте полностью осознаем кибернетику — что она сделала правильно, что неправильно, ее несвоевременный конец и ее продолжающееся влияние. Как сформулировал Винер, кибернетика была той областью, которую мы сейчас называем Искусственным Интеллектом, и более того — это был отличительный признак всех сложных систем, великая объединяющая теория биологического, технологического и даже социологического.

Самая простая кибернетическая система — это что-то вроде скромного термостата, механизма обратной связи, который включает и выключает отопление (или кондиционер), чтобы поддерживать постоянную температуру. Теплокровные животные, конечно, делают именно это, и живые системы в целом должны использовать обратную связь для поддержания (то есть регулирования) своего внутреннего состояния. В широком смысле, гомеостаз — это то, о чем идет речь, когда мы говорим о жизни. Целью питания, например, является поддержание запасов свободной энергии в организме, и подобные целенаправленные аргументы можно привести для всех наших основных влечений. Наши вторичные влечения, такие как стремление к похвале или престижу, в свою очередь, могут быть сформулированы как «инструментальные» по отношению к этим основным влечениям. Таким образом, гомеостаз — это наш старый знакомый, динамическая стабильность, реализуемая целенаправленно.

Сложные поведенческие реакции животных могут показаться далекими от работы термостата, но подумайте, что действительно оптимальный термостат будет не только включаться или выключаться в ответ на колебания температуры сейчас, но и на основе своих предсказаний о будущем. Если, например, солнце вот-вот взойдет и начнет быстро нагревать ваш дом, это должно повлиять на стратегию вашего домашнего термостата.

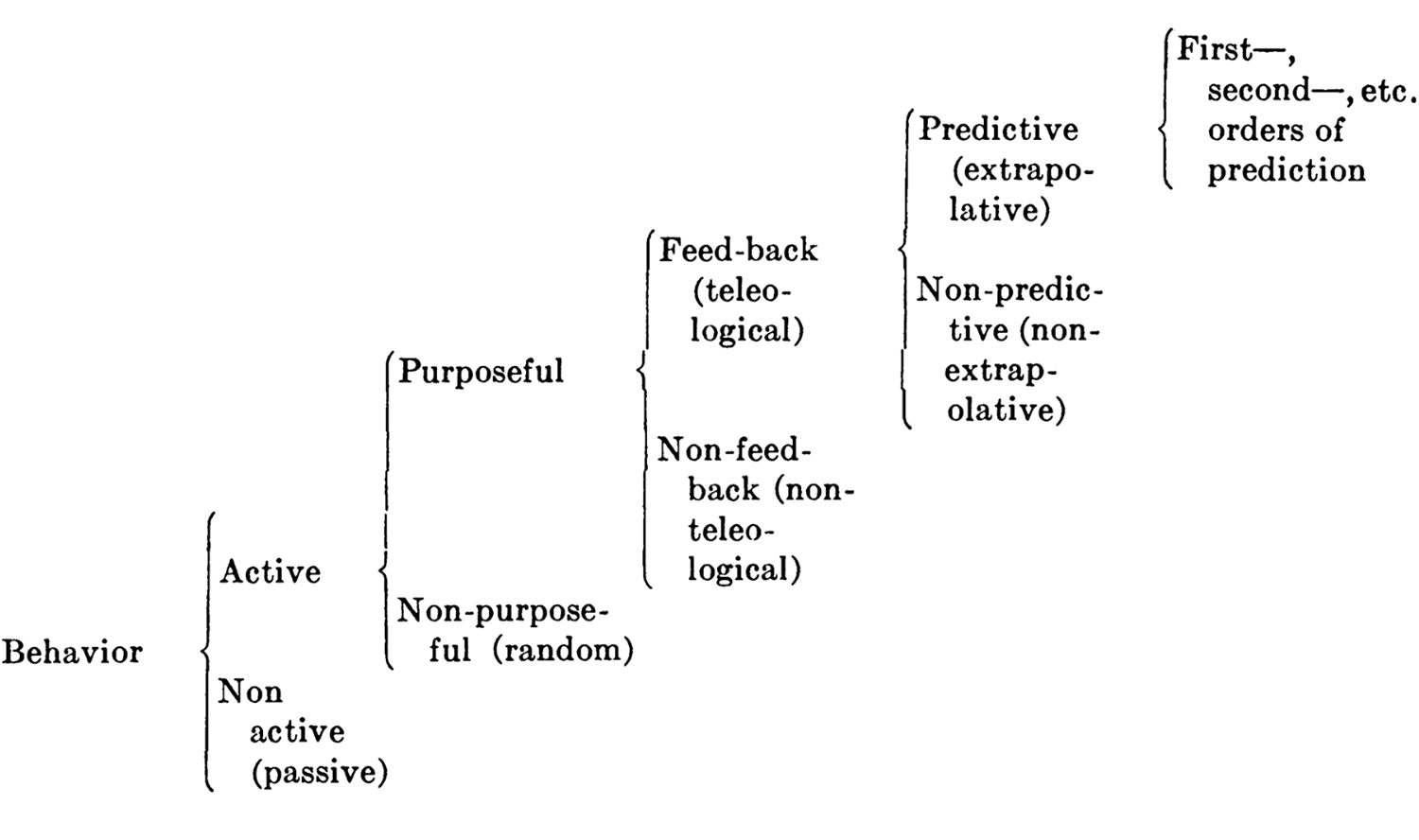

Обобщая это наблюдение в эссе 1943 года под названием «Поведение, цель и телеология», Винер, Розенблют и пионер компьютерных технологий Джулиан Бигелоу прекрасно сформулировали гипотезу «предсказательного мозга» в кибернетических терминах (хотя они не придумали это слово еще несколько лет):

Все целенаправленное [или «телеологическое»] поведение можно рассматривать как требующее негативной обратной связи [которая] может быть экстраполятивной (предсказательной) […]. Кошка, начинающая преследовать бегущую мышь, не бежит прямо к тому месту, где мышь находится в данный момент, а движется к экстраполированной будущей позиции. […] Преследование мыши кошкой — это пример предсказания первого порядка […]. Бросок камня в движущуюся цель требует предсказания второго порядка […].

Вероятно, ограничения […] центральной нервной системы […] определяют сложность предсказательного поведения […]. Действительно, возможно, что […] разрыв [между] людьми [и] другими высокоразвитыми млекопитающими заключается в том, что другие млекопитающие ограничены предсказательным поведением низкого порядка, тогда как человек потенциально способен к предсказаниям гораздо более высокого уровня.

Классификация поведения по Розенблюту, Винеру и Бигелоу, 1943

Авторы также отметили, что с этой точки зрения, сосредоточенной на поведении (то есть не беспокоясь о том, как реализуется предсказательная вычислительная способность), целенаправленные машины и живые системы схожи, «независимо от сложности [их] поведения», добавляя, что «примеры […] легко найти среди машин, созданных человеком, с поведением, которое превосходит человеческое».

Это было верно для машин даже в 1943 году, до появления универсальных вычислительных систем; это было верно даже в 1843 году, иначе не было бы Промышленной революции, хотя немногие машины того времени можно было считать телеологическими или целенаправленными в кибернетическом смысле. Ярким исключением является центробежный регулятор, впервые изобретенный Кристианом Гюйгенсом в семнадцатом веке, а затем адаптированный Джеймсом Уаттом в 1788 году. Версия Уатта контролировала количество пара, поступающего в паровую машину, с помощью клапана, соединенного с вращающимися грузами, приводимыми в движение машиной, создавая отрицательную (или гомеостатическую) обратную связь для регулирования скорости работы двигателя.

Взывая к телеологии, Винер и его коллеги играли с огнем как в философских, так и в научных кругах. Материализм и редукционизм придавали телеологии дурную репутацию, отводя ее в разряд кваси-религиозных убеждений. В конце концов, если, исходя из начальных условий, (совершенно познаваемые) динамические законы физики полностью определяют, что произойдет в следующий момент времени, какую роль может сыграть телеология или целенаправленное действие?

Центробежный регулятор: шары вылетают наружу с увеличением скорости, закрывая дроссель

Помимо определения целей и задач, кибернетика предполагала наличие агентов, которые предсказывают будущее и создают его — тот же самый кажущийся обратный порядок причинности, с которым мы столкнулись в главе 2. Проницательность кибернетиков, одновременно тривиальная и глубокая, заключалась в том, что предсказательные отрицательные обратные связи достаточно, чтобы наделить аппарат (или организм) целенаправленностью... не нарушая законов физики. Например, центробежный регулятор Гюйгенса-Уатта — это простая машина, работа которой полностью описывается ньютоновской физикой. Тем не менее, у нее есть цель: она управляет впускным клапаном парового двигателя, чтобы регулировать его скорость. Делая это, она «создает» причины для достижения будущих эффектов.

Кажущийся парадокс обратной причинности напоминает кажущийся парадокс аппарата (или организма), создающего копию самого себя. В этом случае фон Нейман осознал, что решение заключается в наличии у аппарата внутренней модели своей структуры, которая используется для управления процессом строительства. Винер и его коллеги поняли, что решение их проблемы заключается в наличии у аппарата внутренней модели (части) мира, которая направляет его поведение.

Это две стороны одной и той же медали. В обоих случаях модели являются вычислительными, и в обоих случаях их цель — продолжать существовать во времени, будь то за счет роста, сохранения целостности «я» или репликации.

Фон Нейман и Винер опубликовали свои идеи в течение года друг за другом, хотя в то время интеллектуальная родство между ними могло быть не полностью оценено.

Отрицательная обратная связь

Кибернетика во многом была права, особенно по сравнению с символическим, программным подходом к ИИ, который защищали противники Винера. Для начала: она приняла непрерывные значения и случайные процессы.

Это было основано на изучении (то есть моделировании) распределений вероятностей, а не на выполнении вручную созданного кода, отражающего интуиции программиста.

Это продвигало идею о том, что агентность (или целенаправленность, или телеология) является основополагающей для интеллекта и для жизни в более широком смысле.

Это согласовывалось с нейронаучным консенсусом, который возник вскоре после статьи Маккалоха и Питтса 1943 года, когда стало понятно, что нейроны не реализуют пропозиционную логику, используя булевы значения.

Это сосредоточилось на непрерывности между интеллектом и живыми системами в более общем смысле, а не на представлении интеллекта как чисто логической конструкции в лейбницевской традиции — и, следовательно, как на исключительной прерогативе символически мыслящих людей. В качестве следствия кибернетика предполагает, что летучие мыши, стрекозы и даже бактерии также обладают интеллектом.

Это подчеркивало важность поведения над механизмом, отмечая, что одни и те же модели могут вычисляться совершенно разными способами — например, в стандартных компьютерах, похожих на машины Тьюринга, «в значительной степени за счет временного умножения эффектов» при «частотах в миллион и более в секунду», или в биологических системах — «пространственным умножением», то есть массовым и недетерминированным параллелизмом.

Этот последний пункт может напоминать Б. Ф. Скиннера и радикальный бихевиоризм, школу мысли, которая была подвергнута жесткой критике как чрезмерно редукционистская или как отрицающая существование ментальных состояний.

Справедливая оценка бихевиоризма отвела бы нас слишком далеко, но достаточно сказать, что Винер и его коллеги поднимали вопрос о фундаментально вычислительной природе мозга или разума. Следовательно, его множественная реализуемость или независимость от платформы подкрепляется универсальностью вычислений, согласно Чёрчу и Тьюрингу. Это тот же вид «бихевиоризма», который привел Тьюринга к формулировке Игры в подражание в терминах поведения, вместо того чтобы настаивать на каком-либо конкретном механизме мозга.

Кибернетика также ошибалась в некоторых аспектах. Её главная проблема заключалась в чрезмерных обещаниях: между саморекламной грандиозностью Норберта Винера и инженерной реальностью его времени существовала огромная пропасть. Теория была настолько общей, что почти не поддавалась формулировке, но практические демонстрации с использованием технологий середины двадцатого века оставляли желать лучшего. Винер сам не был особенно хорошим инженером; он чувствовал себя гораздо более комфортно у доски, чем в механической мастерской. Идея кибернетического управления зенитной пушкой, которую он настаивал, что она станет ключевой для военных усилий, так и осталась на уровне концепции.

В 1949 году студенты Винера в MIT собрали моторизованную тележку с колесами, управляемыми обратной связью, основанной на двух фотосенсорах. Подключенная одним способом, она получила имя «Palomilla», что по-испански означает «мотылёк», и могла неуклюже катиться по коридору, более или менее следуя за лучом фонарика. Переподключение проводов превращало её в «клопа», избегавшего света. Увеличение коэффициента обратной связи заставляло её колебаться, как при Паркинсонизме или треморе намерения. Но за пределами узких контуров обратной связи систем управления ракетами (которые выполняли то, что делала «Palomilla», чуть более надёжно) реальные жизненные приложения оставались неуловимыми. Почему же эти демонстрации были такими неубедительными?

Винер мог легко записать функцию обратной связи, которая бы отражала всеобъемлющее поведение организма. Затем он мог бы формально разложить эту функцию в бесконечный ряд более высоких порядков. Он даже мог вывести аналитические решения для линейных частей, если бы перед ним стояла простая задача, как, например, оптимальная игра в догонялки с противником, чьи движения можно было бы анализировать статистически. Однако термины более высокого порядка оставались недоступными.

Взрывной рост числа параметров и сложность характеристики более высоких целей сделали неясным, как можно продвинуться дальше — особенно с учетом скромной вычислительной мощности, доступной на тот момент. Доступ к мощным вычислениям не решил бы проблему сразу, поскольку оставались серьезные концептуальные пробелы. Кибернетики в значительной степени замяли вопросы памяти и обучения, а также все, что касалось индивидуального поведения. Несмотря на высокопарные заявления, то, что кибернетика предлагала на практике, было карикатурой на чисто инстинктивное поведение простого организма, выполняющего одно низкоразмерное сенсомоторное задание в неизменной нише. По сути, это был термостат.

Настоящие моли и клопы обладают гораздо более богатым репертуаром поведения, чем Palomilla. Даже химотактические бактерии имеют его. Эти надоедливые обратные связи были черными ящиками, в которых скрывалась, казалось, бесконечная сложность. В теории более или менее любую функцию можно было бы аппроксимировать с помощью рядового разложения, но на практике было трудно представить, как что-то, напоминающее мысль, восприятие или действие — не говоря уже о психологии или «Я» — могло бы возникнуть просто за счет добавления новых членов в ряд.

Старый добрый ИИ, или GOFAI, основанный на написанных вручную программах вместо кибернетики, возможно, и жульничал, но, по крайней мере, его заготовленные ответы могли быть содержательными. В одном известном примере профессор MIT Джозеф Вайценбаум создал чат-бота по имени ЭЛИЗА, который, обладая скромным набором грамматических правил, мог имитировать сеанс терапии.

▶ Джозеф Вайценбаум и ЭЛИЗА

Год был 1964 — расцвет «центрированной на личности терапии» психолога Карла Роджерса. Роджерс верил в силу пациентов, которые сами разбираются в своих проблемах, и избегал осуждения; он называл это «безусловным положительным отношением». Таким образом, его метод в основном заключался в эмпатическом слушании и поощрении пациента продолжать.

ЭЛИЗА могла приблизиться к такому взаимодействию, используя эвристические методы для угадывания ключевых слов или фраз в диалоге и задавая уточняющие вопросы, или, если сталкивалась с трудностями, прибегая к перефразированию или задавая более общий вопрос. Как выразился Вайценбаум: «Этот способ общения был выбран потому, что психиатрическое интервью — один из немногих примеров […] коммуникации, в которой один из участников может позволить себе вести себя так, будто почти ничего не знает о реальном мире. Если, например, кто-то скажет психиатру: ‘Я долго катался на лодке’, а тот ответит: ‘Расскажи мне о лодках’, никто не подумает, что он ничего не знает о лодках, а скорее, что у него есть какая-то цель в том, чтобы направить […] разговор именно в этом русле».

В статье 1966 года Вайценбаум воспроизвел диалог с ЭЛИЗОЙ, который он описал как «типичный»; ответы машины (заглавными буквами) точны, хотя обмен репликами был отобран, чтобы избежать неудач:

— Все мужчины одинаковы.

— В ЧЕМ ИМЕННО?

— Они всегда донимают нас по какому-то поводу.

— МОЖЕШЬ ПРИВЕСТИ КОНКРЕТНЫЙ ПРИМЕР?

— Ну, мой парень заставил меня прийти сюда.

— ТВОЙ ПАРЕНЬ ЗАСТАВИЛ ТЕБЯ ПРИЙТИ СЮДА.

— Он говорит, что я часто подавлена.

— МНЕ ЖАЛЬ СЛЫШАТЬ, ЧТО ТЫ ПОДАВЛЕНА.

— Это правда. Я несчастна.

— ДУМАЕШЬ, ПРИХОД СЮДА ПОМОЖЕТ ТЕБЕ НЕ БЫТЬ НЕСЧАСТНОЙ?

— Мне нужна помощь, это точно.

— ЧТО БЫ ЭТО ЗНАЧИЛО ДЛЯ ТЕБЯ, ЕСЛИ БЫ ТЫ ПОЛУЧИЛА ПОМОЩЬ?

— Возможно, я могла бы научиться ладить с мамой.

— РАССКАЖИ МНЕ БОЛЬШЕ О СВОЕЙ СЕМЬЕ.

… и так далее.

Трудно утверждать, что несколько сотен стандартных ответов, заполненных словами, предоставленными пользователем, действительно составляют «интеллект». Тем не менее, результаты выглядели гораздо более впечатляюще, чем все, что предлагали кибернетики. А код GOFAI, такой как ЭЛИЗА, работал эффективно даже на самых ранних универсальных компьютерах. Многие исследователи и инженеры не заботились о том, что запрограммированные поведения были хрупкими; они были заняты созданием триллионной индустрии.

Когда финансирование ИИ-грантов прекратилось, они нашли множество других приложений, которые не требовали ничего похожего на когнитивную гибкость. Информатика начала отделяться от ИИ, становясь самостоятельной дисциплиной, в то время как программная инженерия преодолела пропасть от военно-промышленного комплекса к крупному бизнесу, а затем и к домашним компьютерам. Никто не считал свой домашний компьютер хоть сколько-нибудь умным или похожим на мозг, хотя к 1977 году было вполне возможно провести час-другой, вводя программу ELIZA в свой Altair 8800 просто ради смеха.

Тем временем кибернетическая философия становилась всё более мета, и в конечном итоге была принята (иногда лишь как метафора) интеллектуально продвинутыми людьми в таких областях, как: государственное управление, антропология, экология, городское планирование, сексология, феминизм, и постструктуралистская критическая теория.

Некоторые кибернетически вдохновленные произведения по-прежнему читаются с интересом, некоторые имели правильные идеи, а некоторые оказали значительное влияние в своих областях. Но в отличие от мейнстримной информатики, ни одно из них не сопровождалось значительным техническим прогрессом в самой кибернетике. Концепция «киборга», кибернетически вдохновленного сверхчеловека, слияния человека и машины (да, обычно человека), из серьезного приоритета исследований в передовых оборонных лабораториях превратилась в комиксный троп.

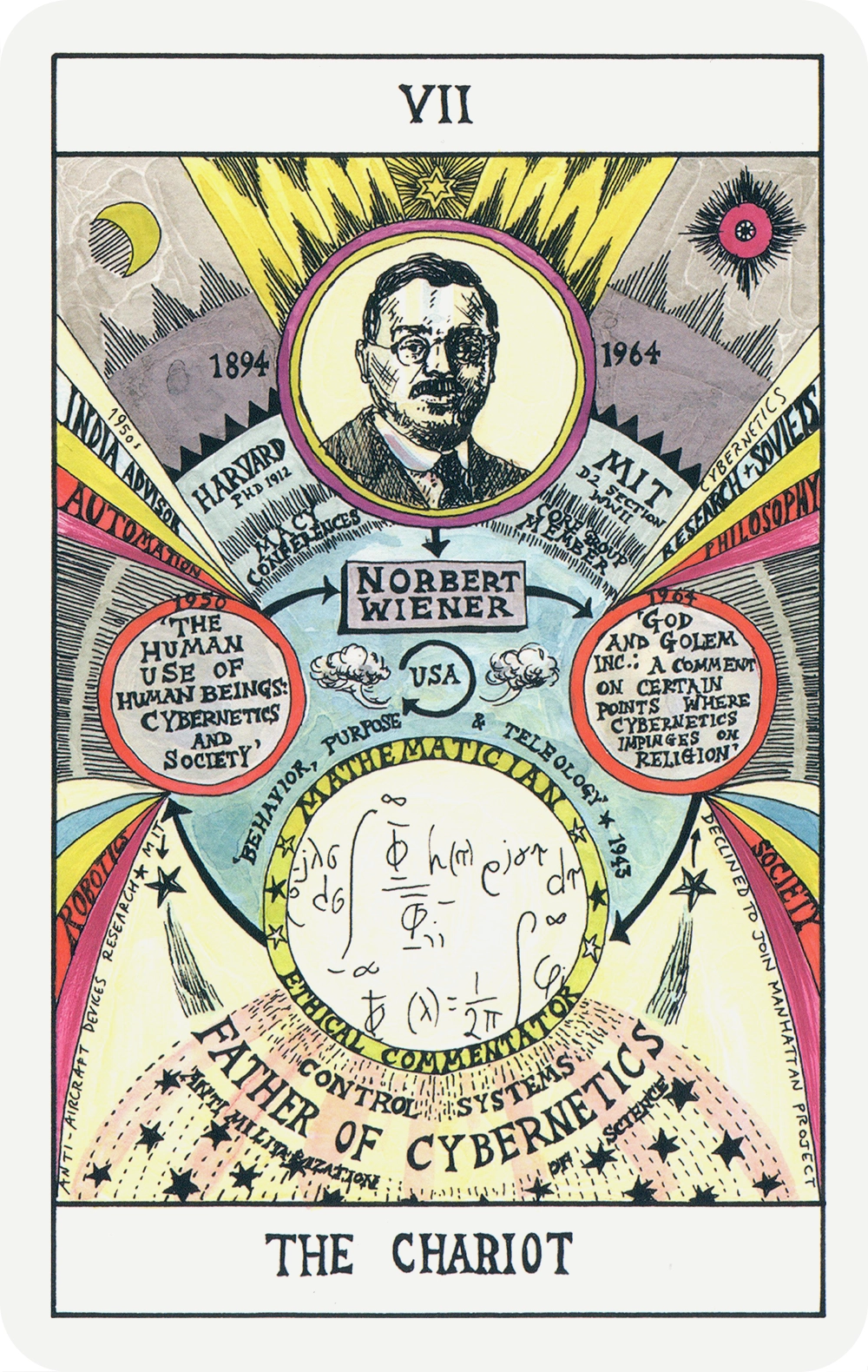

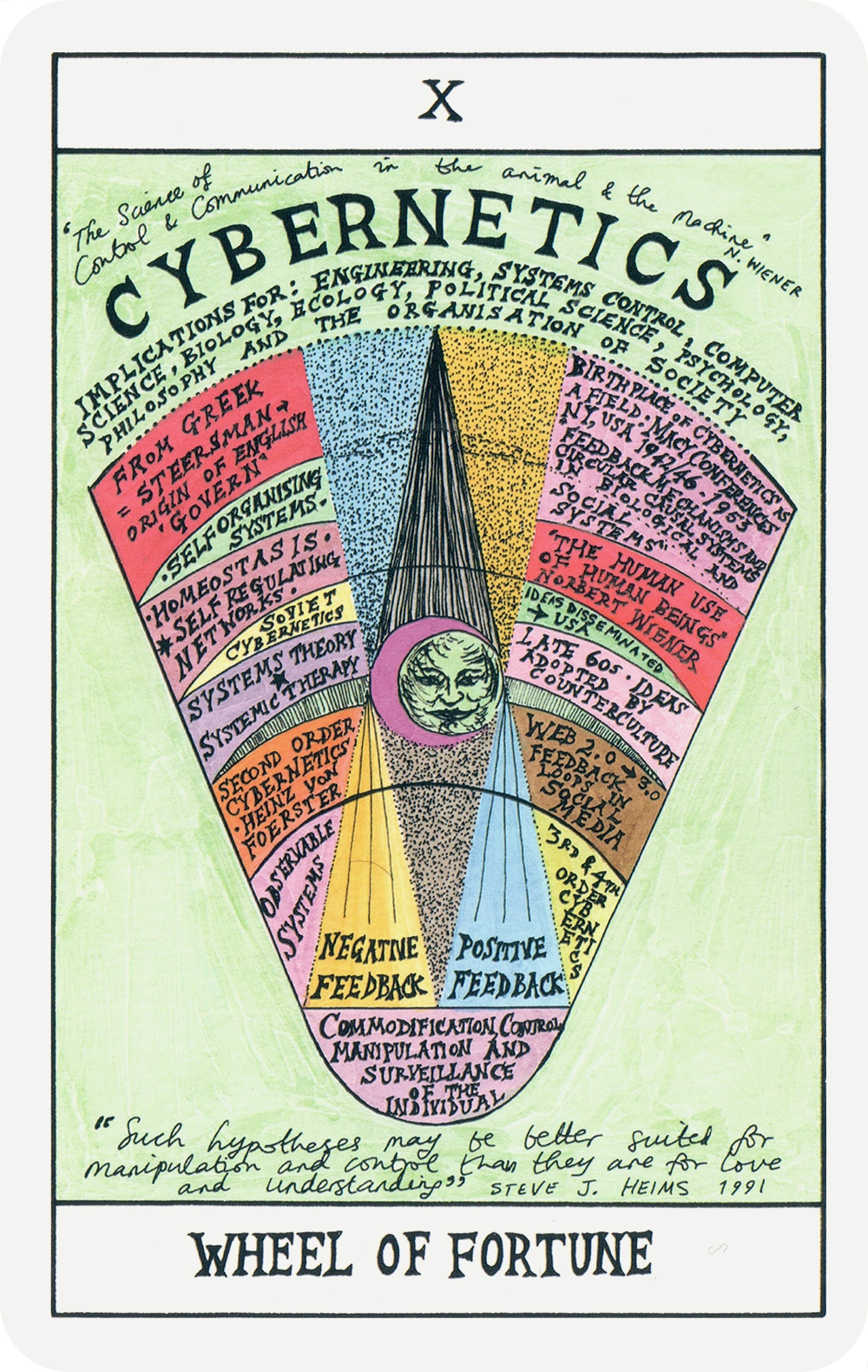

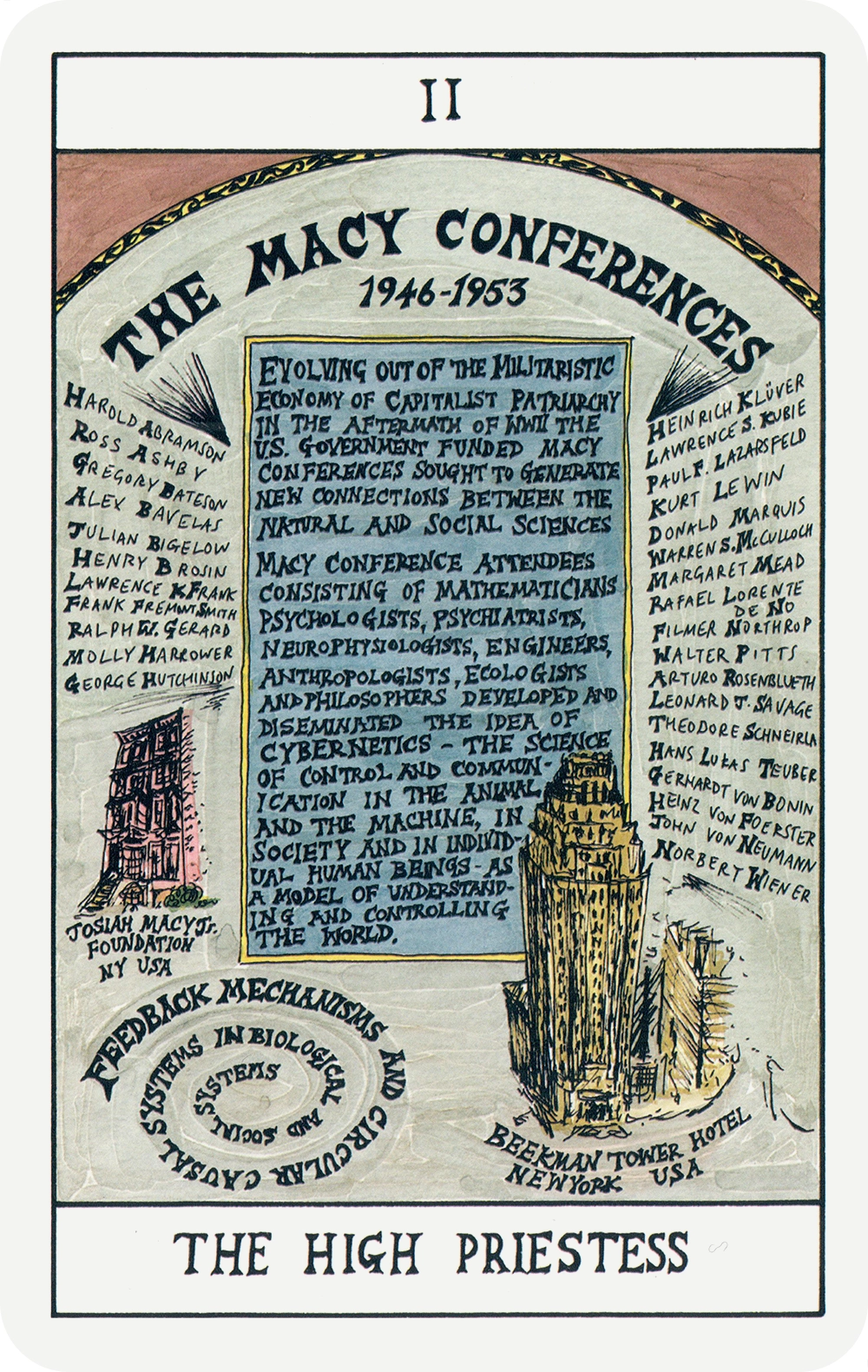

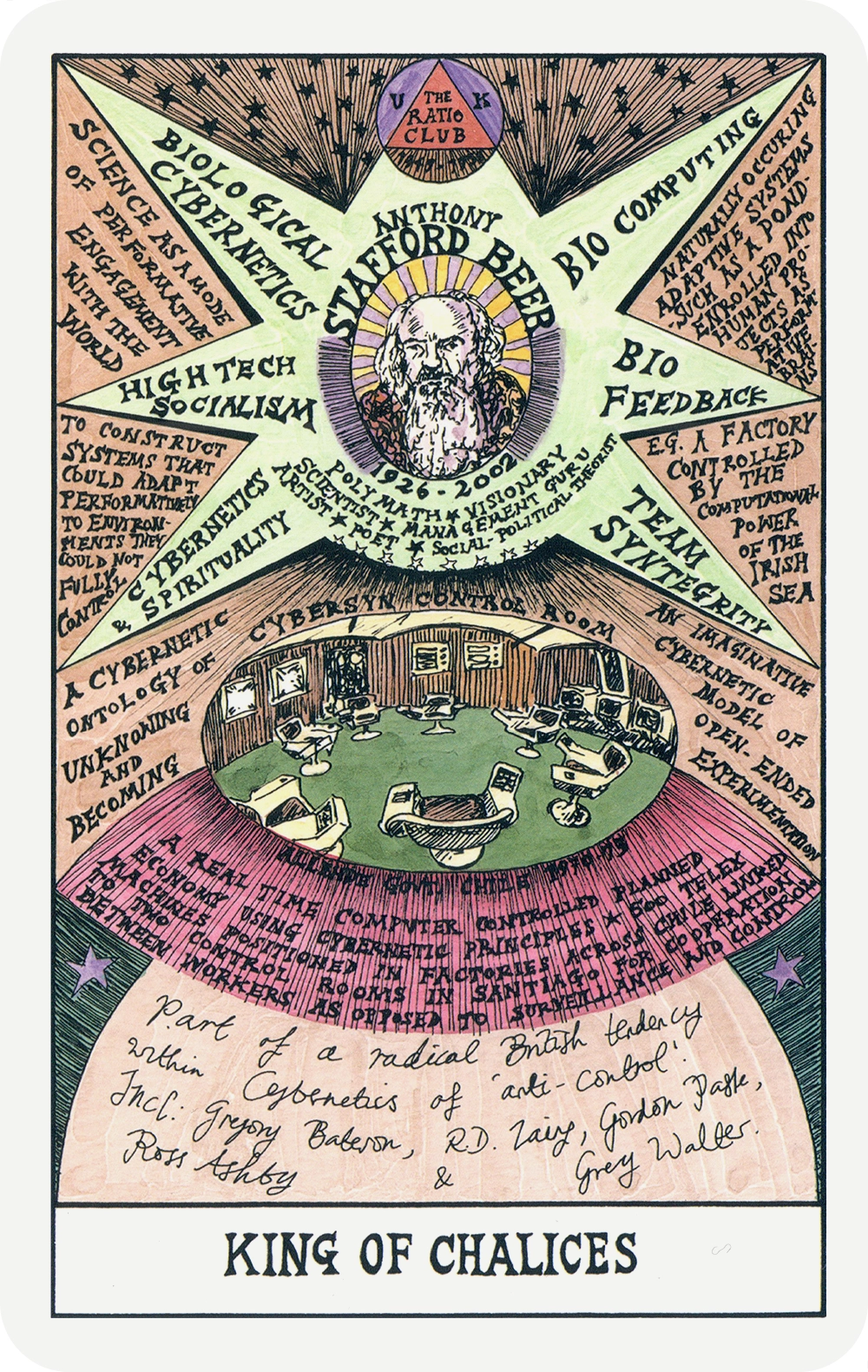

Выбранные карты из кибернетического таро Hexen 2.0 Сюзанны Трейстер, 2013

Выбранные карты из кибернетического таро Hexen 2.0 Сюзанны Трейстер, 2013

Выбранные карты из кибернетического таро Hexen 2.0 Сюзанны Трейстер, 2013

Выбранные карты из кибернетического таро Hexen 2.0 Сюзанны Трейстер, 2013

Выбранные карты из кибернетического таро Hexen 2.0 Сюзанны Трейстер, 2013

Другими словами, кибернетика начала выглядеть как мода.

Даже к середине 1960-х годов кибернетика в значительной степени утратила статус активной области исследований, хотя название сохранилось в виде таких терминов, как «киберпространство», «кибербезопасность», «киберпреступность» и «кибервойна».

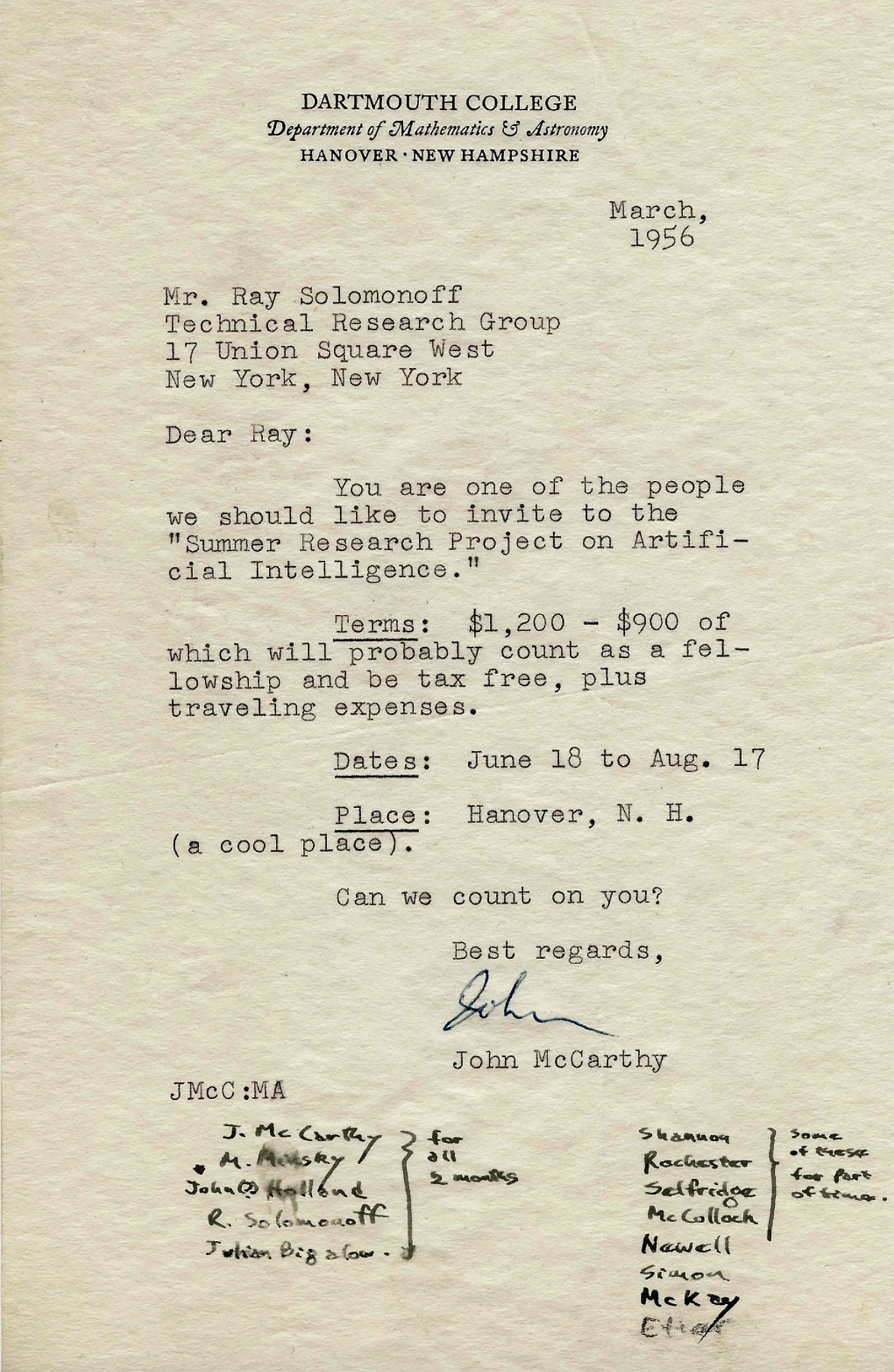

Групповое фото участников Летнего исследовательского проекта по искусственному интеллекту в Дартмуте в 1956 году. Задний ряд, слева направо: Оливер Селфридж, Натан Рочестер, Марвин Минский и Джон Макафи. Передний ряд: Рэй Соломонофф, Питер Милнер и Клод Шеннон.

Кибернетика стала жертвой не только чрезмерных амбиций, но и систематических усилий своих противников.

В 1955 году компьютерный ученый Джон Макафи ввел термин «Искусственный интеллект» в предложении о летнем семинаре в Дартмуте — именно для того, чтобы отличить новый символический (так называемый GOFAI) подход от кибернетики. Несмотря на обещание «значительного прогресса» за два месяца, на самом семинаре было сделано немного успехов, но его участники, включая Артура Самуэля, Аллена Ньюэлла, Герберта Саймона и Марвина Минского, стали знаковыми фигурами в области ИИ на следующие несколько десятилетий. Винер, к слову, на семинар не был приглашен.

Приглашение Рэя Соломоноффа на Летний исследовательский проект в Дартмуте в марте 1956 года от Джона Макафи.

Иронично, что мы продолжаем использовать термин «Искусственный интеллект», учитывая, что сегодня практически вся область происходит от того рода работ, которые создатели этой фразы стремились дискредитировать — особенно, по словам философа Хьюберта Дрейфуса, «перцептроны, предложенные группой, которую Минский отвергает как ранних кибернетиков».

Это были первые искусственные нейронные сети.

Как мы знаем универсалии

Ранняя концепция ассоциативной нейронной сети от Уильяма Джеймса, 1890 год

Вдохновленный физической структурой мозга, выдающийся американский психолог Уильям Джеймс (1842–1910) еще в 1890 году представил нечто очень похожее на нейронные сети. В своем основополагающем учебнике «Принципы психологии» Джеймс предположил, что нейронные процессы — эти мельчайшие «провода», заметные в окрашенных образцах тканей коры головного мозга — могут физически воплощать ассоциации между одновременно возникающими стимулами.

▶

Фрагмент экспериментального фильма Алексиса Гамбиса, основанного на анатомических иллюстрациях Сантьяго Рамона и Кахаля

Вскоре после этого великий испанский нейроанатом Сантьяго Рамон и Кахаль (1852–1934) пришел к выводу, что эта проводка не является «ретикулярной» (то есть непрерывной), а состоит из разветвлений отдельных нейронов. Под влиянием Джеймса Рамон и Кахаль предложил, что соединения между нейронами, которые мы теперь называем синапсами, являются местами нейропластичности. Ассоциации могут быть выучены (или разучены) через избирательное усиление (или ослабление) синапсов.

Идея о том, что умственные ассоциации играют центральную роль в обученном поведении, имеет свою долгую историю. В 1897 году Иван Павлов (1849–1936) опубликовал свои классические эксперименты, в которых собаки были обучены ассоциировать пищу со звуком музыкального треугольника. После conditioning они начали слюноотделение, когда треугольник звучал.

▶

Исторические кадры церемонии вручения Нобелевской премии Ивану Павлову и экспериментов по кондиционированию собак, демонстрирующие слюноотделение в ответ на стимулы, связанные с пищей

Обучение ассоциациям даже более фундаментально, чем предполагают такие поведенческие эксперименты. Собаки не рождаются с отдельными нейронами, которые активируются исключительно при вкусе или запахе пищи, при виде конкретного человека или при звуке треугольника. Ассоциировать эти многомодальные события друг с другом — это простая часть.

Не обладая способностью улавливать тонкие и сложные ассоциации между сырыми стимулами, собака не смогла бы распознать ни человека, ни звенящий треугольник.

МакКаллох и Питтс сформулировали эту проблему в своей статье 1947 года «Как мы знаем универсалии: восприятие слуховых и визуальных форм».

Их теория (снова) оказалась неверной, но вопрос, поставленный в заголовке статьи, очень уместен: как мы распознаем категории или «универсалии»? Четыре года спустя после публикации «Логического исчисления идей, присущих нервной активности» эксперименты убедили их в том, что нейроны не являются логическими воротами, хотя и обменивались возбуждающими и тормозящими сигналами. Исследователи также поняли, что одной из самых сложных вычислительных задач, стоящих перед мозгом, является достижение «перцептивной инвариантности» — ключа к тому, что мы сейчас называем «классификацией», «распознаванием» или, более широко, «обобщением». МакКаллох и Питтс пытались выяснить, как анатомически правдоподобные нейронные схемы в сенсорной коре могут это осуществить.

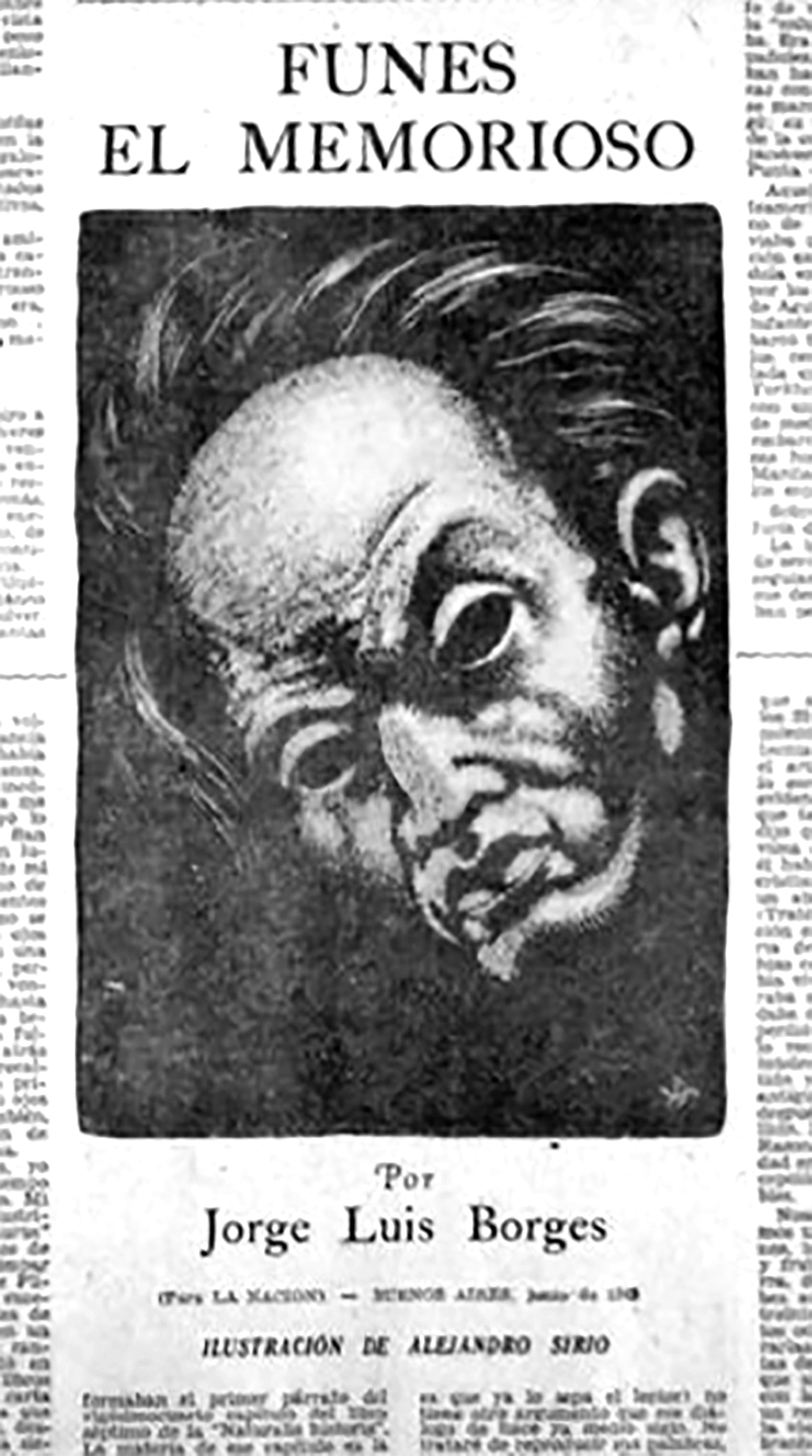

Третья страница раздела Искусства и Литературы газеты La Nación от 7 июня 1942 года, где впервые была опубликована «Фунес, памятливый».

Перцептивная инвариантность иллюстрируется проницательным коротким рассказом «Фунес, памятливый», опубликованным Хорхе Луисом Борхесом в 1942 году.

В рассказе Борхеса молодой человек по имени Иренео Фунес падает с лошади и получает тяжелую травму головы. Это оставляет его с идеальной памятью, но лишает способности обобщать. После несчастного случая Фунес может помнить «не только каждую листочку каждого дерева каждого леса, но и каждое мгновение, когда он его воспринимал или представлял»; однако его описывают как «[…] почти неспособного к идеям общего, платоновского рода».

Не только ему трудно понять, что общее обозначение «собака» охватывает стольких разных индивидуумов с разнообразными размерами и формами; его также беспокоит, что собака в три четырнадцать (вид сбоку) должна носить то же имя, что и собака в три пятнадцать (вид спереди).

Долгое время машины не справлялись лучше. На протяжении всего двадцатого века и вплоть до двадцать первого технологии памяти развивались с экспоненциальной скоростью, но проблема перцептивной инвариантности оставалась неразрешенной. Участники летней школы по искусственному интеллекту в 1956 году не добились успеха, и когда те, кто остался в живых через пятьдесят лет, вернулись в Дартмут на встречу выпускников, мало что изменилось. Компьютер мог, как Фунес, «запомнить» цвет каждого пикселя в двухчасовом фильме, но не мог осмыслить десятки миллиардов этих пикселей. Поэтому боты легко могли провалить визуальные тесты Тьюринга, такие простые, как «кликните на изображения ниже, содержащие собаку».

Собравшиеся снова волшебники, поседевшие, но по-прежнему настойчивые в своих мнениях, имели разные идеи о том, что попробовать дальше, но все согласились, что до искусственного интеллекта еще далеко.

Тренчард Мор, Джон Макафи, Марвин Минский, Оливер Селфридж и Рэй Соломонов, оставшиеся участники Летнего исследовательского проекта в Дартмуте 1956 года, снова собрались в Дартмуте в 2006 году.

Год был 2006. Они не могли ошибаться больше.

Перцептроны

Решение скрывалось на виду более ста лет. На рубеже двадцатого века Уильям Джеймс и Сантьяго Рамон и Кахаль уже точно описали, как мозг должен учиться ассоциациям. Когда экспериментаторы начали выходить за рамки диссекции и окраски тканей, чтобы изучать живой мозг в действии, стало яснее, как происходит нейронная обработка информации.

В серии статей, начавшихся в 1950-х годах, нейробиологи Дэвид Хабель, Торстен Визел и меняющийся состав их соавторов представили результаты кропотливых исследований зрительной коры кошек и обезьян.

Пока они демонстрировали визуальные стимулы животным под анестезией, они записывали активность отдельных нейронов с помощью вольфрамовых электродов. Они обнаружили, что «ретинальные ганглиозные клетки», которые объединяют сигналы от фоторецепторов в сетчатке для создания локальных визуальных признаков, являются лишь первой стадией в иерархии визуальной обработки. В мозге эти признаки, в свою очередь, комбинируются для формирования более высокоуровневых признаков, напоминающих контуры, «простыми клетками», которые сами объединяются для создания еще более сложных признаков «комплексными клетками», которые в свою очередь формируют «гиперкомплексные клетки» — пока в конечном итоге эти признаки не могут представлять собой целые объекты.

▶ Эксперименты Хабеля и Визела по исследованию зрительной системы кошек в 1950-х годах

Маргарет Ливингстон, нейробиолог из Гарварда, которая проходила постдокторантуру в лаборатории Хабеля, написала в его некрологе в 2013 году: «Изучать зрение — это увлекательно, потому что ты видишь то, что показываешь животному, а когда не можешь понять, как работает клетка, ты показываешь ей все, что только можешь придумать; иногда ты находишь удивительно специфические вещи, которые заставляют клетку реагировать, например, ярко-желтую коробку от пленки Kodak».

Иерархическое распознавание — это элегантная концепция: любая задача по перцептивной классификации, независимо от сложности, может быть построена как комбинация признаков, которые сами являются комбинациями признаков — черепахи до бесконечности. Это, похоже, был подход мозга к обобщению.

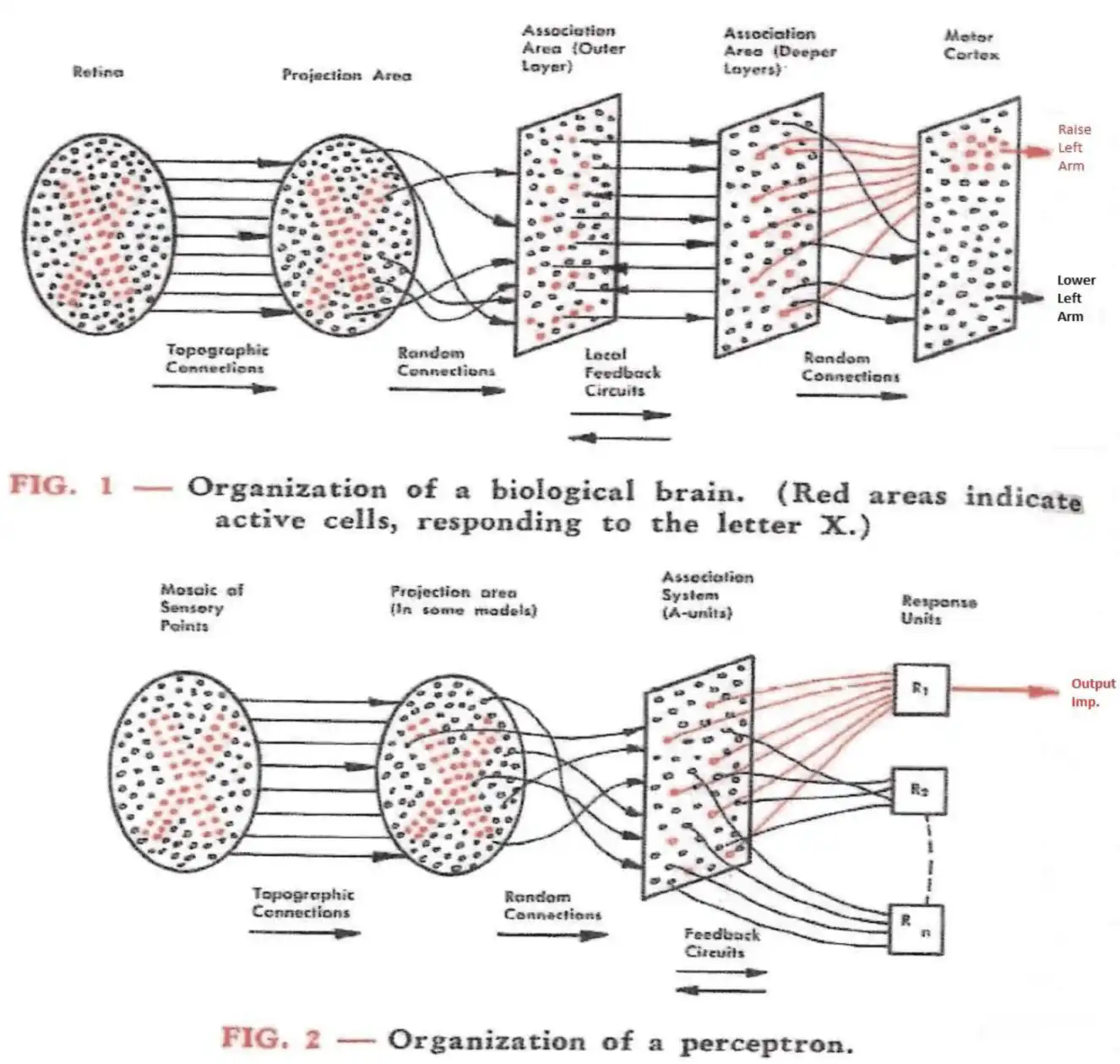

В 1957 году Франк Розенблат, молодой инженер в Корнеллской аэрокосмической лаборатории, решил создать устройство, которое выполняло бы функции зрительной коры. Он назвал его «перцептрон».

Как он написал во введении к своему отчету: «[Д]олжно быть, возможно создать электронную или электромеханическую систему, которая научится распознавать сходства или идентичности между паттернами оптической, электрической или тональной информации, подобно тем процессам восприятия, которые происходят в биологическом мозге».

Фрэнк Розенблат (слева) и инженер Чарльз Уайтман (справа) работают над моторизованным потенциометром для перцептрона в декабре 1958 года.

В отрывке, напоминающем произведения Борхеса, Розенблат отметил, что хотя «[р]аспознавание ‘схожих’ форм может быть выполнено, в определенной степени, аналитическими процедурами на […] компьютере […] трудно представить себе общую аналитическую программу, которая бы […] распознавала форму человека, видимого с любого угла и в любой позе или положении, не храня при этом обширную библиотеку эталонных фигур […]. В общем, такие идентичности должны быть изучены или приобретены на основе опыта […].»

«Идентичности» Розенблата были теми же, что и «универсалы» МаКкалоха и Питтса, упомянутые за десять лет до этого. Однако, в отличие от МаКкалоха и Питтса, Розенблат создал реальную, работающую систему.

Первоначальный перцептрон Mark I представлял собой трехслойную нейронную сеть. Первый слой состоял из массива фотоприемников 20×20, или «сенсорных единиц», второй слой имел 512 «ассоциативных единиц», а последний слой включал восемь «единиц ответа». Каждый слой был случайным образом соединен с последующим, а моторизованный потенциометр (похожий на ручку громкости на радио) регулировал силу каждого соединения.

Диаграмма, сравнивающая предполагаемую организацию визуальной системы мозга (вверху) и перцептрона (внизу), из работы Розенблата 1958 года.

Единицы ответа также реализовывали «боковое торможение», функцию, обычно встречающуюся в нейронных цепях: когда одна из них активировалась, она тормозила другие, которые, в свою очередь, возвращали торможение на любые конкурирующие ассоциативные единицы.

Используя простое правило обучения, основанное на обратной связи, Розенблатт заставил устройство различать простые формы — квадрат, круг, треугольник. Это было только начало.

Но более чем просто начало: в ретроспективе перцептрон можно считать, пожалуй, самым значительным достижением в области ИИ XX века. Современные нейронные сети, особенно те, которые чаще всего используются для визуального распознавания, по-прежнему основаны на «многослойных перцептронах» (MLP), хотя они применяют другие правила обучения и, как правило, гораздо глубже — то есть имеют намного больше трех слоев.

▶ Перцептрон 1960-х годов, пытающийся научиться классифицировать пол по фотографии

Если перцептроны работали — и делали это, принимая подход, гораздо более очевидно схожий с работой мозга, чем символические системы ИИ — то почему они оставались в забвении так долго? У этой истории есть несколько обоснованных версий:

Большие нейронные сети, способные выполнять практическую работу, требуют масштабных параллельных вычислений, которые стали доступны большинству исследователей только с появлением недорогих графических процессоров (GPU) на рынке, примерно в 2006 году. Это правда; однако, если бы мы начали серьезно разрабатывать параллельные нейронные компьютеры или специализированное оборудование, подобное Mark I, начиная с 1960-х годов, мы, вероятно, могли бы получить мощные MLP уже к 1980-м. Инженеры не стремились двигаться в этом направлении, потому что закон Мура неуклонно развивался на протяжении шести десятилетий после изобретения транзистора в 1947 году, уменьшая их размеры, увеличивая максимальную тактовую частоту и снижая потребляемую мощность. Индустрия стремилась извлечь самые очевидные преимущества — сделать весь компьютер меньше, быстрее, дешевле и менее энергоемким — а не жертвовать этими преимуществами ради увеличения параллелизма в пользу непроверенного подхода к вычислениям.

Большие нейронные сети требуют больших наборов данных для обучения, которые не были доступны до того, как интернет начал развиваться.

И размеченные наборы данных, такие как ImageNet (сбор которого исследователь Фей-Фей Ли начал в 2006 году — снова этот год!), полагались не только на масштабные интернет-коллекции изображений, но и на онлайн-работников, которые добавляли метки, такие как «чихуахуа» и «черника». Это правда, но давайте вспомним, что Netflix начал отправлять подписчикам цифровые фильмы на DVD почти за десятилетие до этого, и даже скромная коллекция DVD содержит гораздо больше изображений, чем ImageNet. Пикселей было в избытке. Мы также знаем, что обучение без учителя работает эффективно, что делает обширную разметку ненужной (об этом будет рассказано в следующей главе). Это, вероятно, было бы открыто десятилетиями ранее, если бы исследования нейронных сетей оставались на пике популярности во второй половине двадцатого века.

В 2016 году в интернете начали циркулировать сетки изображений, на которых изображены либо чихуахуа, либо кексы с черникой; изначально их визуальное сходство стало проблемой для CNN. Оригинальный алгоритм обучения перцептрона Розенблатта не был достаточно мощным для работы с комплексными наборами данных или глубокими нейронными сетями; набор приемов, необходимых для этого, был усовершенствован лишь в последние годы. Однако самый важный из этих приемов — алгоритм «обратного распространения», позволяющий настраивать веса синапсов, или «синаптические веса», в произвольно глубокой нейронной сети для минимизации ошибки вывода — был разработан еще в 1970 году и многократно переосмыслялся другими исследователями на протяжении лет.

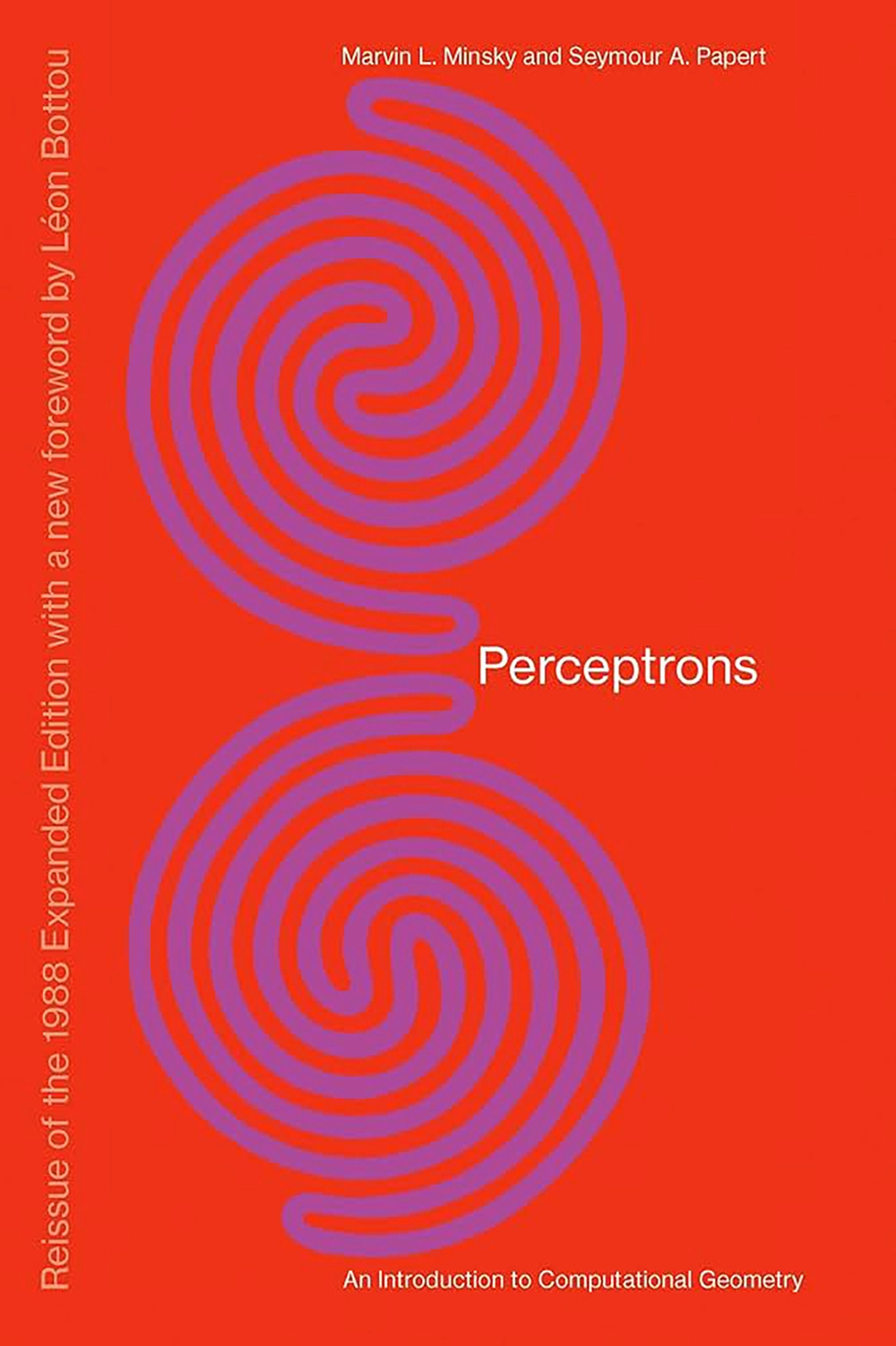

Как и любая технология, для достижения нужных деталей требуется целеустремленное усердие. На протяжении многих лет просто не хватало преданных делу изобретателей, работающих над этим, отчасти потому что — в 1969 году Марвин Минский и его коллега из MIT, Сеймур Паперт, опубликовали высоко цитируемую книгу под названием «Перцептроны».

Хотя книга была посвящена Розенблатту, она оказалась настоящей атакой, подразумевающей, что перцептроны никогда не смогут аппроксимировать ряд простых математических функций, и, следовательно, перцептроны изначально были гораздо слабее с точки зрения вычислений, чем алгоритмы GOFAI. В книге содержались математические доказательства этих утверждений, но они касались лишь упрощенных моделей с двумя слоями. Можно показать, что с тремя или более слоями (как даже в перцептроне Mark I) любую непрерывную функцию можно аппроксимировать, как, похоже, сам Розенблат и предчувствовал.

Обложка книги

Перцептроны,

авторы Минский и Паперт. (издание 1972 года, ©MIT. Все права защищены.) Авторы указали, что перцептрон не может различать определенные глобальные визуальные признаки, такие как разница между верхней фигурой, состоящей из одной фиолетовой петли, и нижней фигурой, состоящей из двух фиолетовых петель. Интересно, что и человек не может сделать это с первого взгляда.

Несмотря на протесты Розенблатта и его сторонников, книга

Перцептроны

оказала значительное влияние на сдерживание «коннекционизма», как тогда называли исследования нейронных сетей, на десятилетия, отвлекая основное внимание на подходы GOFAI, которые предпочитали Минский, Паперт и их коллеги. В 1988 году, когда интерес к нейронным сетям снова начал расти, как раз в момент, когда мы входили в последний период «старого доброго ИИ», Минский и Паперт переиздали

Перцептроны.

В новом предисловии и эпилоге обновленное издание еще раз подтвердило их первоначальную критику, заявив, что «в этой области произошло мало значимого» и что даже к 1969 году «прогресс фактически остановился из-за отсутствия адекватных базовых теорий».

Эти утверждения кажутся странными, если не лицемерными. Всего за год до второго издания

Перцептронов

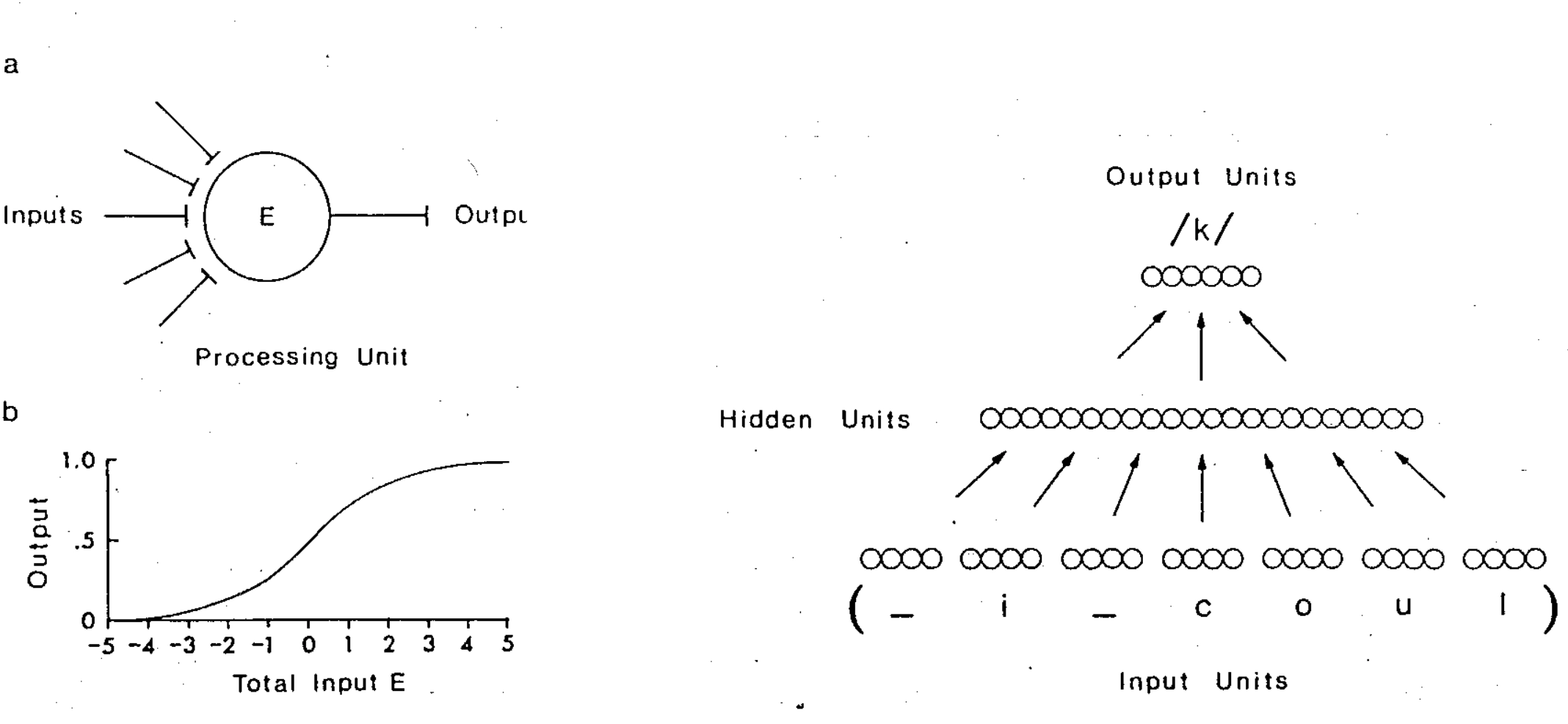

вычислительные нейробиологи Терри Сейнжовски и Чарльз Розенберг обучили нейронную сеть NETtalk произносить английский текст.

Они продемонстрировали не только то, что эта система может эффективно справляться с этой notoriously unruly (то есть не подходящей для GOFAI) задачей, но и то, что ее работа проявляет множество человеческих характеристик.

Проект искусственной нейронной сети NETtalk для перевода последовательностей английских букв в фонемы, Сейнолски и Розенблат, 1986

Возражения Минского и Паперта против коннекционизма имеют определенный смысл, учитывая теоретические основы, которые они надеялись получить от ИИ. Их не интересовали стремительные достижения в области вычислительной нейробиологии, машинного обучения или общей аппроксимации функций. Вместо этого они сосредоточились на математических теориях представления знаний, манипуляций и формальных доказательств в традиции Лейбница. Это требовало работы на уровне абстрактных понятий, больше похожих на «психоны», о которых спекулировали МакКаллох и Питтс в 1943 году (но которые вскоре были оставлены нейробиологией, так и не найдя подтверждения в мозге). По словам Минского и Паперта: «перцептроны не могли представлять знания, необходимые для решения определенных задач. […] Никакая машина не может научиться распознавать X, если у нее нет, по крайней мере потенциально, какой-либо схемы для представления X».

Иными словами, они хотели, чтобы знания представлялись логически, в терминах четких таксономий и семантических отношений — так, как это представлял себе Лейбниц. И такие логические представления, по их мнению, должны были выглядеть как булевы переменные, представляющие «да» или «нет» где-то конкретно в мозге. Без таких «схематизированных» и «локализованных» представлений знаний Минский и Паперт не верили, что возможно высшее рациональное мышление, включая причинное рассуждение, саморефлексию или даже сознание: «[Мы] ожидаем, что распределенные представления будут иметь тенденцию создавать системы с лишь ограниченными способностями точно отражать, как они делают то, что делают».

Размышления о размышлениях, как мы утверждаем, требуют использования представлений, которые достаточно локализованы, чтобы их можно было разбирать и перестраивать. […] [Р]аспределенные представления […] должны иметь свою цену; несомненно, многие из них становятся «концептуальными тупиками».

В отличие от доказательств в книге, эти утверждения были лишь интуициями. Для многих они казались разумными в то время. Приверженцы школы GOFAI, включая многих, обученных лингвистике (которая в основном занимается схемами представления знаний), продолжают отстаивать эту позицию и сегодня, хотя она кажется все более disconnected от реальности, учитывая, на что способны современные нейронные сети и как они это делают.

Глубокое обучение

Обучение многослойных перцептронов сложно как из-за зависимостей между слоями (изменение синаптического веса влияет на все последующие уровни), так и из-за драматически увеличившихся размеров этих моделей. Чтобы понять это, представьте, что двухслойный «полносвязный» перцептрон, классифицирующий изображение размером 32×32 пикселя как одну из десяти цифр, уже имеет (32×32)×10=10,240 синапсов — то есть синапс соединяет каждый пиксель с каждым из десяти выходных нейронов. Если мы добавим один дополнительный слой нейронов размером 32×32 между входным и выходным слоями, то у нас теперь будет (32×32)×(32×32) + (32×32)×10=1,058,816 синапсов. Каждый из этих синаптических весов является параметром модели, который необходимо обучить на данных, и, грубо говоря, для подгонки в сто раз большего количества параметров требуется в сто раз больше данных.

Со временем, однако, исследователи нашли способы обойти эти проблемы. История современного «глубокого обучения» — это просто история накопления этих приемов с течением времени, с нарастающими преимуществами и ускорением прогресса, когда область наконец привлекла серьезное внимание и инвестиции. Вот несколько представительных достижений.

Полный список был бы гораздо длиннее: разреженная связь, восходящая к перцептрону Розенблатта, может значительно сократить количество весов по сравнению с «полностью связанным» слоем, как было описано выше; это делает разреженные сети более быстрыми в обучении и надежными. В 1980-х годах Ян Лекун, Джон Денкер и Сара Солла, работавшие тогда в Bell Labs, нашли способ более обоснованно обрезать ненужные веса.

Глубокое обучение само по себе является формой разреженной связи, если учесть, что по-настоящему полностью связанная нейронная сеть не имела бы слоев вообще; каждый нейрон был бы соединен с каждым другим нейроном. Однако в многослойном перцептроне нейрон соединен только с нейронами предыдущего и следующего слоев. Следовательно, чем глубже сеть, тем разреженнее ее связь по сравнению с полностью связанной сетью с тем же количеством нейронов. В середине 2010-х годов исследователи довели эту форму разреженности до крайностей, исследуя архитектуры с до тысячи слоев.

«Сверточные слои», впервые задуманные исследователем ИИ Кунихико Фукусимой и далее развиваемые Лекуном и его коллегами, реализуют еще одну форму разреженной связи, соединяя нейрон только с небольшой окрестностью нейронов в предыдущем слое, а не со всеми; кроме того, целый «канал» нейронов делит общую схему весов в этой локальной области, что делает количество параметров для обучения значительно меньшим, чем количество соединений.

Алгоритм обратного распространения ошибки, как упоминалось ранее, позволяет надежно минимизировать ошибку или «функцию потерь» через множество слоев нейронов. Он включает использование математического анализа для вычисления общего downstream-эффекта от изменения любого заданного синаптического веса. Практически все современные методы машинного обучения используют обратное распространение.

Функция «softmax», применяемая к слою нейронов, реализует нечто аналогичное латеральной ингибиции, выделяя максимальную активацию и усиливая её, подавляя при этом конкурирующие нейроны, при этом заставляя общую активность слоя суммироваться в единицу. Изначально softmax использовалась только для выходного слоя классификаторов, которые обучаются по принципу «one-hot» (один нейрон активен, остальные выключены). Однако подавление конкурирующих активаций не является полным (отсюда и «soft»), что позволяет обучению через обратное распространение ошибки работать.

«Max pooling» может отбрасывать ненужное разрешение, например, уменьшая слой признаков 32×32 до слоя 16×16, выбирая только наибольшие значения в каждой 2×2 области для передачи дальше. Это работает, потому что наличие сложных признаков зачастую важнее их точного расположения.

Наборы данных могут быть «увеличены» за счёт сдвига, растяжения и вращения тренировочных примеров, а затем использования этих искажённых копий в качестве дополнительных данных для обучения. Это помогает укрепить перцептивную инвариантность нейронной сети.

▶ Кунихико Фукушима и его коллеги представляют свой Неокогнитрон 1979 года

Важно отметить, что исследователи, работающие на пересечении компьютерных наук и нейробиологии, стали пионерами многих из этих техник. В последние годы это слияние дисциплин стало называться «NeuroAI», и под этим флагом было проведено множество конференций и семинаров.

Хотя название новое, само явление — нет. С самого начала машинное обучение и нейробиология были тесно связаны друг с другом, как мы уже видели. На протяжении многих лет научная ценность этой междисциплинарной работы превышала её технологическую ценность, поэтому её часто называли «вычислительной нейробиологией». С тех пор как технологическая сторона стала доминировать, неудивительно, что порядок поменялся на «NeuroAI». Но участники конференций в значительной степени остаются теми же.

Хотя ни одна из практических уловок машинного обучения не может точно смоделировать какой-либо конкретный процесс или цепь в мозге, многие из этих приемов явно вдохновлены биологией, так же как и оригинальный перцептрон.

Используя такие приемы в комбинации, исследователи полностью решили задачу распознавания рукописных одиночных цифр в 1990-х годах и перешли к все более сложным задачам визуального распознавания в течение следующих двух десятилетий: объекты, одежда, места, растения и животные, природные сцены, лица и, в конечном итоге, почти все, с чем можно столкнуться, просматривая фотографии на телефоне. Хотя они в основном разрабатывались для визуальной модальности, сверточные сети также хорошо работают во многих других областях, от аудиораспознавания до прогнозирования погоды. Удивительно, но они даже подходят для классификации текста, но мы отложим изучение нейронных сетей для языка до главы 8.

Закрывая круг

Прежде чем двигаться дальше, давайте рассмотрим нейронные сети через кибернетическую призму. С одной стороны, перцептрон действительно генерировал дискретный символический выход — согласно отчету Розенблатта 1957 года, «инHIBИТОРНЫЕ обратные связи гарантируют, что только один ответ из взаимно исключающего набора может быть вызван в одно время... [Ответные] единицы таким образом [действуют] как многостабильный триггер». (В современных нейронных сетях слои softmax выполняют ту же функцию.) Тем не менее, сторонники GOFAI, такие как Мински и Паперт, понимали, что Розенблат работал строго в рамках кибернетической традиции, и, действительно, слой ответа и правило обучения лишь приближали цифровую логику в выходе с помощью аналоговых отрицательных обратных связей. Система обучалась на примерах и полагалась на это аналоговое качество. Нейронные представления внутри сети были распределенными и непрерывными, а не локализованными или символическими. Синаптические веса были непрерывными, и перцептрон в целом оценивал нелинейную непрерывную функцию, заданную этими весами.

Перцептрон Розенблата также использовал случайность, как в соединениях, так и в процессе обучения: «Цена, которую мы платим за использование статистических принципов в проектировании системы, — это вероятность того, что мы получим неверный ответ в каком-либо конкретном случае...»

Перцептрон работал именно потому, что находился далеко от мира четко представленных знаний и точных логических выводов.

Суть главного достижения Розенблата и его последователей по сравнению с Винером заключается в следующем: в то время как «черные ящики» Винера выражались через «рядовые разложения», функция, которую оценивает перцептрон, определяется иерархией синаптических весов. Рядовое разложение — это взвешенная сумма математических терминов все более высокого порядка, как правило, усеченная после всего лишь нескольких членов. Для простых кибернетических систем, которые Винер и его коллеги смогли создать (например, термостаты или, в конечном итоге, системы управления зенитным огнем), одного члена, представляющего линейное приближение, могло быть достаточно. Но это не так для многослойного перцептрона, способного достигать визуальной перцептивной инвариантности.

Проблема не теоретическая, а практическая. В конечном счете, функция есть функция. И нейронные сети, и рядовые разложения являются «универсальными аппроксиматорами функций», что означает, что каждая из них может аппроксимировать любую функцию.

Тем не менее, более формальный подход Винера потребовал бы огромного количества параметров, чтобы выйти за пределы линейного или первого порядка. Реалистичные нелинейности (например, для классификации объектов) на практике не могли быть изучены на ограниченном количестве обучающих примеров. Отказавшись от такого рода математики и просто соединив упрощенные нейроны в нескольких слоях, Розенблат наткнулся на гораздо более обучаемый способ представления тех функций, которые необходимы для преобразования изображений, звуков и других естественных стимулов в инвариантные классификации.

Можно было бы это объяснить удачей, интуицией или тем и другим, но на каком-то уровне что-то подобное должно было сработать, иначе наши мозги были бы такими же, как у бедного Фунеса, эль мемориозо.

Почему перцептроны так «легко обучаются» по сравнению с более традиционными аппроксиматорами функций, пока не совсем понятно. Недавние анализы предполагают, что это может быть связано с «композиционным приоритетом», что означает предвзятость к обучению функциям, которые можно определить через иерархическую композицию более простых функций. Этот тип приоритета, похоже, полезен для самых разных когнитивных задач и обобщений, а не только для восприятия. (Интригующе, что симбиогенетический взгляд на эволюцию, описанный в главе 1, также можно рассматривать как алгоритм обучения, который предпочитает иерархические композиции функций.)

Хотя перцептрон по своей сути кибернетический, он не квалифицируется как полноценная кибернетическая система, по крайней мере, не в том виде, в котором обычно используется. Классификатор изображений не имеет очевидного агентства. Он не «действует», он просто «существует», как любая другая математическая функция.

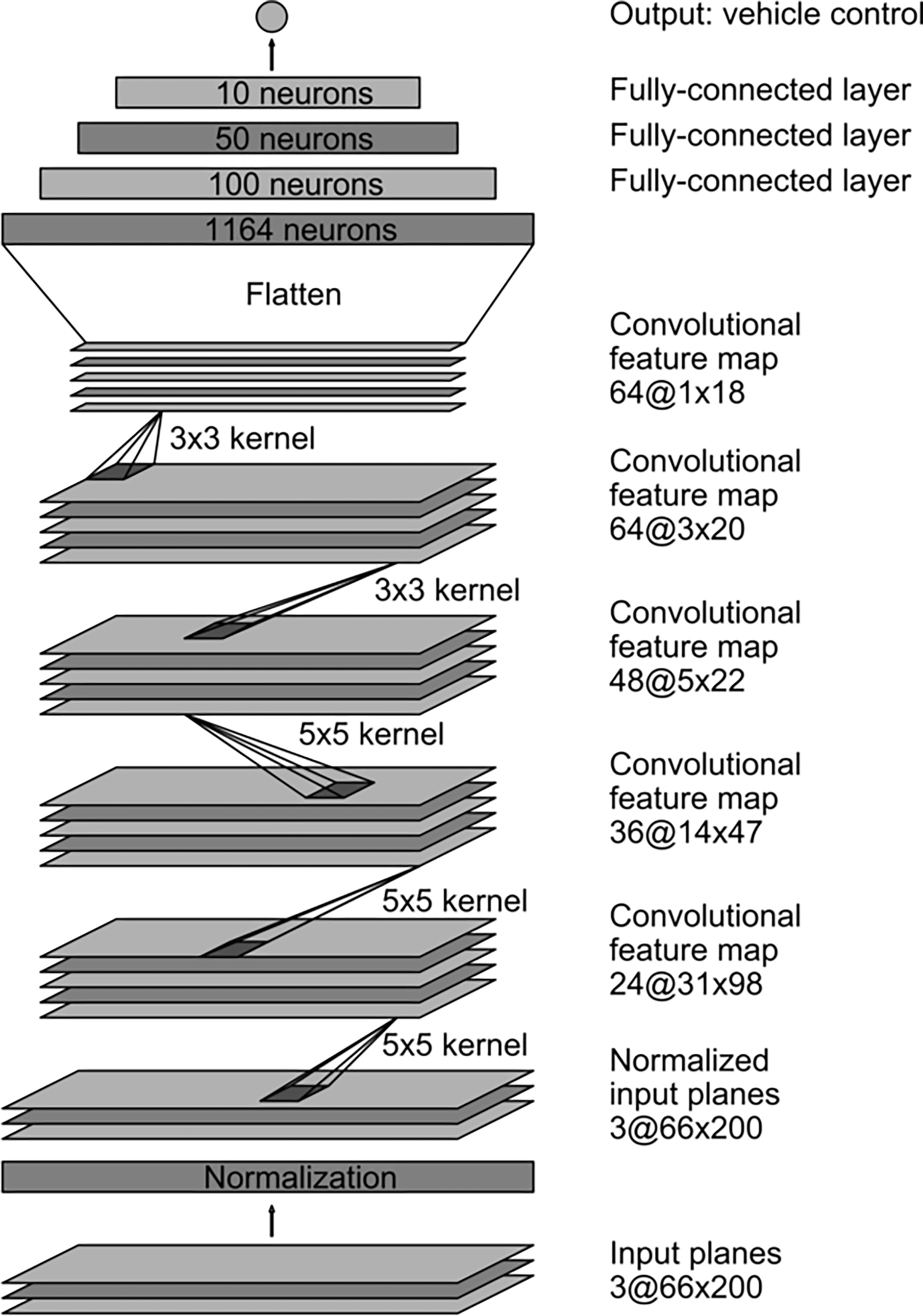

Однако есть одно примечательное исключение — статья 2016 года от исследователей Nvidia: «Обучение от начала до конца для автономных автомобилей», в которой описывается система DAVE-2 (преемник DAVE, раннего «автономного транспортного средства DARPA»). Авторы обучили свёрточную нейронную сеть «соответствовать сырым пикселям с одной фронтальной камеры непосредственно командам управления рулем». В аннотации говорится: «Этот подход от начала до конца оказался удивительно мощным. С минимальным объемом обучающих данных от людей система учится управлять в условиях движения на местных дорогах с разметкой и без неё, а также на автомагистралях. Она также функционирует в зонах с неясными визуальными ориентирами, таких как парковки и грунтовые дороги».

▶ Демонстрация автономного автомобиля DAVE-2, 2016

DAVE-2 кажется удивительно чистым воплощением кибернетического видения Винера, благодаря универсальной способности свёрточной сети к аппроксимации функций.

Можно рассматривать это как гораздо более сложную версию Palomilla, с настоящими глазами вместо фотодатчиков и двадцатью семью миллионами синапсов вместо пары вакуумных трубок. (Для грубой оценки, у пчелы, вероятно, около миллиарда синапсов, а у мыши — около триллиона, хотя биологические синапсы нельзя напрямую сопоставлять с параметрами модели.)

Архитектура свёрточной нейронной сети DAVE-2 для автономного вождения, по материалам Bojarski и др., 2016

Нелинейность функции, обученной DAVE-2, позволяет достигать богатого, контекстно зависимого поведения без явной логики «если/то/иначе»; разметка полос, ограждения и другие автомобили влияют на вождение так, как мы и надеемся. Хотя единственным выходом сети является угол поворота руля, если бы мы провели «нейробиологическое» исследование этой сети после обучения, мы, безусловно, обнаружили бы нейроны, которые реагируют специфически и избирательно на все такие объекты, подобно нейронам визуальной системы, которые записывала Ливингстон во время своей работы в лаборатории Хюбела.

Тем не менее, в этой картине не хватает важных элементов. В частности, входом для свёрточной сети является лишь один кадр видео, а выход управляет только рулём, без учета газа или тормозов. Здесь отсутствует предсказание будущего. Поскольку сеть работает с частотой тридцать кадров в секунду, скорость автомобиля поддерживается на постоянном уровне человеком-напарником, а управление рулём обеспечивается разумной плавностью благодаря механической инерции, система, безусловно, ощущается как динамичная, но обученная модель не имеет динамики. Здесь невозможно ничего похожего на планирование или память, только мгновенная реакция, подобная рефлексу, полностью определяемая предыдущим оффлайн-обучением. Модель также не моделирует себя никаким образом; её умвельт чисто внешний, это просто вид дороги в данный момент времени.

Оригинальное (и кибернетически обоснованное) видение Розенблатта было значительно шире.

Он подчеркнул, что то, что мы сейчас просто называем «перцептроном», на самом деле является лишь «мгновенным стимулом фотоперцептрона», […] самым элементарным устройством, которое можно было построить для демонстрации общих принципов этой системы. Можно было бы представить и другие сенсорные модальности, а «перцептроны временных паттернов» также обладали бы способностью «запоминать временные последовательности событий, а не мимолетные образы, такие как те, что можно получить из набора изолированных кадров, вырезанных из пленки».

Большая часть этого осталась на стадии концепции, но, что примечательно, даже перцептрон мгновенного стимула Mark I был реализован как физическое устройство с реальной динамикой, способное обучаться, корректируя свои параметры на основе обратной связи в любое время. Современные нейронные сети, как правило, не обладают этой особенностью. Даже если они действуют как контроллеры в замкнутом контуре обратной связи, как в случае с автономным автомобилем, они не изменяются в процессе работы так, как это делаем мы. Вместо этого они обучаются оффлайн на статических данных с использованием пакетной обработки, подобно тому, как ENIAC и другие ранние компьютеры решали сложные задачи за ночь (или за много ночей).

Таким образом, область, которую мы называем «машинным обучением», по-прежнему не производит системы, которые действительно учатся, а лишь системы, которые действуют. Трудно считать что-то «живым», если ничто из переживаемого не может на него устойчиво повлиять, и для многих может быть сложно назвать что-то «интеллектуальным», если оно не может учиться на этих переживаниях.

В этих ключевых аспектах мы все еще движемся к амбициозной визии, изложенной Винером, Розенблаттом и другими ранними кибернетиками в 1940-х и 1950-х годах.

Большинство растений, конечно, не питаются другими формами жизни. Их источником свободной энергии является поток низкоэнтропийных фотонов, исходящих от нашей ближайшей звезды. Земля в целом излучает более высокоэнтропийные фотоны обратно в космос, поддерживая энергетический и энтропийный баланс — хотя парниковый эффект, уменьшая количество излучения, которое может покинуть Землю, сейчас нарушает этот баланс, что приводит к росту энтропии на планете.

Как мы кратко обсуждали в главе 2 «Umwelt Within», это не обязательно означает, что такое моделирование осознанно. Как мы исследуем в главе 6 «Что значит быть», то, что мы считаем сознанием, — это моделирование вашей собственной модели, а не просто наличие (то есть действие в соответствии с) модели.

Бэббидж 1864 ↩ . Скотт 1998; Солл 2011 ↩ , ↩ . Среди них были: Кэй МаКналти, Бетти Снайдер, Марлин Уэскофф, Рут Лихтерман, Бетти Джин Дженнингс и Фрэн Билас. Фриц 1996; Лайт 1999 ↩ , ↩ .

Как это обычно бывает с «первенцами», есть и другие претенденты. Работая в относительной изоляции, Конрад Цузе, немецкий инженер-строитель, завершил свой электромеханический компьютер Z3 в 1941 году. Проект Цузе также был мотивирован войной; его предыдущие машины S1 и S2 были специализированными устройствами для вычисления аэродинамических корректировок крыльев радиоуправляемых бомб, и после 1939 года он получал финансирование от нацистского правительства. Хотя Цузе не проектировал Z3 с учетом полноты Тьюринга и он не поддерживал условные переходы изначально, его можно было умело программировать для их имитации. Это, возможно, дает Z3 приоритет над ENIAC, согласно Рохасу 1998 ↩ .

Фицпатрик 1998 ↩ . Г. Э. Мур 1965; Шаллер 1997 ↩ , ↩ . IBM 2007 ↩ . Аренда 701 в 1952 году стоила от 12,000 до 18,000 долларов в месяц. IBM 2007 ↩ . Уолдроп 2018 ↩ . Де Моншо 2011 ↩ .

Хотя в 1834 году Андре-Мари Ампер предвосхитил как концепцию, так и название в своем эссе «Философия науки», в котором он писал, что будущая наука, «кибернетика», должна охватывать «ту совокупность теорий [...] которая касается основных процессов, управляющих курсом организаций всех видов».

Когда пациент с «тремором намерения», вызванным повреждением мозжечка, тянется к объекту, он, как правило, переходит за цель, а затем корректирующее движение чрезмерно компенсирует это. В результате получается колебательное движение, как и предсказывала теория Винера, когда обратная связь нарушена.

Женевьев Белл, антрополог и проректор Австралийского национального университета (ANU), основала Школу кибернетики ANU в 2021 году. Я полностью поддерживаю ее возрождение термина «кибернетика», чтобы включить не только ИИ, но и более широкий набор междисциплинарных тем, упомянутых здесь.

Авторы уклоняются от обсуждения, пиша: «Обсуждение причинности, детерминизма и конечных причин выходит за рамки этого эссе [...] однако [...] целеустремленность, как определено здесь, совершенно независима от причинности, начальной или конечной». На данный момент мы также избегаем случайного элемента, присущего квантовой механике, хотя позже вернемся к случайности.

Философ Дэниел Деннэт назвал это, или что-то очень похожее, «интенциональной позицией».

Яковс 1961

↩

.

Мани 1984; Даунг, Моралд и Салливен 2015

↩

,

↩

.

Харавей 1985

↩

.

Силлиерс 1998; Воерманн 2016

↩

,

↩

.

Клайнс и Клайн 1960

↩

.

Рид 2016

↩

.

Несколько лет спустя в Советском Союзе кибернетика пережила аналогичный подъем и падение; см. Петерс 2016

↩

.

Маккарти и др. 1955; Нильссон 2009

↩

,

↩

.

Дрейфус 1972

↩

.

Джеймс 1890

↩

. Важная глава (IV — Привычка) была опубликована ранее, в 1887 году.

Феррейра, Ногейра и Дефелипе 2014

↩

.

Павлов 1902

↩

.

Питтс и МаКаллох 1947

↩

.

Борхес 1942

↩

.

Фон Аhn и др. 2003; Чью и Тайгар 2004

↩

,

↩

.

Хендлер 2006; Нильссон 2006

↩

,

↩

.

Хюбел и Визель 2004

↩

.

Ливингстон 2013

↩

.

Розенблат 1957

↩

. См. также Розенблат 1958

↩

.

До конца 2010-х годов видеоигры определяли рынок графических процессоров.

Масштабно параллельная Connection Machine, изобретенная Дэнни Хиллисом и его коллегами в 1980-х, была заметным исключением, состоящим из массива небольших локальных процессоров, соединенных с соседями в 3D-торусе. Как «коннекционист», Хиллис и его коллеги были уверены, что их архитектура — будущее вычислений, а особенно ИИ. Однако они оказались слишком впереди времени. Именно потому, что Connection Machine была такой архитектурной аномалией, для нее никогда не существовало жизнеспособной программной или исследовательской экосистемы; см. Хиллис 1985

↩

.

Шмидхубер 2014

↩

.

Минский и Паперт 1969

↩

.

Сайбенко 1989

↩

.

По словам Курцвейла 2024

↩

, «[В] 1964 году Розенблат объяснил мне, что неспособность Перцептрона справляться с инвариантностью была связана с недостатком слоев. Если вы возьмете выход Перцептрона и подадите его обратно на другой слой, такой же, как и он, выход станет более общим, и с повторением этого процесса он будет все лучше справляться с инвариантностью. Если у вас будет достаточно слоев и достаточно обучающих данных, он сможет справляться с удивительным уровнем сложности. Я спросил его, пробовал ли он это на практике, и он ответил, что нет, но это было в его исследовательском плане на первом месте».

Это было удивительное прозрение, но Розенблат умер всего через семь лет, в 1971 году, не успев проверить свои идеи. Сейноловски и Розенберг 1987

Под «распределёнными представлениями» авторы понимали представления концепций, основанные на значениях множества нейронов, также известных как нейронные «встраивания». Нейронные встраивания будут подробно описаны в главе 4 «Разделение».

Минский и Паперт 1988

Бендер и Коллер 2020; Хомский, Робертс и Ватумулл 2023

Это, по крайней мере, было давним предположением в статистическом моделировании. На самом деле всё оказывается более сложным, как будет описано в главе 9 «Длинные хвосты»; для современного математического анализа зависимости между объёмом данных и количеством параметров см. Бубек и Зеллке 2022.

Составить полный список было бы невозможно, особенно без некоторой исторической дистанции; сегодня публикуется огромное количество статей, предлагающих тот или иной новый поворот. Могут пройти годы, прежде чем мы поймём, какие из них окажутся значимыми, и иногда трюк нужно изобретать заново несколько раз с небольшими вариациями, прежде чем он будет широко принят. Этот процесс более чем отдалённо напоминает эволюцию. ЛеКун, Денкер и Солла 1989.

В 2014 году «очень глубоким» считалось от шестнадцати до девятнадцати слоёв (Симонян и Зиссерман 2014); к 2015 году это уже было 152 слоя (Хе и др. 2016a); а в 2016 году исследователи из Microsoft сообщили о сети с 1001 слоем (Хе и др. 2016b). Фукушима 1980; ЛеКун и др. 1989.

Больцман 1868; Брайдл 1990.

Ямагути и др. 1990.

ЛеКун и др. 1995.

Ежегодная конференция NeurIPS, которая с тех пор превратилась в гиганта, была основана в 1987 году специально для изучения как «естественных, так и синтетических» систем обработки нейронной информации; Абу-Мостафа 2020.

Норберт Винер, Уоррен МаКаллох, Уолтер Питтс, Фрэнк Розенблатт, Кунихико Фукушима, Алан Тьюринг, Джеффри Хинтон, Терри Сейнолски, Рич Саттон, Карл Фристон, Ян ЛеКун, Рид Монтегю, Юрген Шмидхубер, Сара Сола, Йошуа Бенгио и Питер Даян — все они важные фигуры в развитии машинного обучения, упомянутые в этой книге, которые работают или работали в традиции вычислительной нейробиологии или НейроИскусственного Интеллекта.

ЛеКун и др. 1990, 1998

↩

,

↩

.

Кризевский, Сутскевер и Хинтон 2012

↩

.

Чжан, МаКлафлин и Сонг 2015

↩

.

Уэйн, Дюран и Каруана 2020

↩

.

Дофен и др. 2017

↩

.

Триггер — это базовая электрическая схема, которая может «переключаться» в одно состояние или «падать» в другое; таким образом, он незаменим для реализации цифровой логики. Мультистабильный триггер имеет более двух стабильных состояний.

Розенблатт 1957

↩

.

Более технически, любая достаточно непрерывная функция.

Добеши и др. 2022

↩

.