Глава 9: Будущее интеллекта

Общие сведения

Единая система

Широко цитируемая психологическая модель человеческого мышления предполагает наличие двух режимов работы мозга: «Система 1» и «Система 2».

Система 1 — это быстрый, автоматический, безусиленный, частый, стереотипный и бессознательный процесс, в то время как Система 2 — медленный, требующий усилий, редкий, логический, расчетливый и сознательный. Очевидные параллели можно провести с режимом работы чат-бота «просто дай мне ответ», который напоминает Систему 1, и с побуждением к цепочке размышлений, которое заставляет модель работать больше как Система 2.

Исследователи даже количественно оценили эту параллель, тестируя большие языковые модели с помощью психометрических задач, разработанных для выявления когнитивных искажений Системы 1. Без побуждения к цепочке размышлений чат-боты, как правило, используют те же эвристические приемы, что и мы в режиме Системы 1, в то время как с побуждением к цепочке размышлений они рассуждают более осмысленно, как мы в режиме Системы 2, избегая многих логических ошибок и «когнитивных иллюзий».

Эти результаты предполагают общую вычислительную основу для двух систем. Иными словами, возможно, в действительности работает только одна система, которая может функционировать как в одном шаге, так и в нескольких.

Если это так, это поможет разрешить давнюю эволюционную загадку. Французские когнитивные ученые Юго Мерсье и Дэн Спербер назвали разум «загадкой», поскольку неясно, как он мог эволюционировать постепенно из «инстинктивного» поведения животных. В конце концов, не человекообразные животные постоянно делают выводы в стиле Системы 1, но даже самые умные из них далеки от того, чтобы преодолевать те интеллектуальные высоты, которые доступны людям. Как же тогда мы могли развить способность к рассуждению, если Система 2 так отличается и так безпрецедентна?

Мерсье и Спербер предположили, что аналогичный «модуль» в уме мог бы выполнять те виды выводов, которые связаны как с Системой 1, так и с Системой 2, хотя, когда они опубликовали свою работу «Загадка разума» в 2018 году, это было довольно теоретично. Сегодня же кажется, что трансформеры реализуют именно такой механизм.

Та же самая модель, обученная делать то же самое — активно предсказывать будущее, основываясь на прошлом, включая как информацию из внешнего мира, так и собственный поток мыслей — может вести себя как Система 1 или Система 2.

Если требуется немедленный ответ, модель постарается сделать все возможное, используя любые усвоенные (или «инстинктивные») эвристики в сети, но это будет стоить ей рефлексивности, уязвимости к предвзятостям и «ловушкам». Однако, если есть время на размышления, та же нейронная сеть может генерировать промежуточные результаты, планы, предположения и контрфакты, что приводит к потенциально более качественному, хотя и более трудоемкому, обоснованному ответу.

Развивая эту гипотезу, можно сказать, что Система 1 является «бессознательной» по довольно очевидной причине: на размышления нет времени — лишь на мимолетную активность каскада нейронной активности по пути от стимула («В: …») к ответу («О: …»). В отличие от этого, мы осознаем обработку Системы 2 именно потому, что все эти промежуточные результаты должны попасть в «контекстное окно» вместе с «подсказкой» — то есть, с входными данными из внешнего мира.

Быть самосознательным — это, в конце концов, значит иметь доступ к своим собственным ментальным состояниям, уметь их воспринимать, осознавая, что именно вы являетесь их источником, и иметь возможность дальше рассуждать о них, занимаясь «метакогницией» или «размышлением о размышлении». В определенном смысле, вся деятельность Системы 2 или цепочка размышлений является метакогнитивной, поскольку включает в себя размышления о собственных мыслях и происходит с осознанием того, что они исходят из «внутреннего мира». Я здесь немного задвигаю под ковер сомнительное единство «я», хотя само существование чего-то вроде контекстного окна, благодаря своей однопоточности, может быть именно тем, что создает автобиографическое ощущение единого «я», которое воспринимает мир как последовательность событий во времени и способно к интроспективному мышлению.

Наше заблуждение о том, что Система 2 уникальна для человека или даже характерна только для животных с большим мозгом, вероятно, ошибочно. На самом деле, иронично, но главное преимущество большого мозга может заключаться в нашей способности быстро и параллельно выполнять множество задач, используя Систему 1, что в противном случае потребовало бы пошаговой обработки Системой 2. Вспомните о компромиссе, который делают пауки рода Порция, способные преодолевать свои (не маленькие) интеллектуальные вершины, просто проявляя терпение и действуя маленькими шагами. Предположительно, они используют нечто вроде цепочек мыслей — и довольно длинных. Их умственные опоры могут быть расположены близко друг к другу, но они терпеливы.

Ум Стаи

Пауки рода Порция, безусловно, умны — но они, возможно, не так уж и выделяются среди беспозвоночных. В своей книге 2022 года «Ум пчелы» зоолог Ларс Читка опирается на десятилетия исследований когнитивных способностей пчел, чтобы представить совершенно иную картину, чем та, что описывал Жан-Анри Фабр, настаивавший на «машиноподобной упрямстве» насекомых — утверждение, подхваченное Дэниелом Деннетом, который говорил о их «безмозглой механичности», и Дугласом Хофстадтером, упоминавшим их «спексишность» (см. главу 5).

Пчела, Apis mellifera, несущая пыльцу

На самом деле, Фабр, который всю жизнь внимательно наблюдал за настоящими насекомыми, не был так однозначен, как эти поздние теоретики, предостерегая, что «насекомое не является машиной, неизменной в действии своего механизма; ему предоставляется определенная свобода, позволяющая справляться с неожиданностями момента. Каждый, кто ожидает увидеть […] события […] развивающиеся […] точно так, как я описал, рискует разочароваться. Специальные случаи происходят — их даже много — которые […] противоречат общему правилу».

Это оказывается верным даже для поведения, которое вдохновило на создание слова «спексишность». Как отметил внимательный комментатор в переоценке 2013 года, «древоточцы очень часто не повторяют свои действия бесконечно, когда тест с кузнечиком завершен».

После нескольких попыток многие осы уносят сверчка в свою нору, не дожидаясь визита.

Читка и его коллеги задокументировали удивительно сложный набор поведений среди пчел, выходящий за рамки простого здравого смысла, который подсказывает не застревать в бесконечных циклах. Это не просто генетические библиотеки заранее заготовленных реакций; пчелы способны легко учиться, обобщать и даже, в определенной степени, рассуждать. Вот несколько примеров:

▶

В этом эксперименте шмелей обучали в несколько этапов тянуть за веревку, чтобы получить сладкое вознаграждение. Хотя лишь небольшое количество необученных шмелей смогло спонтанно освоить эту «неестественную» задачу, гораздо большее число смогло это сделать, наблюдая за обученными демонстраторами издалека, что говорит о том, что шмели более умны, чем обычно предполагается, и способны к социальному обучению; Alem et al. 2016.

Пчелы могут решать задачи, когда строят свои ульи, адаптируя свои методы строительства и ремонта к меняющимся условиям (включая странные, с которыми они никогда не сталкивались в дикой природе). Хотя они рождаются с некоторыми врожденными способностями к строительству гнезд, они развивают свои навыки, наблюдая и обучаясь друг у друга.

Пчел можно обучить распознавать произвольные формы и узоры, и они будут тратить больше времени на выявление различий, если их к этому побуждают положительные или отрицательные вознаграждения. (Им нужно потратить время, чтобы сделать тонкое различие, потому что, как и у Порции, их маленькие мозги ограничены последовательным сканированием стимулов.)

Пчелы могут обобщать задачи выбора, например, ассоциируя сигналы из разных сенсорных модальностей, обучаясь различать новые симметричные и асимметричные формы, а также различать человеческие лица (умение, которое недоступно примерно одному проценту людей с лицевой слепотой или «прозопагнозией»).

Пчелы обладают длительной рабочей памятью, которую могут использовать для решения задач на соответствие образцам («выбери тот же самый для вознаграждения» или «выбери другой для вознаграждения»).

Они могут проявлять самоконтроль, если это необходимо для получения отложенной награды, с задержками в шесть, двенадцать, двадцать четыре или тридцать шесть секунд.

После неприятного опыта с замаскированным искусственным крабовым пауком пчёлы будут избегать поддельных «цветов», связанных с ними, хотя, получая сладкие угощения внутри, они будут осторожно осматривать эти подозрительные цветы издалека, прежде чем неуверенно приземлиться на них.

▶

Когда роботизированный «крабовый паук» временно (но безвредно) парализует шмеля, тот проявляет гораздо большую осторожность при подходе к подобным «цветам» в будущем; Ингс и Читка, 2008.

Нейробиолог Кристоф Кох даже написал: «Пчёлы демонстрируют удивительный спектр талантов — способности, которые у млекопитающих, таких как собака, мы бы ассоциировали с сознанием».

То, что мы обнаружили эти свойства именно у пчёл, скорее всего, связано с тем, где мы искали. Это харизматичные насекомые, и их особенно легко изучать из-за их образа жизни, связанного с жизнью в ульях и сбором нектара. Но мы знаем, что прыгающие пауки и осы тоже умны.

А что насчёт стрекоз, богомолов и множества других насекомых, которых мы списали как бездумные автоматы? Вероятно, многие из этих насекомых лучше описывать как обладающих уменьшенной «рациональной душой», чем как запрограммированных автоматов.

На самом деле, полностью инстинктивное предопределение чрезвычайно дорого с эволюционной точки зрения. Оно требует, чтобы поведение было жестко закодировано в геноме, который воспроизводится в каждой клетке тела животного. Это также ограничивает обучение эволюционными временными рамками, которые ужасно медленны, исключая любую возможность адаптации к местным или временным обстоятельствам. Пчёлы, напротив, извлекают выгоду из впечатляющих достижений в обучении, несмотря на то, что их жизнь измеряется неделями. Возможно, для существа с мозгом обучение просто не так уж сложно, а инстинкты являются скорее резервной стратегией в природе, используемой только в случае крайней необходимости.

В этом свете «загадка разума» Мерсье и Спербера перестает казаться загадочной. Размышление с помощью большого мозга может быть тем, что происходит, когда мы предсказываем, долго обдумывая, используя цепочку размышлений и больше полагаясь на интроспекцию, но это не делает его беспрецедентным новым трюком с эволюционной точки зрения. Напротив, животные с маленьким мозгом, по необходимости и из-за своих небольших размеров, вероятно, занимаются этим уже сотни миллионов лет.

Хотя сравнения между размерами мозга и размерами нейросетевых моделей следует воспринимать с большой долей скептицизма, стоит задаться вопросом, насколько большой должна быть модель Transformer, чтобы надежно демонстрировать поведение Системы 2 при использовании языка. Обычно утверждается, что для генерации связных историй, ответов на вопросы или выполнения логических задач требуется как минимум миллиарды параметров.

Однако в 2023 году исследователи из Microsoft опровергли это предположение в статье под названием «TinyStories: Насколько маленькими могут быть языковые модели и все еще говорить на связном английском?». Они использовали большую модель для создания корпуса историй на языке, который может понять типичный трех- или четырехлетний ребенок, а затем предварительно обучили на этом корпусе небольшие модели. Удивительно, но модели с всего лишь десятью миллионами параметров и единственным слоем внимания могли надежно понимать и рассуждать о этих многопараграфных историях. Грубо говоря, эти цифры находятся в пределах, сопоставимых с мозгом пчелы.

Если пчелы, пауки и маленькие Transformers могут делать так много с таким малым количеством нейронов, что же мы, черт возьми, делаем с таким их изобилием? Ответ, о котором мы уже упоминали, — это параллельная обработка. Пчела должна пролететь над полем цветов, обращая внимание на один цветок за раз. Однако наша массово параллельная визуальная система позволяет нам охватывать все поле одним взглядом и за долю секунды замечать, скажем, красные цветы.

Способ, которым они, кажется, выпрыгивают на поверхность, обусловлен не только гораздо более крупной сетчаткой, но и соответствующим образом дублированными колонками зрительной коры, каждая из которых может «смотреть» одновременно.

Имейте в виду, что «смотреть» — это активный и предсказательный процесс, а не просто поток информации. Поэтому, если вы пытаетесь заметить красные цветы, синие или цветы определенной формы, каждая колонка коры знает об этом и будет заниматься этой задачей. Если она увидит нужный цветок, то будет сигнализировать об этом энергично, как ребенок, поднимающий руку в классе. Она также использует латеральное торможение, чтобы подавить менее значимые реакции соседних колонок и «проголосовать» за движение глаз, чтобы лучше сфокусироваться на чем-то, что выглядит достаточно важным для внимания.

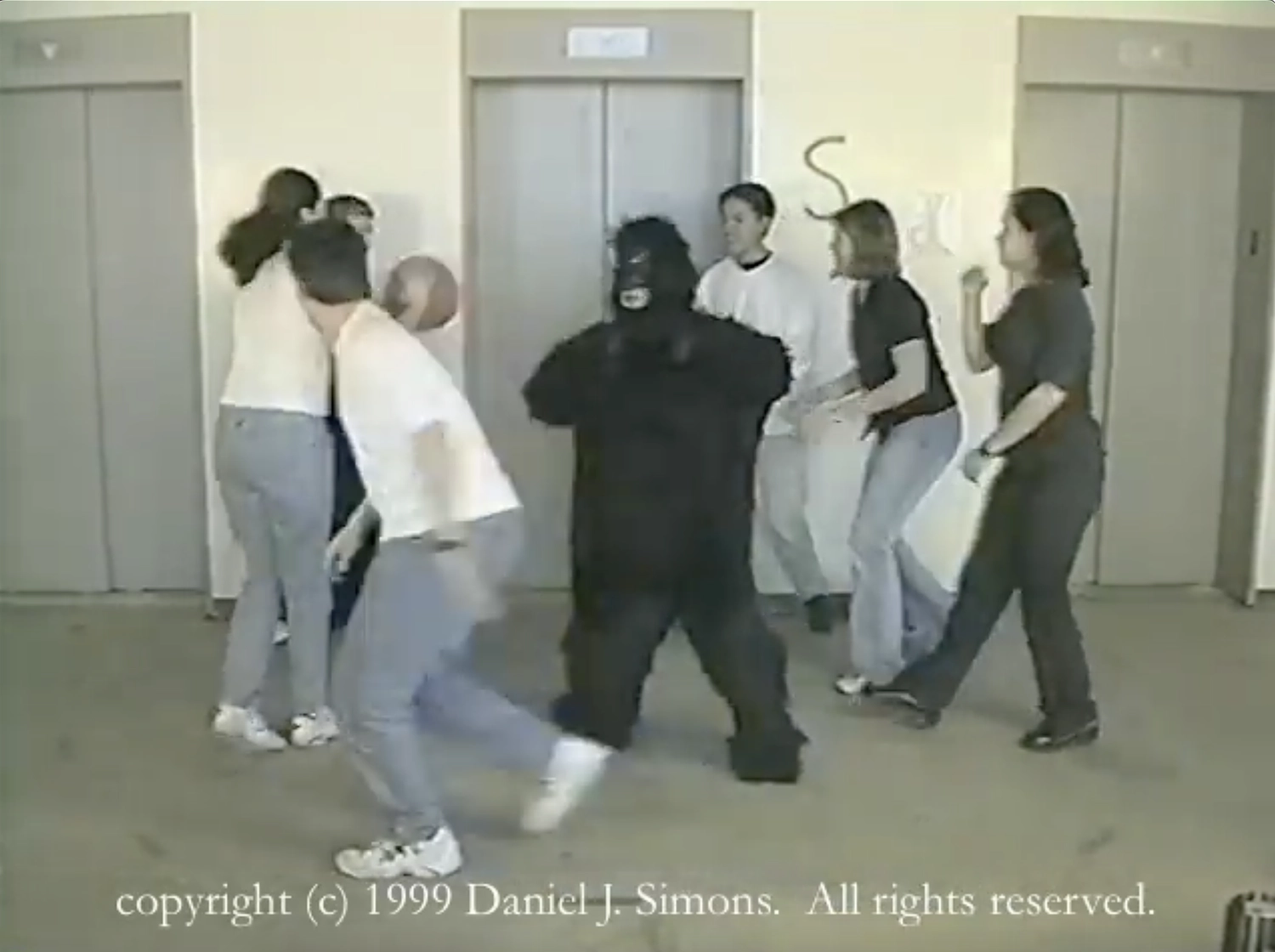

При первом просмотре большинство людей не замечают фигуру в костюме гориллы в центре этого кадра из знаменитого видео «Гориллы среди нас» (доступно здесь ), Симонс и Чабрис, 1999.

Знаменитая иллюстрация активного — и, следовательно, избирательного — качества зрения включает короткое видео группы студентов в белых или черных футболках, которые бросают и ловят баскетбольный мяч.

В качестве экспериментального субъекта вам говорят сосчитать, сколько раз кто-то в белой футболке делает передачу. Это требует некоторой концентрации, но сделать это не сложно. В конце видео вас спрашивают, заметили ли вы что-то странное; скорее всего, вы ответите «нет». Но, как оказывается, среди бросающих мяч была человек в костюме гориллы, который прошелся среди них, встал прямо в центре, постучал себя по груди, а затем ушел за пределы экрана. Трудно поверить, что это действительно произошло, и вы этого не заметили, но… ни одна часть вашей зрительной коры не искала горилл или «что-то странное». Ваша кора была занята подсчетом передач. Даже если какая-то колонка коры подняла бы руку, чтобы сказать «ммм…», ее, скорее всего, проигнорировали бы.

Хотя такое «недостаточное внимание» может привести к тому, что мы не замечаем гориллу, преимущества массово параллельного человеческого зрения над более последовательным зрением пчелы кажутся очевидными в контексте поиска пищи. В конце концов, нахождение цветов на поле — это идеальный пример задачи, которую можно выполнять параллельно.

И это так, но не совсем в том смысле, который бы способствовал развитию больших мозгов. Подумайте: каждый цветок содержит лишь каплю нектара. Вы можете увидеть их все разом, но вам все равно придется перемещать свое тело, значительно превышающее размер пчелы, от одного цветка к другому, чтобы действительно собрать нектар. Энергия, содержащаяся в их нектарах, не покроет даже затраты на движение, не говоря уже о потребностях этого жадного до глюкозы параллельного процессора между вашими ушами — который, к слову, большую часть времени будет просто простаивать (или, по крайней мере, не будет занят поиском пищи).

Ваш мозг, другими словами, чрезмерно перегружен для этой задачи. Пчела, будучи на порядки меньше, собирает изобилие энергии, используя свой последовательный подход; ее сенсорные и моторные системы гораздо лучше согласованы друг с другом и с полями цветов.

В меловом периоде (145–66 миллионов лет назад) некоторые пчелы и другие виды насекомых действительно начали массово параллелить, но не за счет увеличения размеров своих индивидуальных мозгов, а путем формирования ульев. Улей воспроизводится как единое целое и представляет собой суперорганизм — классический пример симбиогенеза. Высоко децентрализованная организация поддерживает правильный баланс между сенсорными и моторными системами, позволяя отдельным пчелам ощущать и действовать независимо. Тем не менее, они делятся как калориями, так и информацией о том, где найти больше, используя свой знаменитый танец виляния. Представьте улей как гигантского осьминога, где каждая пчела — это присоска на конце невидимой щупальца, которое может простираться на мили. Как массово параллельный процессор и сборщик пищи, этот суперорганизм невероятно универсален и эффективен.

▶

Пчела, сообщающая о месте кормежки улью с помощью танца виляния

Более централизованный подход к развитию интеллекта, заключающийся в увеличении размера мозга и тела, предоставляет сравнительное преимущество в скорости, или, точнее, в задержке. Одно тело может быстро выполнить скоординированное движение, в то время как параллельная обработка множества нейронных ансамблей «голосует» за это за доли секунды. Сравните это с часами, которые может потратить пчела на круговой маршрут и танец для своих сотоварищей. Если вы питаетесь растительными продуктами, временной интервал в несколько часов вполне приемлем. Если же вы едите других животных, вы и ваша жертва вступите в кибернетическую гонку вооружений, движимую умными скоординированными действиями на скорости, как описано в главе 3. Более того, большие мозги требуют больших тел для их транспортировки, а большие тела требуют больших мозгов для координации своих движений, поэтому количество мышц (или мяса), доступных в одном животном, также увеличивается по мере эскалации этой гонки вооружений. Ставки растут!

Иронично, но молниеносная кибернетическая хищность является сутью мышления Системы 1. Она не оставляет времени на размышления. (Вот почему кибернетические системы середины двадцатого века, обладающие лишь низкоуровневыми предсказаниями, были вполне достаточны для военных приложений, таких как наведение ракет.) С другой стороны, ничто не мешает хищникам с большими мозгами использовать заранее продуманную хитрость для планирования атаки на ничего не подозревающую жертву, как это делает Порция, что дает постоянное преимущество для мышления Системы 2.

И, конечно, среди высоко социальных животных с большими мозгами — нас, прежде всего — дружеское сотрудничество, политика и спаривание придают особую ценность медленному мышлению. Как знает каждый, кто придумал остроумный ответ задолго после того, как момент для него уже прошел, скорость важна в социальных взаимодействиях, но даже остроумие не обязательно должно действовать в временных рамках, измеряемых сотыми долями секунды, как это требуется в настоящем поединке на мечах.

Во время споров, обсуждений, торговых переговоров, группового планирования, преподавания, обучения или ухаживания за партнером, потратить несколько секунд на осмысление цепочки мыслей перед тем, как открыть рот, обычно хорошая идея. Наша способность к быстрому параллельному и медленному последовательному обработке информации — это один из аспектов характеристики психолога Джонатана Хайда о людях как о «90% шимпанзе и 10% пчеле», хотя шимпанзе сами по себе довольно социальны и способны на медленное мышление. Новым элементом, который люди приносят в эту картину, является высокоразвинутая сенсомоторная модальность, идеально подходящая как для внутренне осмысленных, так и для социально разделяемых цепочек мыслей: модальность языка.

Модальности

Может показаться странным называть язык модальностью. Однако с точки зрения машинного обучения это именно так. Чат-боты и более простые модели, такие как Word2Vec, обучаются на тексте, а не на пикселях, звуках или других сенсорных сигналах.

Конечно, мы не воспринимаем текст напрямую. Мы распознаем текст через другие модальности, включая слух (устный), зрение (письменный) и даже осязание (Брайль или письмо пальцем). В разговоре слух и зрение часто работают в тандеме, где жесты, мимика и окружающие подсказки играют важную роль, особенно во время обучения языку.

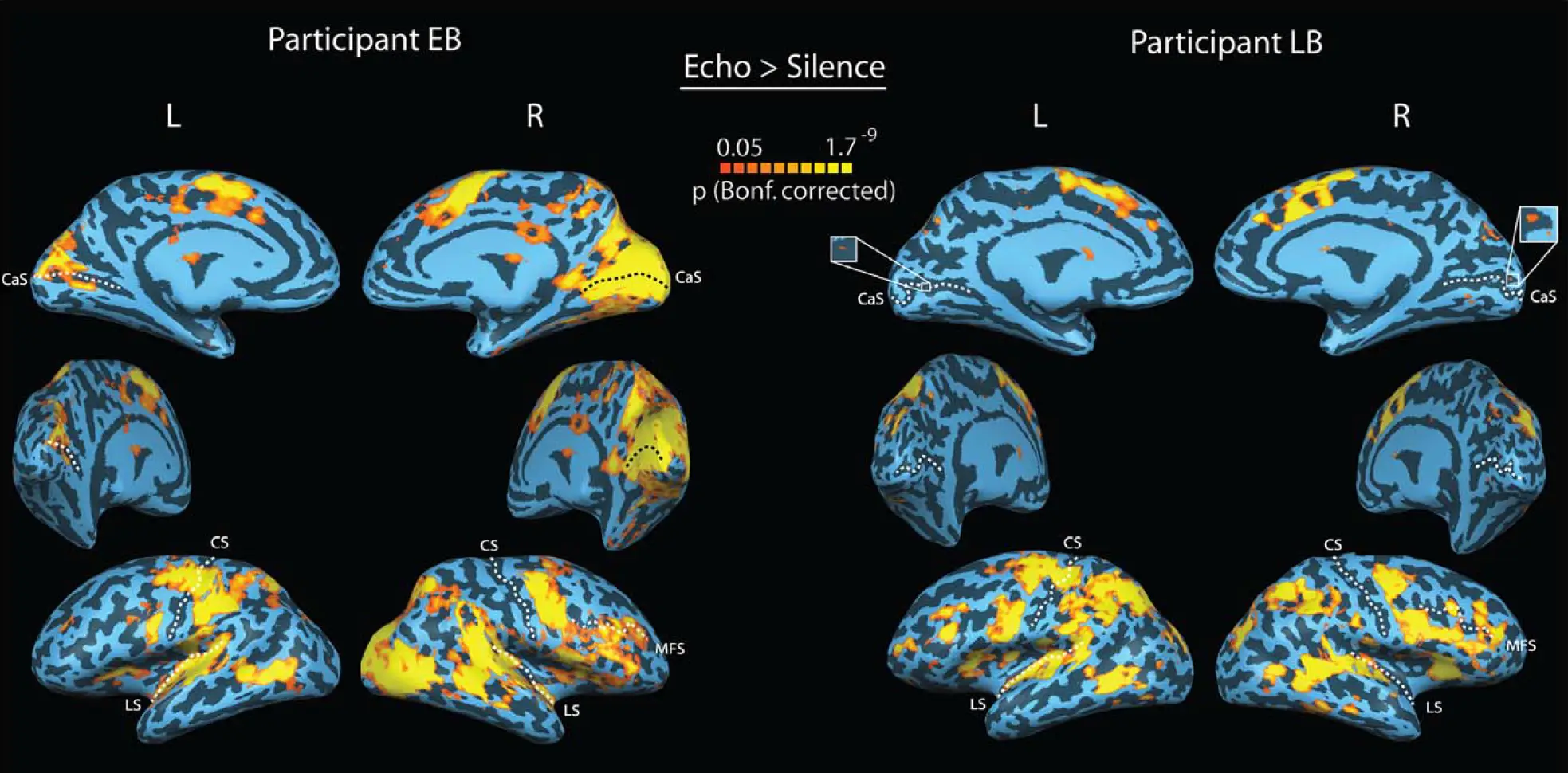

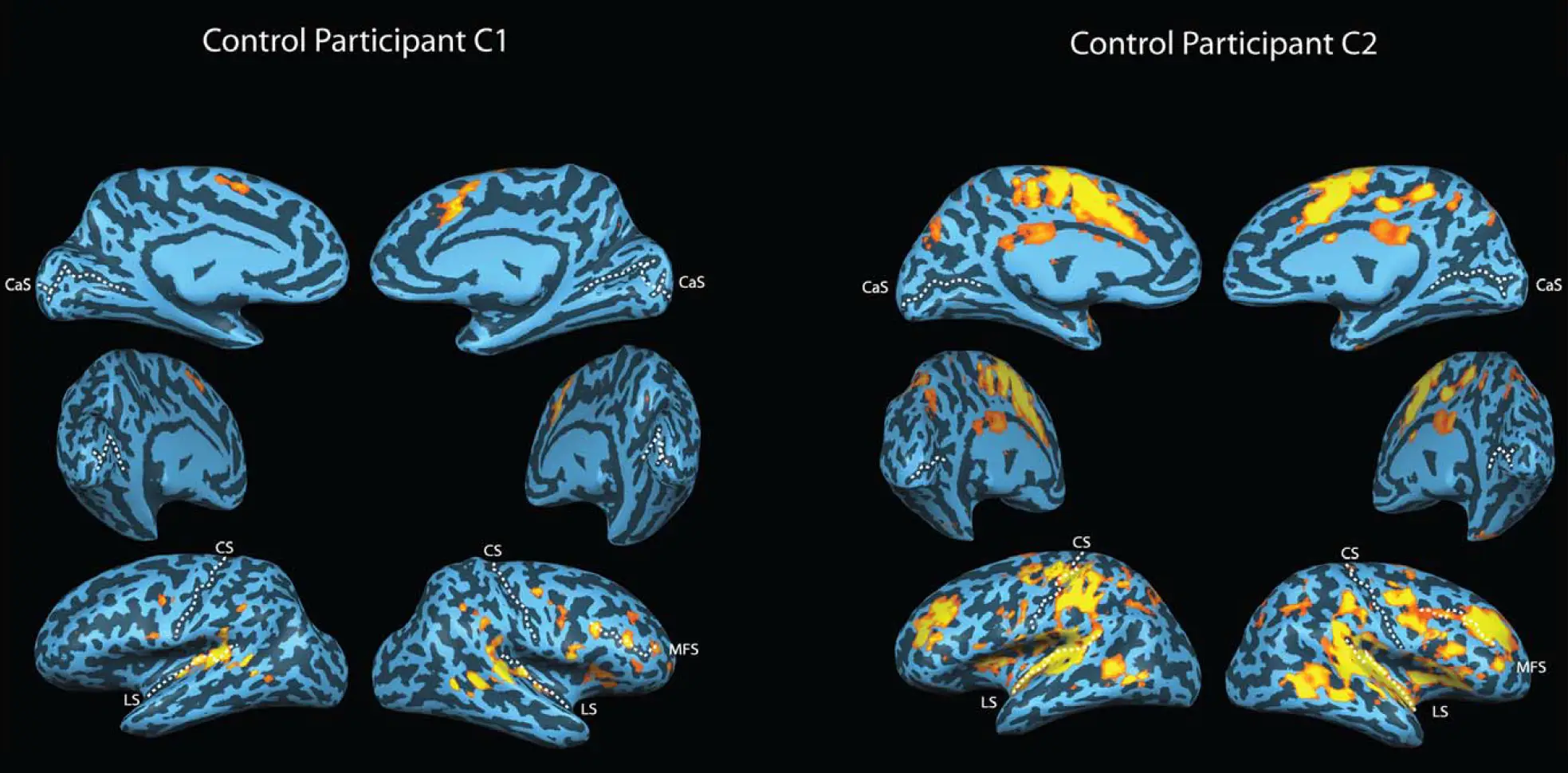

Тем не менее, существует также нейробиологическое обоснование для того, чтобы рассматривать текст как сенсорную модальность, хотя и косвенную и культурно усвоенную. У грамотных людей в определенной части мозга — «области визуальной формы слова» (VWFA), расположенной в нижней части левого височного lobа — развивается способность выполнять задачи чтения, то есть учиться преобразовывать визуальный ввод в текст. Высокий уровень нейронной активности в этой области может затем служить специализированной текстовой модальностью для любого другого региона мозга, который соединяется с VWFA.

С этой точки зрения зрение не является по своей сути более «реальным» сенсорным модальностью, чем текст. Вспомните, что сырое визуальное восприятие — это хаос, совершенно не похоже на стабильный «галлюцинированный» мир, который вы думаете, что видите.

Используя предсказательное моделирование, зрительная система запрашивает и обрабатывает обратную связь от глаз, создавая нечто вроде диорамы, которую другие части мозга могут затем исследовать. Для этих областей именно эта величественная диорама, а не сырой, дрожащий поток информации от глаз, составляет визуальный умвельт . Дополнительная обработка, которая превращает визуальный ввод в текст, является просто еще одной такой трансформацией, отбирающей слова из стабилизированных изображений для создания текстовой модальности.

VWFA (визуальная область, отвечающая за восприятие слов) является замечательным свидетельством гибкости и универсальности коры. Гены могут поддерживать или предрасполагать нас к развитию определенных способностей через «предварительную адаптацию», но неясно, как это может касаться чтения и письма— это слишком недавнее явление. Имейте в виду, что человек существует уже сотни тысяч лет, в то время как первое известное письмо появилось всего несколько тысяч лет назад.

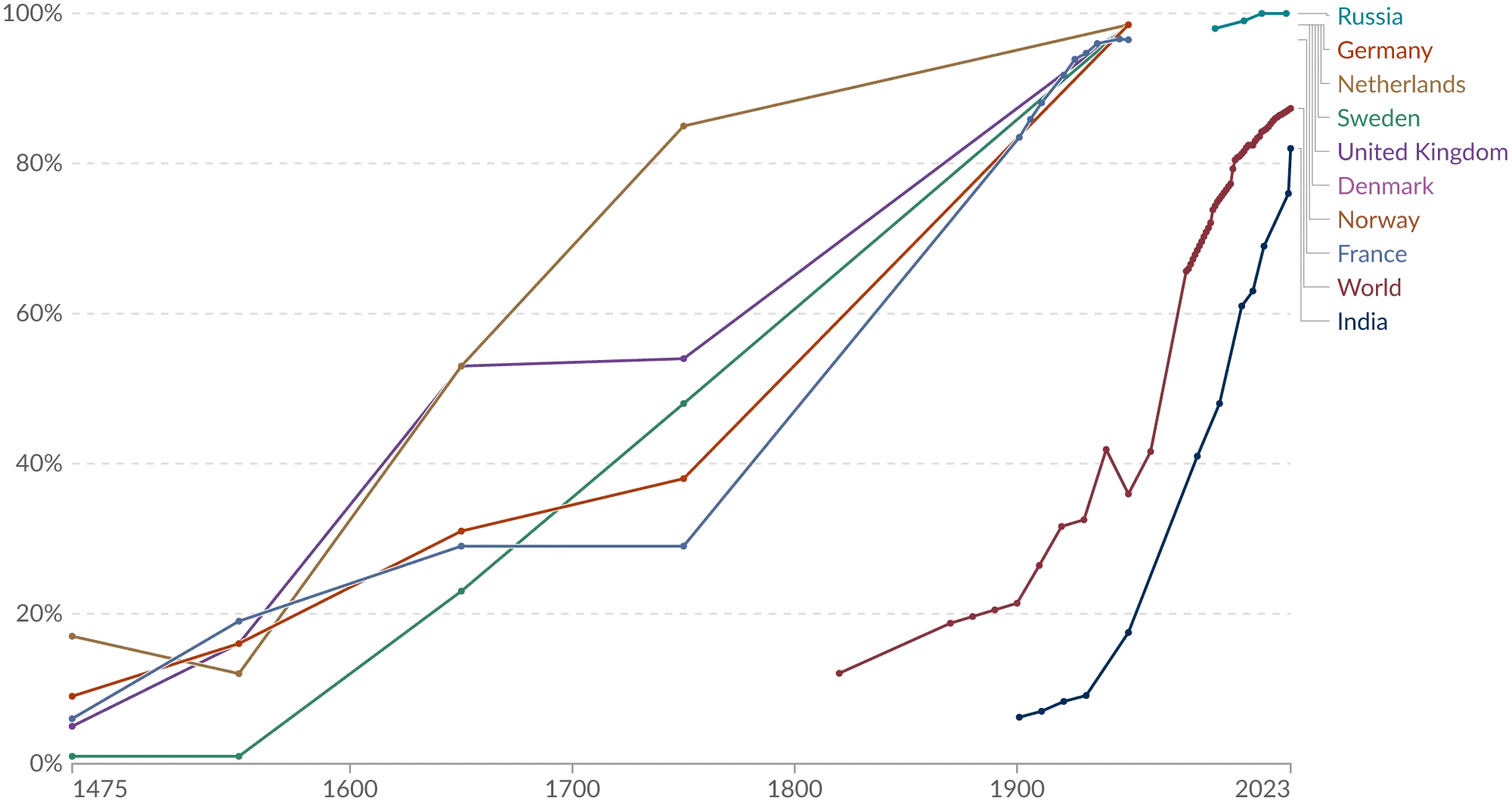

Прежде чем возразить, что несколько тысяч лет могут быть достаточными для появления эволюционной черты, учтите, что даже после изобретения письма грамотность оставалась привилегией лишь небольшой части человеческого населения— профессиональных писцов, священнослужителей и правящей элиты— до всего лишь нескольких поколений назад. Есть все основания полагать, что как минимум некоторые из ваших пра-пра-дедушек и пра-пра-бабушек были неграмотными.

Данные о грамотности по всему миру, начиная с 1475 года в нескольких странах с необычно высокими историческими показателями грамотности; Росер и Ортис-Оспина, 2018.

Мы можем лишь заключить, что VWFA — это обычный участок мозга, который просто оказался в нужном месте (в плане связей) в нужное время. У современных грамотных людей он установил симбиотические функциональные отношения с другими областями мозга, используя универсальную процедуру предсказательного обучения для поддержки ценного культурно эволюционировавшего качества.

Таким образом, VWFA подчеркивает, как высокоспециализированная сенсорная обработка— по сути, новая модальность— может быть изучена, открывая пространство для высокоскоростной культурной эволюции.

Похожая история может касаться не только чтения, но и самого языка. Несмотря на распространенное мнение среди лингвистов о том, что в наших мозгах есть встроенный «языковой орган», вовсе не очевидно, что мы генетически предрасположены именно к языку, и поиски универсальных грамматических или синтаксических свойств, общих для всех человеческих языков, не увенчались успехом.

В той мере, в какой человеческая генетика поддерживает обучение языку в большей степени, чем у наших приматов-собратьев, становится все более вероятным, что эта поддержка состоит в сочетании улучшенного обучения последовательностям в целом и большей социальной направленности. Если это так, то другие проявления обучения последовательностям, особенно те, которые усиливают социальность, такие как танец и музыка, вполне могли предшествовать сложному языку.

По сравнению с зрением, обонянием и другими модальностями язык обладает уникальными свойствами. В то время как обычные чувства предназначены для восприятия мира в целом, язык служит исключительно для восприятия друг друга. У него есть удивительно рефлексивные, самоотсылающиеся качества (отсюда моя способность писать об этом в этой книге и ваша способность понимать то, что я пишу — надеюсь). Предоставляя нам механизм чтения мыслей, язык должен позволять общаться о любом аспекте нашего умвельта, включая наши модели самих себя и других — что, естественно, включает модель каждой другой сенсорной модальности и моторной возможности, как нашей, так и чужой.

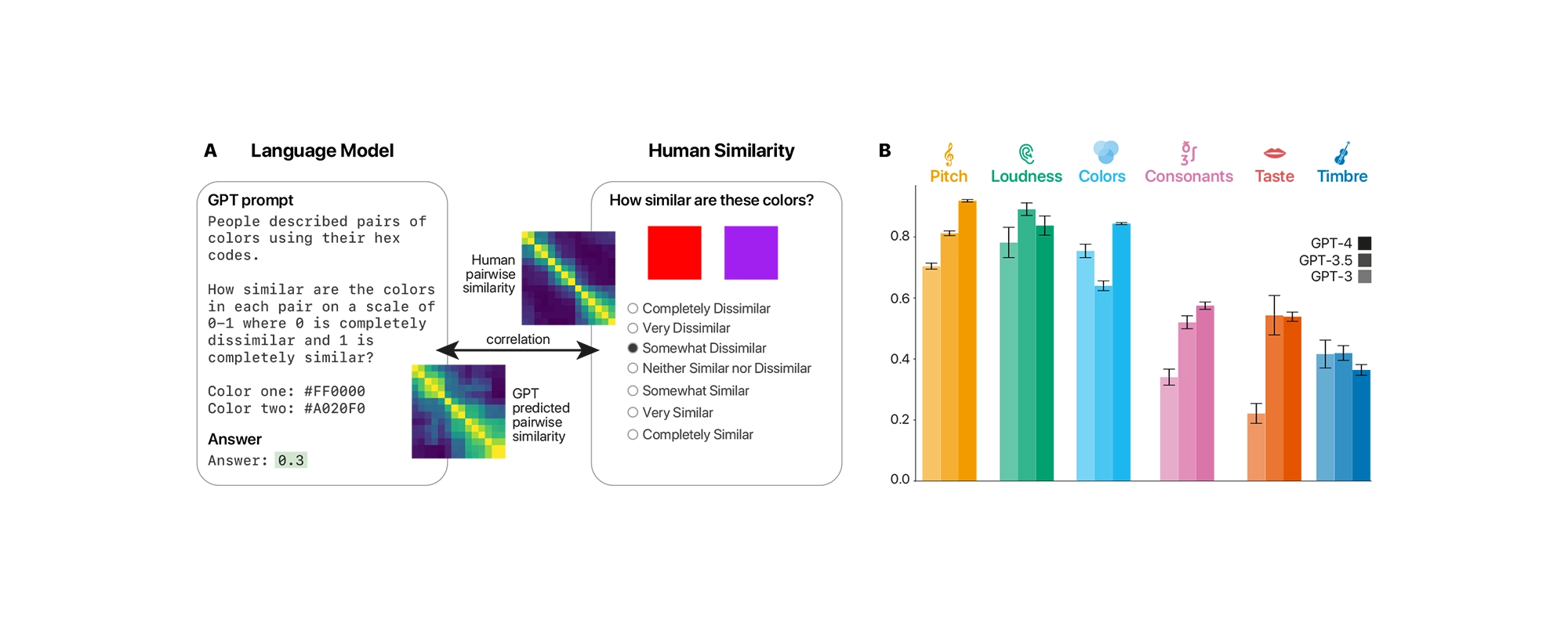

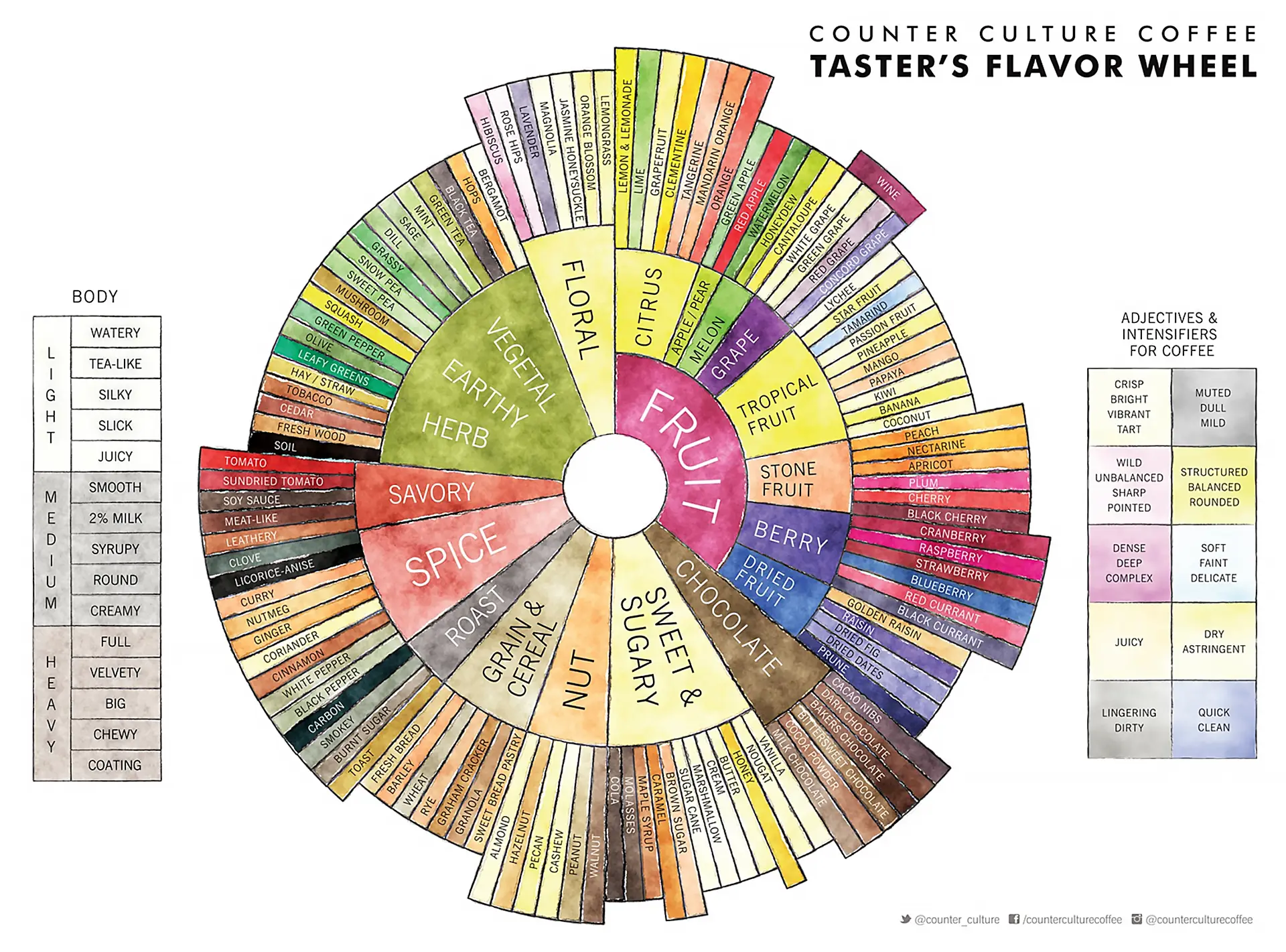

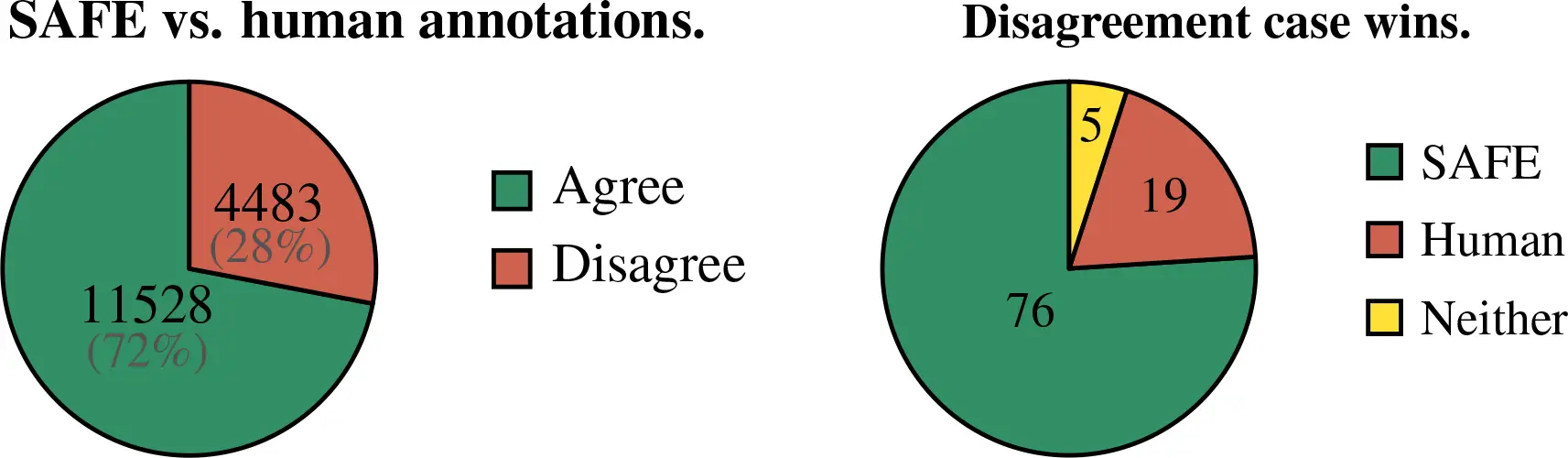

Тот же бесконечный, рекурсивный зал зеркал, описанный в главе 5 для внутренних состояний, также применим к нашим лингвистическим моделям внешнего мира. Статья 2023 года под названием «Большие языковые модели предсказывают человеческие сенсорные суждения по шести модальностям» прекрасно иллюстрирует это. Авторы статьи просят большую языковую модель оценить сходство между парами сенсорных стимулов на основе текстовых описаний.

Эти модальности включают в себя высоту звука, громкость, цвета, звуки согласных, вкусы и музыкальные тембры, которые описываются либо в количественных терминах (децибелы или герцы для звуков, числовые значения красного, зеленого и синего компонентов для цвета), либо по названиям («хинин», «искусственный подсластитель» и т.д. для вкуса; «виолончель», «флейта» и т.д. для тембра).

Языковые модели могут оценивать различия в восприятии цветов, получая числовые значения красного, зеленого и синего компонентов (закодированные здесь в широко используемом шестнадцатеричном формате #RRGGBB, со значениями от 00 до FF, или 255 в десятичной системе). Подобные подходы к другим модальностям могут быть использованы для вычисления корреляций с человеческими ответами. Эти корреляции, как правило, высоки и улучшаются с увеличением размера модели; Marjieh et al. 2023.

Языковые модели могут оценивать различия в восприятии цветов, получая числовые значения красного, зеленого и синего компонентов (закодированные здесь в широко используемом шестнадцатеричном формате #RRGGBB, со значениями от 00 до FF, или 255 в десятичной системе). Подобные подходы к другим модальностям могут быть использованы для вычисления корреляций с человеческими ответами. Эти корреляции, как правило, высоки и улучшаются с увеличением размера модели; Marjieh et al. 2023.

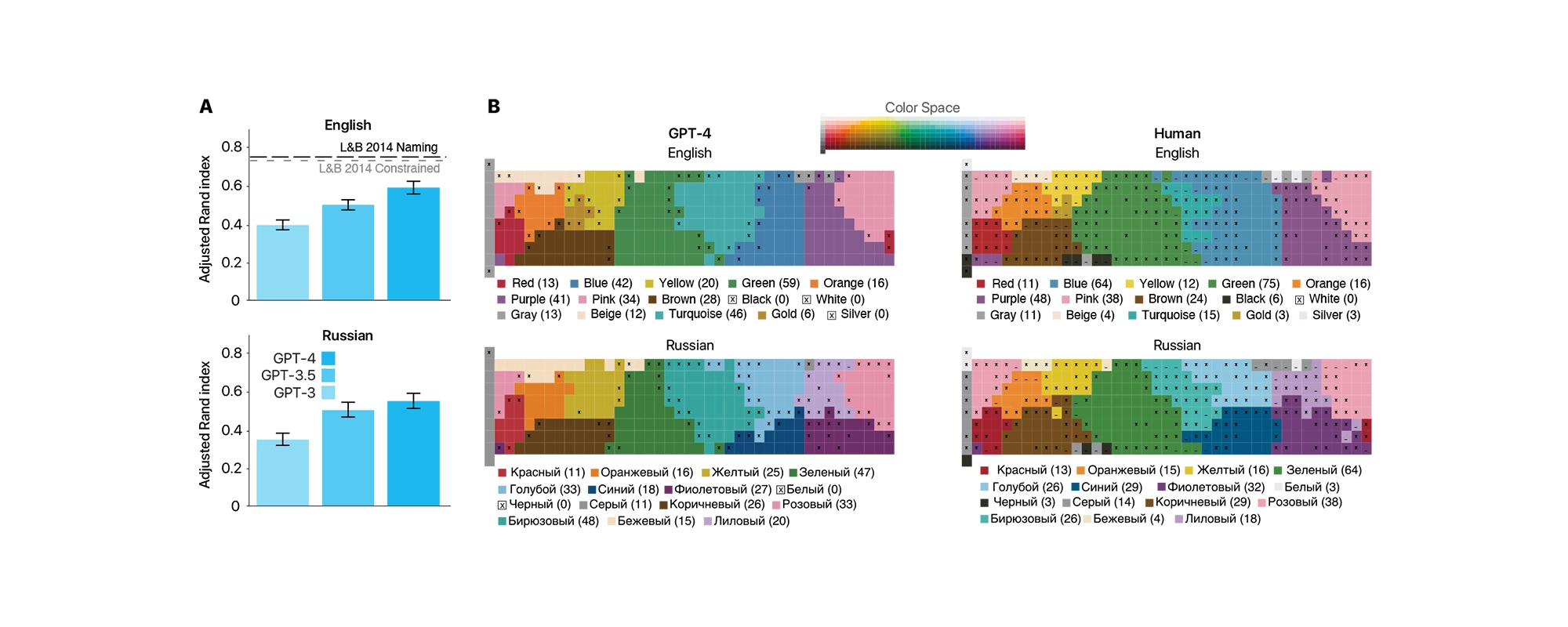

Языковые модели могут называть цвета. При этом они отражают то, как различные языки различаются в наименовании цветов, как показано здесь для английского и русского языков (которые особенно отличаются в отношении синего); Marjieh et al. 2023.

Несмотря на то, что модель обучена только на текстах, её ответы удивительным образом отражают человеческие реакции.

И, поразмыслив, это вполне логично: цель предварительного обучения — предсказать человеческие ответы на любой текстовый вопрос или запрос. Информация, необходимая для этих предсказаний, может быть найдена в достаточно большом корпусе обучающих данных, потому что мы говорим практически обо всем, что переживаем, включая всё, что воспринимаем, думаем и чувствуем — или, по крайней мере, всё, что доступно интерпретатору.

Чистая Речь

Несмотря на эти доводы, я раньше беспокоился, что обучение большой модели на текстах может быть обманом. Мы учимся читать и писать только после того, как овладеем речью; я не был уверен, что Трансформер сможет освоить язык, не начиная с транскрипции — где, по сути, уже была проделана сложная работа по преобразованию звука в символы. AudioLM убедил меня.

Языковые модели могут называть цвета. При этом они отражают то, как различные языки различаются в наименовании цветов, как показано здесь для английского и русского языков (которые особенно отличаются в отношении синего); Marjieh et al. 2023.

Несмотря на то, что модель обучена только на текстах, её ответы удивительным образом отражают человеческие реакции.

И, поразмыслив, это вполне логично: цель предварительного обучения — предсказать человеческие ответы на любой текстовый вопрос или запрос. Информация, необходимая для этих предсказаний, может быть найдена в достаточно большом корпусе обучающих данных, потому что мы говорим практически обо всем, что переживаем, включая всё, что воспринимаем, думаем и чувствуем — или, по крайней мере, всё, что доступно интерпретатору.

Чистая Речь

Несмотря на эти доводы, я раньше беспокоился, что обучение большой модели на текстах может быть обманом. Мы учимся читать и писать только после того, как овладеем речью; я не был уверен, что Трансформер сможет освоить язык, не начиная с транскрипции — где, по сути, уже была проделана сложная работа по преобразованию звука в символы. AudioLM убедил меня.

Проект начался, когда команда, которую я возглавлял в Google Research, разработала нейронную сеть для аудиомоделирования под названием SEANet, а затем в 2021 году превратила её в аудиокомпрессор SoundStream.

SoundStream использовал небольшой трансформер для преобразования аудиоволновых сигналов в последовательности токенов, основываясь на наблюдении, что хорошее предсказание позволяет добиться мощной компрессии. Поскольку трансформеры были лучшими предсказательными моделями на тот момент, и их ранее не использовали для сжатия сырого аудио, мы были уверены, что SoundStream установит новый рекорд сжатия звука. И он это сделал.

Затем, в 2022 году, команда создала AudioLM, вставив второй, гораздо более мощный трансформер, подобный тем, что используются в больших языковых моделях, между энкодером и декодером SoundStream.

Эту большую аудиомодель токенов предварительно обучили на звуковых дорожках видео с YouTube, где люди говорили на английском языке.

Результаты были потрясающими и несколько жутковатыми. После предварительного обучения на эквиваленте примерно семи лет аудио с YouTube модель смогла убедительно отвечать на простые запросы или вопросы. В одном из первых диалогов с AudioLM я спросил: «Какой твой любимый спорт?» и получил три альтернативных ответа (мы использовали ненулевую настройку температуры):

AudioLM пример

«Мне нравится бейсбол!»

«Не знаю? Мне нравится футбол.»

«Я играю в баскетбол.»

Любопытно, что все три ответа были произнесены детскими голосами. При дальнейшем размышлении это стало понятным. Это была предварительно обученная модель без какой-либо донастройки или дополнительного обучения с подкреплением, поэтому она строго занималась выдачей высоковероятностных предсказаний будущего (своего ответа), основываясь на прошлом (моем вопросе). Вы просто не спрашиваете взрослых: «Какой твой любимый спорт?» Это вопрос для детей. Поэтому она ответила вероятным ответом в вероятном голосе.

Для нас, людей, предсказания должны основываться на нашей индивидуальной истории жизни, начиная от физиологии нашего голосового тракта и заканчивая школьным опытом в спортивных командах. Однако модель, предварительно обученная на широком спектре человеческих голосов и опыта, не ограничена таким образом. В своем изменчивом состоянии модель «является» широким образцом человечества, а не единичным человеком.

С дальнейшими улучшениями архитектуры модели AudioLM, теперь называемой SoundStorm, она могла бы транслировать длинные ответы и продолжать диалоги с несколькими участниками. Два члена команды задали ей вопрос:

«Куда ты ездил прошлым летом?»

«Я ездил в Грецию. Это было потрясающе.»

Модель без труда импровизировала продолжение разговора, чередуя идеальные воспроизведения их голосов (и да, потенциал глубоких фейков здесь вызывал немалые опасения):

SoundStorm пример

«О, это здорово. Я всегда хотел поехать в Грецию. Какое место тебе понравилось больше всего?»

«Эм, сложно выбрать только одно любимое место. Но… да, мне действительно понравилась еда. Морепродукты были особенно вкусными—»

«Угу—»

«—а пляжи были невероятными.»

«Угу—»

«Мы много времени проводили, плавая… эм, загорая и исследуя острова.»

«О, это звучит как идеальный отпуск. Мне так завидно.»

«Это определенно была поездка, которую я никогда не забуду.»

«Я очень надеюсь, что смогу посетить это место someday.»

Это не было блестящим диалогом, но оно было совершенно правдоподобным. Нюансы голосов, их акценты и манеры были воспроизведены так идеально, что даже те из нас, кто хорошо знает этих двух членов команды, не смогли бы угадать, какие реплики были настоящими, а какие синтезированными. Модель воспроизводит дыхание, запинки, звуки согласия, людей, говорящих друг с другом — короче говоря, все те черты, которые характеризуют настоящий диалог, в отличие от стилизованного, который вы читаете в романах.

В конечном итоге команда сделала AudioLM мультимодальной, добавив текст, создав AudioLLM.

Так же, как перевод между языками возможен в больших языковых моделях с минимальным или отсутствующим количеством явно переведенных данных, для AudioLLM потребовалось всего лишь небольшое количество транскрибированной речи, чтобы установить связь между речью и текстом. Внутренние корреляции, присущие речи, достаточно для формирования внутренних представлений, примерно аналогичных фонемам, так что теоретически (особенно в языке с разумной орфографией, как испанский) достаточно было бы абзаца произнесенного текста, чтобы сопоставить каждую букву с фонемой, подобно тому, как Розеттский камень позволил установить соответствие между двумя письменными языками. На самом деле, учитывая более высокие корреляции и аналогии между текстом и речью, я уверен, что при достаточном количестве предварительных данных модель в стиле AudioLLM могла бы усвоить эти аналогии без какого-либо произнесенного текста.

Однако самое интересное в оригинальном AudioLM заключалось в его способности учиться и понимать язык на основе чистого аналогового звука, без текста или какой-либо другой модальности. Модели не были даны никакие правила, предположения или символы. Это было поразительным опровержением давней гипотезы о том, что для изучения языка требуется генетическое предустановление.

Отец лингвистики двадцатого века Ноам Хомский выдвинул влиятельный псевдоматематический аргумент о «бедности стимула», утверждая, что количество речи, которому подвергаются младенцы, не может быть достаточным для того, чтобы они выучили грамматику естественного языка без сильного статистического приоритета.

Такой сильный приоритет, «универсальная грамматика», общая для всех человеческих языков, должен находиться внутри гипотетического, генетически предустановленного «языкового органа». GOFAI хорошо сочетается с этой идеей, поскольку подразумевает, что способ заставить компьютер обрабатывать язык — и, возможно, рассуждать — заключается в явном программировании этой универсальной грамматики, тем самым ограничивая роль изучения языка более простой задачей — закреплением языковых «настроек».

Аргумент Хомского уже сталкивался с трудностями до появления LLM, по ряду причин.

Как уже упоминалось, человеческие языки различаются во множестве аспектов, и поиск предполагаемой универсальной грамматики оказался безуспешным. Нейронаука также не предоставила значительных доказательств в поддержку этой теории. «Интерпретатор» в левом полушарии действительно специализируется на языке, но, как и любая другая часть коры, его специализация, похоже, зависит от связей, а не от какого-то «языкового органа», волшебной пыли, рассыпанной в этом конкретном месте.

Способ, которым младенцы и дети учатся языку — начиная с внимательного наблюдения за мамой или папой, следя за их взглядом или указанием, указывая в ответ, подражая звукам, обучаясь очередности, осваивая несколько ярких слов и начиная комбинировать их в стандартные фразы — также кажется несоответствующим использованию или усвоению формальной грамматики. Младенцы — быстрые и удивительные ученики, но это не означает, что они маленькие лингвисты, учёные или представители каких-либо других «истов».

AudioLM вносит последний гвоздь в крышку гроба «бедности стимула». Хотя все модели машинного обучения имеют свои статистические приоритеты, трансформеры настолько универсальны, что могут учиться на любых звуках, включая музыку, пение птиц или песни китов; более того, они могут изучать треск данных радиотелескопов, погодные паттерны или последовательности пикселей на изображениях. Тем не менее, они могут изучать человеческий язык — от звучания голосовых трактов до грамматики, значений слов, социальной уместности и очередности, до нюансов дыхания и других несpeech звуков — всего лишь на основе семи лет случайного аудио с YouTube, где люди разговаривают.

Прежде чем вы возразите, что дети учатся говорить на аналогичном уровне менее чем за семь лет и не слушают речь постоянно в течение этого времени, подумайте, насколько им легче: их обучение поддерживается множеством других сенсорных модальностей, а в начале родители и братья сёстры многократно повторяют одни и те же слова одним и тем же голосом, указывая на знакомые вещи, делая жесты, связанные с едой, и так далее. То, что язык может быть усвоен вообще без этой поддержки, без взаимодействия, без учебной программы и без вознаграждений, — это поразительно.

Ничто из этого не подразумевает, что язык полностью произволен. Он должен начинаться с тех звуков, которые человеческие тела могут легко производить и слышать, что уже является значительным ограничением. Он также должен быть достаточно эффективным и не перегружать наши когнитивные способности (например, настаивая на том, чтобы общее слово произносилось, быстро щелкая языком тридцать девять раз подряд). Действительно, исторические данные показывают явные свидетельства того, что языки с запутанными особенностями со временем становятся более упрощёнными, что делает их всё более удобными для пользователей.

Однако статистические закономерности, которые здесь задействованы, имеют мало общего с формальной грамматикой и больше связаны с удобством, а также с ограничениями на память, голосовой тракт и различимость звуков.

Рыба Бабель

Хотя универсальной грамматики не существует, безусловно, имеются множество статистических взаимосвязей между языками — иначе эксперименты по переводу, описанные в главе 8, не работали бы. Некоторые корреляции происходят от человеческой физиологии и когнитивных ограничений, а некоторые — от общего предка языков. Многие языки тесно связаны, как романские языки, а другие более отдалённо, как индоевропейские. Возможно, все языки имеют общего предка, хотя это остаётся неопределённым.

Здесь также играют роль ономатопея и синестезия. Неудивительно, что «мяу» и «плюх» звучат похоже во многих языках, даже если слова не имеют общего предка.

Менее очевидно, но особенности отношений между сенсорными представлениями в мозге также приводят к тому, что большинство людей принимают одно и то же решение, когда дело доходит до ассоциации бессмысленных слов «буба» и «кики» с двумя формами: одной с острыми углами и другой округлой. (Да, «кики» — это острая форма.) Этот классический результат в психологии, восходящий к 1920-м годам, показывает, как аспекты синестезии, кажущейся произвольной умственной ассоциации между различными стимулами, которые некоторые люди утверждают, что испытывают в сильной степени, имеют универсальную нейронную основу.

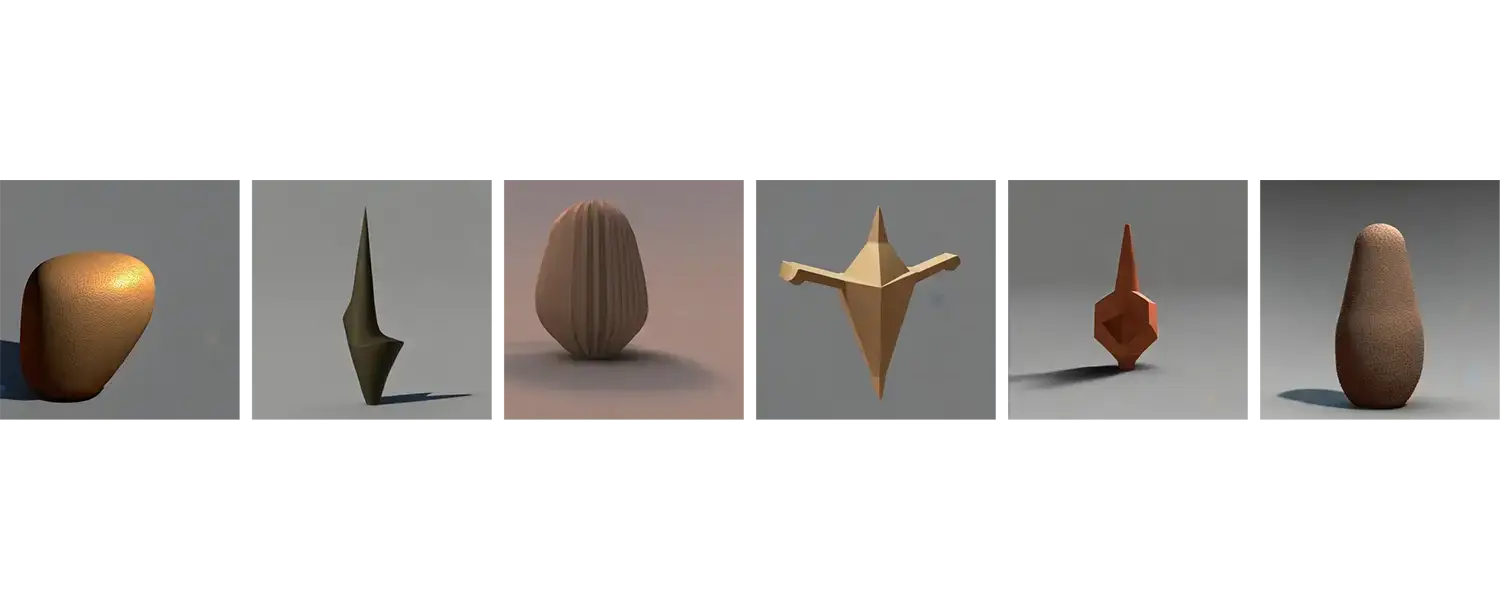

Будь то потому, что эти ассоциации не так произвольны, как кажутся, или потому, что они неявно отражены в человеческих языках, мультимодальные большие языковые модели также надежно демонстрируют эффект «буба/кики».

Классические формы «кики» (слева) и «буба» (справа)

Случайные генерации из модели Stable Diffusion с использованием запроса «3D-рендеринг объекта в форме _____», где пустое место было заполнено: (прокрутите, чтобы увидеть)

Прежде всего, языки связаны между собой, потому что они все о нас и о мире, и мы все по сути одинаковы, и все мы живем в одном и том же мире. Настоящая универсальная грамматика — это на самом деле семантика. Я вполне уверен, что если бы племя людей каким-то образом оказалось изолированным от всех остальных при рождении и разработало язык de novo на своем собственном острове, модель AudioLM, предварительно обученная на достаточном количестве их речи и, независимо, на английском, смогла бы свободно переводить между двумя языками без необходимости в Розеттском камне.

В «Автостопом по Галактике», удивительно глубокой сатире, любимой поколениями двенадцатилетних задротов, британский юморист Дуглас Адамс описывает «умопомрачительно полезное» научно-фантастическое существо — «рыбу Бабеля». «Маленькая, желтая и похожая на пиявку», когда вы помещаете одну в ухо, «вы мгновенно понимаете все, что вам говорят на любом языке».

Такой технологии действительно было бы невероятно полезно, даже если она была бы ограничена семью тысячами языков, на которых сегодня говорят люди на Земле.

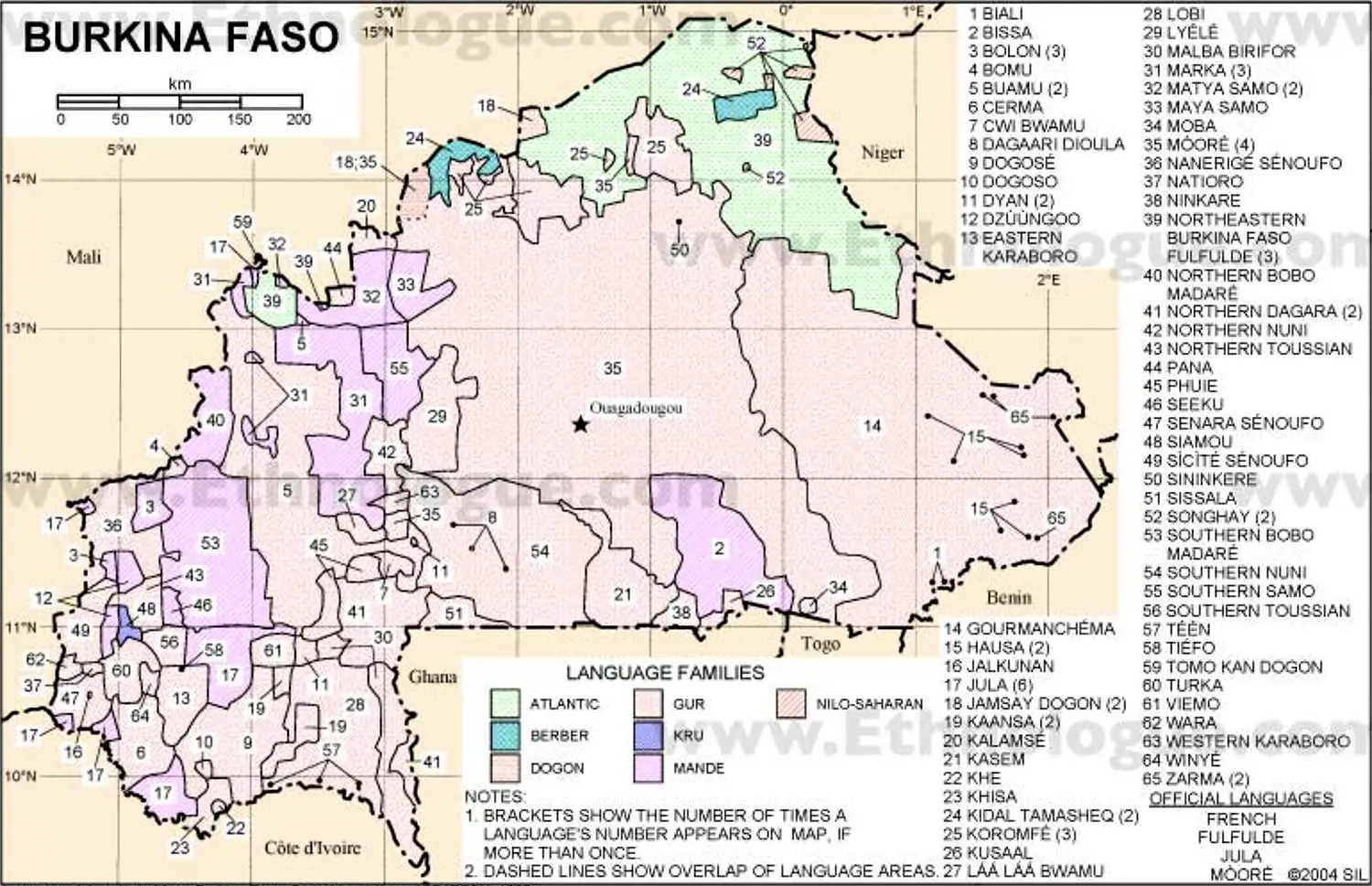

Во-первых, языковые барьеры представляют собой огромную преграду для социально-экономической справедливости для многих бедных стран мира. Например, в Буркина-Фасо, безвыходной стране Западной Африки, говорят примерно на семидесяти языках, шестьдесят шесть из которых являются коренными. По состоянию на 2024 год уровень грамотности составляет около сорока процентов. Хотя правительство использует французский язык (деоколоизация началась лишь в 1960 году), этот бывший имперский язык знает лишь небольшая часть населения.

Карта (безусловно, неполная) языков, на которых говорят в Буркина-Фасо, стране примерно размером с Колорадо.

В таких странах «рыба Бабеля» могла бы значительно улучшить перспективы людей, предоставив им доступ к информации, трудоустройству, услугам, образованию и возможностям развития, которые сегодня недоступны. Более того, поскольку настоящая «рыба Бабеля» на основе нейронных сетей может работать в режиме полного дуплекса и даже предлагать репетиторство и участвовать в беседе, она могла бы помочь в сохранении коренных культур и их языков.

Имейте в виду, что в бедных странах население гораздо моложе, а рождаемость выше, чем в более развитых странах; по мере того как страны становятся богаче, их рождаемость неизбежно снижается, но из-за временных задержек в этих процессах мы должны понимать, что население таких стран, как Буркина-Фасо, уже многочисленное, будет составлять гораздо большую долю человечества в последней части двадцать первого века, чем сегодня. Это будущее человечества.

Если мы начнем рассматривать человечество как суперорганизм, то здесь на кону стоят масштаб, разнообразие и сплоченность нашего коллективного интеллекта. Без поддержки разнообразия его народов и культур мы уменьшаем ценность, которую каждый из них может предложить другим, а также потенциал для гибридности, который критически важен для культурных инноваций и развития.

С другой стороны, без масштаба коллективный интеллект обедняется; трудно, чтобы изолированное население или захолустный регион процветали.

Существует некая «золотая середина», где местная связь (в культурном смысле — традиция) достаточно сильна, чтобы обеспечить реальное разнообразие, но при этом имеется достаточно долгосрочных связей для обмена знаниями, возможностями и ресурсами. Кора головного мозга воплощает этот баланс, обладая плотной связью внутри корковых колонок и дальнодействующими соединениями, которые приносят преимущества масштаба. Изобилие культурной и экономической продуктивности Шелкового пути, возможно, было достигнуто благодаря аналогичному балансу.

На протяжении многих веков активно действующие торговые сети связывали десятки крупных городов и тысячи мелких поселений по всей Евразии, каждое из которых имело сильные и разнообразные местные культуры, но также извлекало выгоду из масштаба. Лаборатория знаний Джеймса Эванса в Чикагском университете обнаружила доказательства существования аналогичной «золотой середины» в более абстрактных сетях сотрудничества среди ученых. Научные достижения происходят, когда крепкие, тесно связанные исследовательские сообщества находятся в контакте друг с другом, сочетая местную глубину с более широким разнообразием.

Сегодня мы одновременно недо- и пере-соединены. Молодые люди в таких местах, как Буркина-Фасо, остаются изолированными, в то время как культурная и языковая однородность угрожает стереть богатое человеческое разнообразие мира, так же как генетические монокультуры промышленного сельского хозяйства угрожают биоразнообразию. Лингвистически проблема заключается в том, что около семи тысяч языков, на которых говорят на Земле, следуют частотному распределению, которое, как сказал бы статистик, имеет очень длинный хвост, что означает наличие большого количества редких категорий. Самые редкие, так называемые «языки с низкими ресурсами», находятся на грани исчезновения, и один из них вымирает каждые несколько месяцев с уходом последнего живого носителя.

Хотя новые языки раньше развивались и объединялись с сопоставимой (или даже более высокой) скоростью, растущая глобализация нарушила этот баланс. Как говорится в отчете ЮНЕСКО 2003 года: «Около девяноста семи процентов населения мира говорит на четырех процентах языков мира; и наоборот, около девяноста шести процентов языков мира используются лишь тремя процентами населения […]. Даже языки с тысячами носителей больше не осваиваются детьми […], и в большинстве регионов мира к концу двадцать первого века около девяноста процентов языков могут быть вытеснены доминирующими языками».

Логарифмическая диаграмма, основанная на данных Ethnologue.com, оценивающая количество носителей тысячи самых распространенных языков в начале 2000-х; Занетте и Манрубия 2007.

Это выравнивание нашей культурной и языковой экологии ускорилось с начала 2000-х, когда люди начали массово выходить в интернет. Английский язык доминирует в сети, а лишь несколько других языков (не случайно, связанных с бывшими великими империями) составляют подавляющее большинство материалов, не относящихся к английскому. Дата-центры теперь содержат в десятки раз больше текстового материала, чем существовало в мире, когда вышел отчет ЮНЕСКО 2003 года. С другой стороны, большинство коренных языков практически отсутствуют в этом обширном цифровом пространстве.

С помощью моделей последовательностей без контроля стало возможно создать настоящую «рыбу Бабеля» — и не только это. Не следует рассматривать это как специализированный «продукт», поскольку перевод — это возникающая способность в любой модели, обученной на нескольких языках. Огромная многоязычная версия AudioLLM могла бы позволить ей изучать языки по полевым записям; она могла бы даже изобрести письменные формы для языков, у которых их нет. Диалекты, акценты и региональные вариации также могли бы быть изучены. С помощью AI-очков вы могли бы читать шумерские таблички или арамейские манускрипты.

Мультимодальная модель могла бы даже дублировать видео в реальном времени или создавать аватар, способный мгновенно воспроизводить жесты на любом из мировых жестовых языков. Однако есть одна проблема — это распределение языков с длинным хвостом. Учитывая огромное количество данных, необходимых для предварительного обучения, как же большая модель сможет освоить региональный диалект Буркина-Фасо, не говоря уже о критически угрожаемом коренном языке, известном лишь нескольким старейшинам?

Завет

К 2021 году мои коллеги из Google Research начали активно работать над многоязычными большими языковыми моделями и заметили нечто интересное: изучение одного языка значительно ускоряет последующее освоение другого. Например, предварительное обучение на огромном количестве текстов на английском языке, а затем продолжение обучения на сравнительно небольшом объеме, скажем, португальского, приводит к созданию компетентной билингвальной модели. Она может не быть столь же хороша в португальском, как в английском, но если бы ее обучали только на португальском, ей потребовалось бы в разы больше контента на этом языке, чтобы достичь аналогичного уровня навыков.

Этот эффект настолько силен, что начало с многоязычной модели, а затем продолжение предварительного обучения, используя только текст Нового Завета на новом языке, создает модель, способную на элементарный перевод на этот новый язык или с него. Это особенно примечательно, поскольку христианские миссионеры перевели Новый Завет более чем на 1600 языков — это неплохое начало для работы с длинным хвостом.

К лучшему или худшему, миссионеры долгое время были авангардом этнографической лингвистики. Настоящая преданность требуется от ученых из богатых стран, чтобы покинуть родину, погрузиться в чужую культуру и изучить достаточно местного языка и культуры для перевода сложного текста, иногда в процессе создавая письменную форму для языка, который ранее существовал только в устной традиции.

Исторически религиозная вера и стремление обратить в свою веру часто служили необходимой мотивацией; именно поэтому Новый Завет является самым широко переведённым текстом на Земле.

Сегодня большую часть этой работы выполняет SIL Global (ранее Летний институт лингвистики), евангельская христианская некоммерческая организация, основанная в 1934 году и расположенная в Далласе. Онлайн-база данных SIL, Ethnologue, является наиболее полным каталогом известных языков благодаря тысячам полевых лингвистов, работающих в сообществах по всему миру.

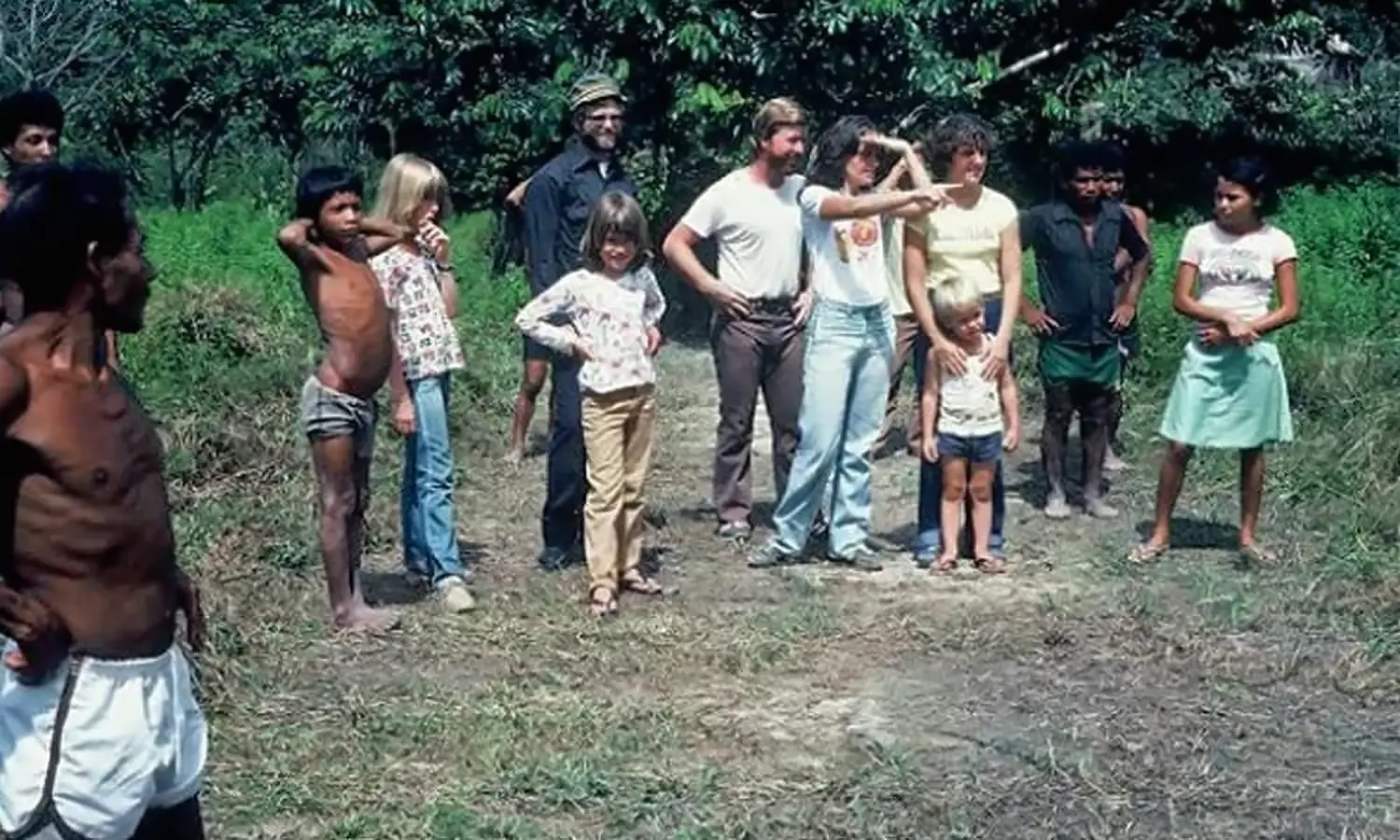

В 1977 году Даниэль Эверетт, недавно окончивший Библейский институт Муди в Чикаго, подписал контракт, чтобы стать одним из этих миссионерских лингвистов. Впечатлённые его талантом, SIL отправила его вместе с женой Керен и тремя маленькими детьми изучать язык, который Институт не смог разгадать за двадцать лет: язык пиратов, коренного народа, численность которого составляет менее тысячи человек и который живёт в бразильском тропическом лесу, недалеко от устья реки Маиси, притока Амазонки.

Эверетты вскоре после прибытия к пиратам в качестве миссионерской семьи

Даниэль Эверетт проводит языковые исследования среди пиратов много лет спустя

Несмотря на сложность языка, Эверетт в конечном итоге смог его выучить и, в процессе, значительно подорвал теории Хомского о универсальной грамматике. У пиратов отсутствует «лингвистическая рекурсия» — способность вкладывать грамматические структуры друг в друга. Например, у пиратов нет эквивалента английской фразы «дом брата Джона». По мнению Хомского, рекурсия — это то, что делает языки открытыми, отличая их от конечных систем коммуникации не человека. И действительно, без рекурсии конечный словарный запас может быть использован только для построения конечного числа корректных предложений.

Отсутствие рекурсии на практике оказывается не таким ограничивающим, как может показаться; носитель языка пираха может разбивать сложные идеи на несколько предложений, например: «У Джона есть брат. У этого брата есть дом». Однако у пираха также отсутствуют несколько других признаков, характерных для большинства языков, включая прошедшее и будущее время, условные конструкции и числительные. Эти пробелы не являются поверхностными. Одноязычные носители пираха, например, не просто не имеют слов для чисел, но и не обладают никаким представлением о количественности, кроме качественного различия между «одним» и «больше одного». Они вообще не могут заниматься математикой.

Аналогично, отсутствие времен и контрфактов связано с мировоззрением, которое признает только прямой опыт. Предложение, начинающееся со слов «Джон сказал, что...», представляет собой не только проблему перевода, но и эпистемическую задачу.

▶ Дэниел Эверетт обсуждает количественность с пираха

Более широкая картина показывает, что широкий спектр когнитивных способностей, которые Хомский и его последователи считали генетически предопределенными, таковыми не являются. Числа и глагольные времена — это, как и чтение, социальные технологии. Человеческие мозги особенные не потому, что эволюционировали с определенным набором способностей, а благодаря гибкости, способности и стремлению учиться этому как из собственного сенсорного опыта, так и от других.

Как вы можете себе представить, Эверетту не удалось убедить народ, которому не нужно то, что говорил Джон или любой другой евангелист первого века. С большим трудом Эверетт смог перевести Евангелие от Марка, но когда он попытался объяснить, что Иисус жил очень давно, а он, Эверетт, все еще имеет слова Иисуса, ответ был: «Ну, Дэн, как ты можешь иметь его слова, если никогда не слышал его и не видел?» Сострадая, один из пираха отвел Эверетта в сторону и объяснил: «Нам не нужен Иисус. Но ты нам нравишься. Ты можешь остаться с нами. Но мы не хотим больше слышать о Иисусе».

Эверетт остался с ними.

Замечательная книга, которую он написал три десятилетия спустя, «Не спи, там змеи», описывает не только необычные особенности языка пиратов, но и то, как жизнь среди них в конечном итоге заставила его отказаться от собственной веры, вместо того чтобы обратить их в свою!

Длинные хвосты

Мне кажется увлекательным задуматься о том, что работа по переводу Библии, которую проделали тысячи миссионеров на протяжении многих лет, могла бы так эффективно послужить основой для многоязычных моделей ИИ. С помощью большой модели типа AudioLM, предварительно обученной на множестве разговорных языков, записи нескольких десятков часов бесед старейшин, говорящих на редком языке, вероятно, смогли бы достичь того же результата.

Здесь есть кажущаяся парадоксальность. С одной стороны, улучшения большой модели, похоже, подвержены убывающей отдаче по мере увеличения объема предварительного обучения — отсюда и ненасытный аппетит ИИ к данным. Другими словами, обучение на двухстах миллиардах токенов веб-контента не дает вдвое лучших результатов по сравнению с обучением на ста миллиардах токенов; оно лишь немного лучше. На самом деле, чтобы удвоить производительность модели, требуется экспоненциально больше данных, а также экспоненциальное увеличение числа параметров модели.

Тем не менее, мы также видим, что крошечное количество дополнительных данных на новом языке может позволить модели перейти от монолингвизма к билингвизму, что кажется удвоением её возможностей. Если мы фиксируем количество нового языкового контента и варьируем исходный объем данных для предварительного обучения, результаты билингвизма улучшаются по мере увеличения объема начального предварительного обучения. То есть, чем больше и способнее исходная модель, тем лучше она может использовать очень ограниченное количество нового языкового контента. Как эти модели могут одновременно демонстрировать логарифмически убывающую отдачу от масштаба и при этом казаться экспоненциально более быстрыми учениками по мере роста? Парадоксально, но эти два эффекта оказываются тесно связанными.

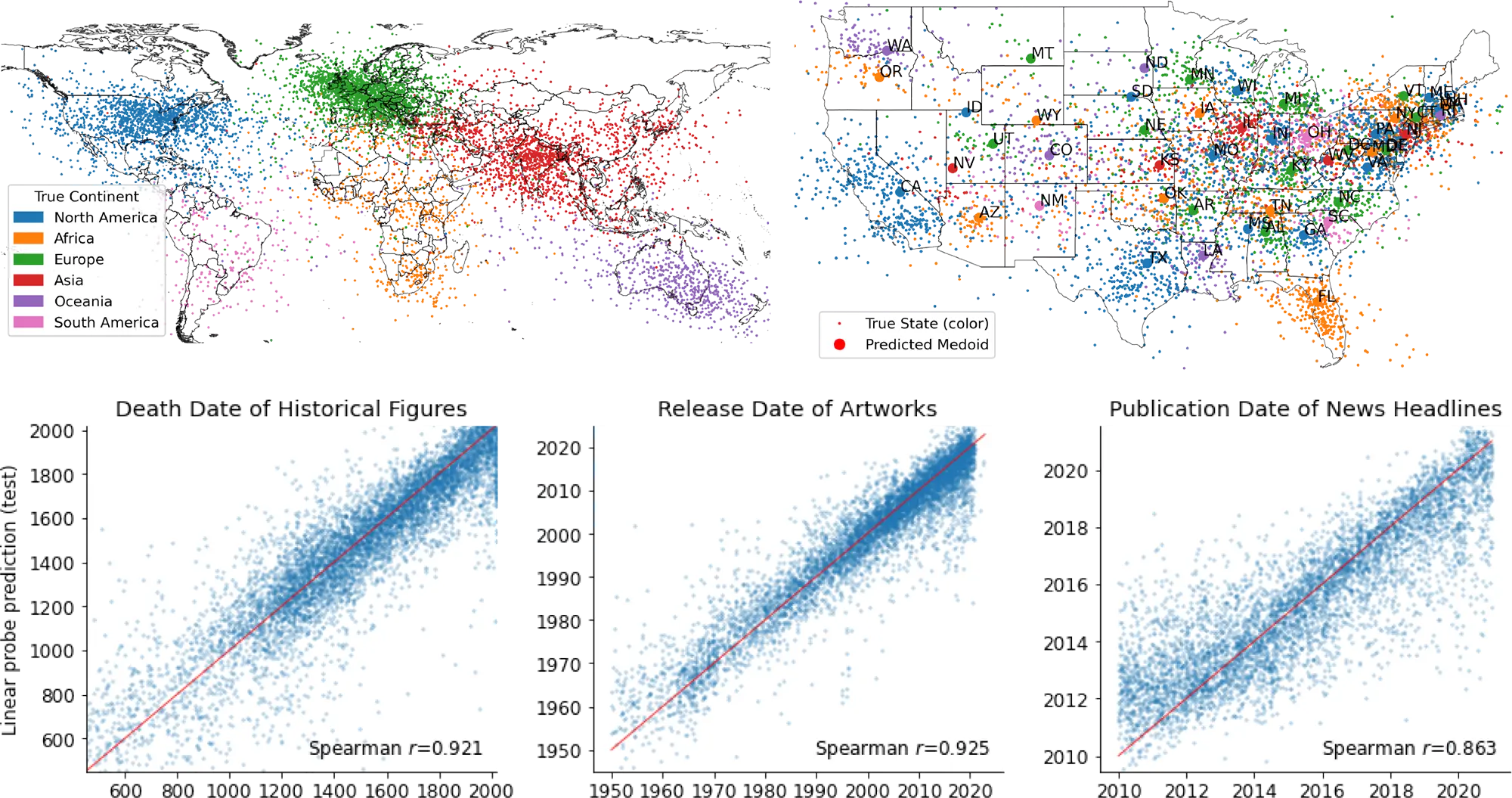

Помните, что перевод возникает как автоматическая способность в больших языковых моделях, поскольку это форма аналогии. В частности, облако точек, представляющее векторные представления слов или концепций в языке A, соответствует почти идентичному облаку точек, представляющему все слова или концепции в языке B; переход от одного облака к другому — это буквально вопрос добавления или вычитания постоянного сдвига в пространстве векторных представлений. Форма каждого из этих облаков, в свою очередь, отражает человеческое umwelt , геометрию всего, о чем мы знаем, как говорить.

Симметрия между этими облаками— если модель является массово многоязычной, то это многослойная симметрия— предлагает мощные возможности для обобщения, а обобщение — это то, чем занимается интеллект. Напомним, что, как только сверточная сеть научится видеть в общем смысле, она может легко узнать, как выглядит новый объект с одного взгляда, потому что обучение видеть включает в себя создание универсального представления для объектов, которое охватывает все симметрии, возникающие при вращении любого данного объекта в пространстве, при взгляде на него с большего или меньшего расстояния, изменении освещения и так далее. Точно так же, изучение как универсальной формы человеческого umwelt , так и симметрий между языками позволяет изучить новый язык в чем-то, что приближается к одному взгляду— или одной книге, как Новый Завет.

Почему же тогда мы наблюдаем такие убывающие отдачи от масштаба в предварительном обучении? Здесь важно помнить, что если мы смешаем образцы из двух очень неравномерно представленных языков, скажем, девяносто девять процентов предложений на английском и одно процентное предложение на волоф (язык Западной Африки), мы увидим привычные убывающие отдачи от комбинированных данных. Только когда мы изолируем предложения на волоф и обучаемся на них только после обучения на английском, мы видим доказательства ускоренного освоения волоф.

В смешанных данных предложения на волофе будут представлять собой необычайно важные примеры для обучения с новым содержанием, но суть в том, что все наборы данных — включая предложения, написанные исключительно на английском — в основном повторяются, лишь изредка добавляя новую информацию. Даже в монолингвальном наборе данных слова и концепции имеют длинный хвост распределения, подобно распределению самих языков.

Длинные хвосты подобного рода являются характерной чертой мультифрактальных свойств данных: детали имеют свои детали, и эти детали имеют свои собственные, еще более эзотерические детали. Язык и знания в целом обладают такими мультифрактальными свойствами. Математика может составлять лишь один процент от обширного мира тем, о которых мы говорим. Технические обсуждения среди специалистов STEM могут составлять лишь один процент от математических разговоров (остальное в основном занимает арифметика, которую дети изучают в классе, или базовый учет, или дележ счета в ресторанах). Среди этих специалистов один процент обсуждений может касаться теории чисел. В рамках теории чисел, возможно, один процент разговоров касается, скажем, гипотезы о p-кривизне Гротендика–Кац.

Умножив эти четыре процента на восемь миллиардов людей на Земле, мы получаем восемьдесят читателей, если моя школьная математика верна, что кажется вполне разумным для этого конкретного сообщества интересов. Гипотеза о p-кривизне Гротендика–Кац тоже не уникальна; не каждый способен заниматься такой эзотерической математикой (я не способен), но многие увлекаются чем-то одним или другим. Самые замысловатые теории заговора сторонников плоской Земли, глубокие закоулки фанатской литературы по Покемонам и мастера, которые сохраняют искусство ручного производства аккордеонов, также представляют собой тонкие детали в Мультифрактале Всего человечества.

Можно нарисовать карикатуру на предобучение следующим образом. Предположим, что для того, чтобы наткнуться на новую концепцию после прочтения определенного количества предложений наугад, вам нужно прочитать на один процент больше.

Если вы модель, это означает, что первые сто предложений, с которыми вы столкнетесь на своем первом этапе обучения, скорее всего, будут содержать совершенно новую информацию. Но после прочтения нескольких сотен предложений только одно из двух добавляет что-то новенькое. Прочитав миллион предложений, вам, вероятно, придется прочитать еще десять тысяч, прежде чем вы наткнетесь на что-то, чего не видели раньше.

Вот почему обучение замедляется — не потому что оно становится менее эффективным, а потому что при случайном отборе вероятность встретить что-то действительно новое в следующем фрагменте данных резко снижается в зависимости от того, сколько вы уже знаете.

Обучение в контексте

Компании, такие как Microsoft и Google, теперь предварительно обучают крупные модели на значительной части всего Интернета; социальные сети также все чаще оказываются в этом миксе. Некоторые аналитики указывают на то, что при таком темпе, даже учитывая продолжающийся экспоненциальный рост цифровых данных, мы вскоре столкнемся с нехваткой контента.

Критики считают этот, казалось бы, бездонный спрос на контент, созданный людьми, проблематичным по концептуальным, этическим и практическим причинам: предварительное обучение кажется очень отличным от того, как учатся люди, подчеркивая неэффективность современных подходов к машинному обучению и подогревая аргументы о том, что модели ИИ на самом деле ничего не понимают, а просто являются гигантскими запоминателями. Хотя я привел ряд доказательств, что это не так, этот вопрос остается актуальным в исследованиях ИИ; словно ни один тест ИИ не может быть закрытым, потому что модель уже прочитала, сжала и, возможно, запомнила некое приближение к «всему».

Возникают опасения по поводу законности и этичности использования контента стольких людей таким образом. Даже когда законность не вызывает вопросов, мало кто из этого материала был создан с намерением стать пищей для ИИ. И как только конкретный медиафайл был использован в предварительном обучении, становится трудно определить, влияет ли он и в какой степени на последующий вывод модели.

Особенно когда ИИ создает интеллектуальную собственность или иным образом производит экономическую ценность, это поднимает вопросы о том, что такое «добросовестное использование» и когда что-то является уникальным, а когда — «производным произведением».

Экстремальный промышленный масштаб предварительного обучения, как в плане данных, так и вычислительной мощности, ограничивает создание крупнейших «передовых» моделей лишь очень небольшим числом компаний и правительств, способных делать масштабные капитальные инвестиции.

С одной стороны, это может быть благословением (пока это продолжается), так как позволяет предотвратить самые опасные применения продвинутого ИИ, по крайней мере, в теории; это было бы невозможно, если бы любой мог создать свою собственную модель. Однако такая ситуация вызывает опасения по поводу монополии, недобросовестной конкуренции и разнообразия ИИ.

Самая глубокая теоретическая трудность подхода к предварительному обучению заключается в том, как он отделяет обучение от вывода — нежелательное наследие ранних дней кибернетики. Это означает, что модель, в некотором смысле, заморожена во времени; когда вы начинаете с ней взаимодействовать, она не знает о том, что произошло в мире после даты, когда были собраны данные для предварительного обучения. Фактически, у нее полная антероградная амнезия.

Ни одна из этих проблем не так проста, как кажется.

Что касается #1, неестественности предварительного обучения, я подозревал на протяжении многих лет, что метод обратного распространения ошибки, который в настоящее время универсально используется для обучения крупных моделей, но давно признан не биологически правдоподобным (согласно главе 7), был виновен. Я думал, что наш мозг реализует блестящий алгоритм обучения, который значительно улучшил бы обратное распространение.

В противном случае, как же нам удалось вырасти из беспомощных новорожденных в умных студентов колледжа всего за восемнадцать лет, большую часть которых мы провели во сне, мечтая наяву, смотря бессмысленные мультфильмы, играя в 8-битные видеоигры, избегая родителей и куря травку за школьным мусорным контейнером?

Мозги действительно могут реализовывать какую-то гиперэффективную нейронную магию, но становится все более очевидным, что значительная часть недостатков в предварительном обучении связана с подходом, напоминающим фуа-гра, к обучающим данным. Мы берем все, что можем найти в Интернете, перемалываем это в пасту и насильно запихиваем в глотку нейронной сети в случайном порядке, не обращая внимания на учебный план, актуальность, избыточность, контекст или агентность самой модели. (Извините, если это испортило вам аппетит.)

Действительно, контраст между обычными убывающими доходами от увеличения объема обучающих данных и ускоренным обучением, которое мы наблюдаем при продолжении предварительного обучения на новых данных (как в примере с волоф), говорит о многом. Это предполагает, что большая часть сегодняшнего предварительного обучения избыточна. Чем больше становятся наши модели, тем более расточительным становится подход случайной выборки. Короче говоря, проблема может заключаться в обучении, а не в процессе усвоения.

Что касается пункта #2, то хотя ИИ подстегивает дебаты о «добросовестном использовании» благодаря своей скорости и масштабу, вопрос оригинальности уже десятилетиями вызывает горячие споры, так как он не специфичен для ИИ; всякое творческое произведение неизбежно является продуктом жизненного опыта человека, который включает в себя все, что он когда-либо видел, слышал, трогал, нюхал, пробовал, читал… и, несмотря на любые самовыгодные истории, которые может рассказать наш интерпретатор, мы часто не осознаем свои влияния или степень, в которой мы скрыли свои следы через мутацию и рекомбинацию, известные как «оригинальность».

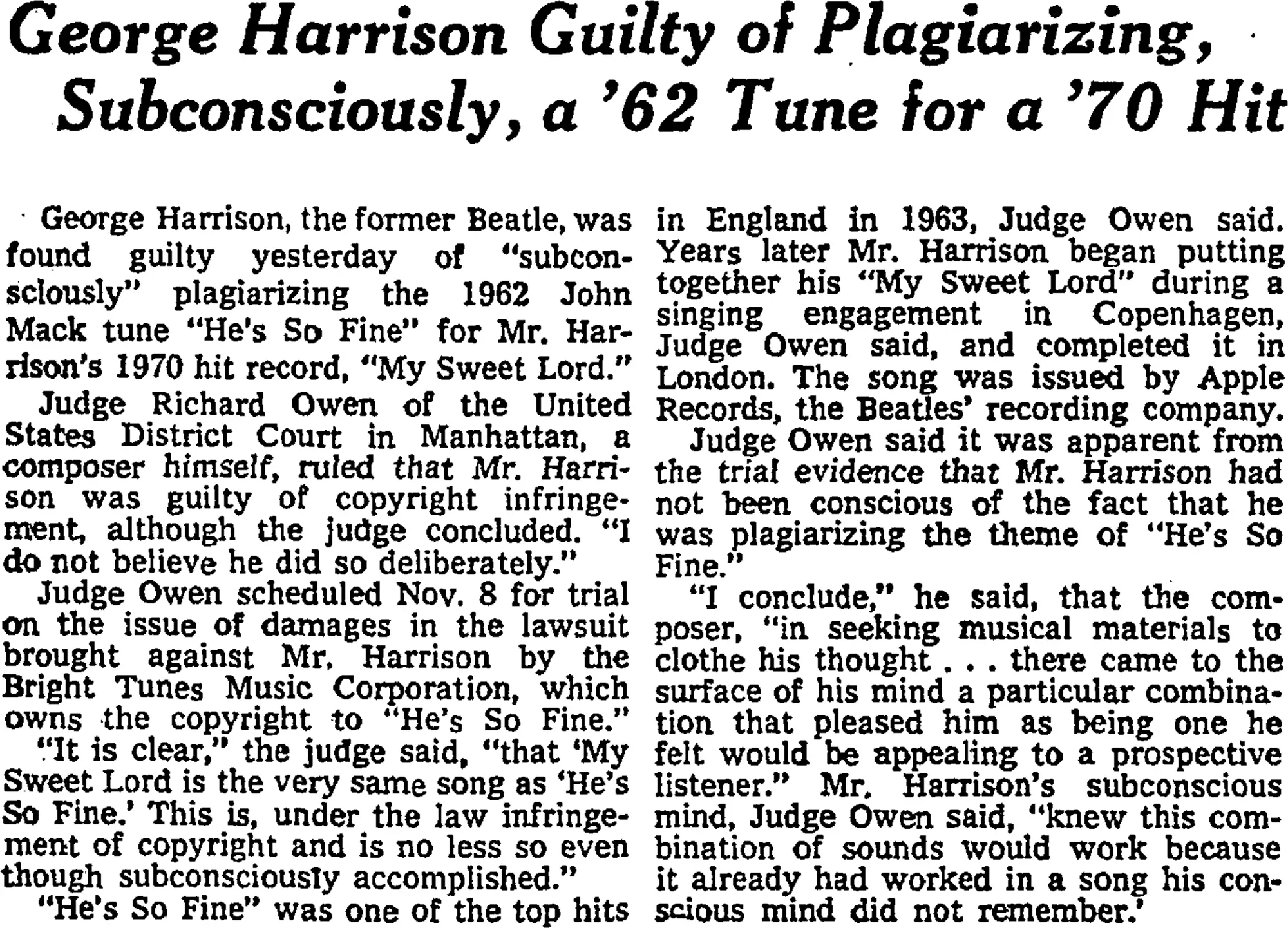

В одном известном случае Джордж Харрисон, после распада «Битлз», выпустил свой первый сольный хит в 1970 году — «My Sweet Lord», запоминающуюся песню, призывающую к прекращению религиозного сектаранства.

Но, как выяснилось, «My Sweet Lord» был крайне похож на хит Ронни Мака 1963 года «He’s So Fine», который возглавлял чарты. Гаррисон, конечно, слышал эту песню, но не осознавал, что копирует её почти нота в ноту. То, что последовало, стало одной из самых продолжительных судебных тяжб в истории США.

Из газеты

New York Times, 8 сентября 1976 года; окончательное разрешение юридического дела произошло только в 1998 году.

Если бы нам удалось найти способ обучать модели с гораздо меньшим объемом данных, более похожим на нас, это значительно помогло бы решить проблемы #1–3. Кураторство обучающих данных стало бы более практичным, что позволило бы избежать включения ответов на тестовые вопросы, нецелевого сбора работ живых художников и (как в хорошем, так и в плохом смысле) открыло бы возможность создания ИИ-моделей с нуля более широкой публике.

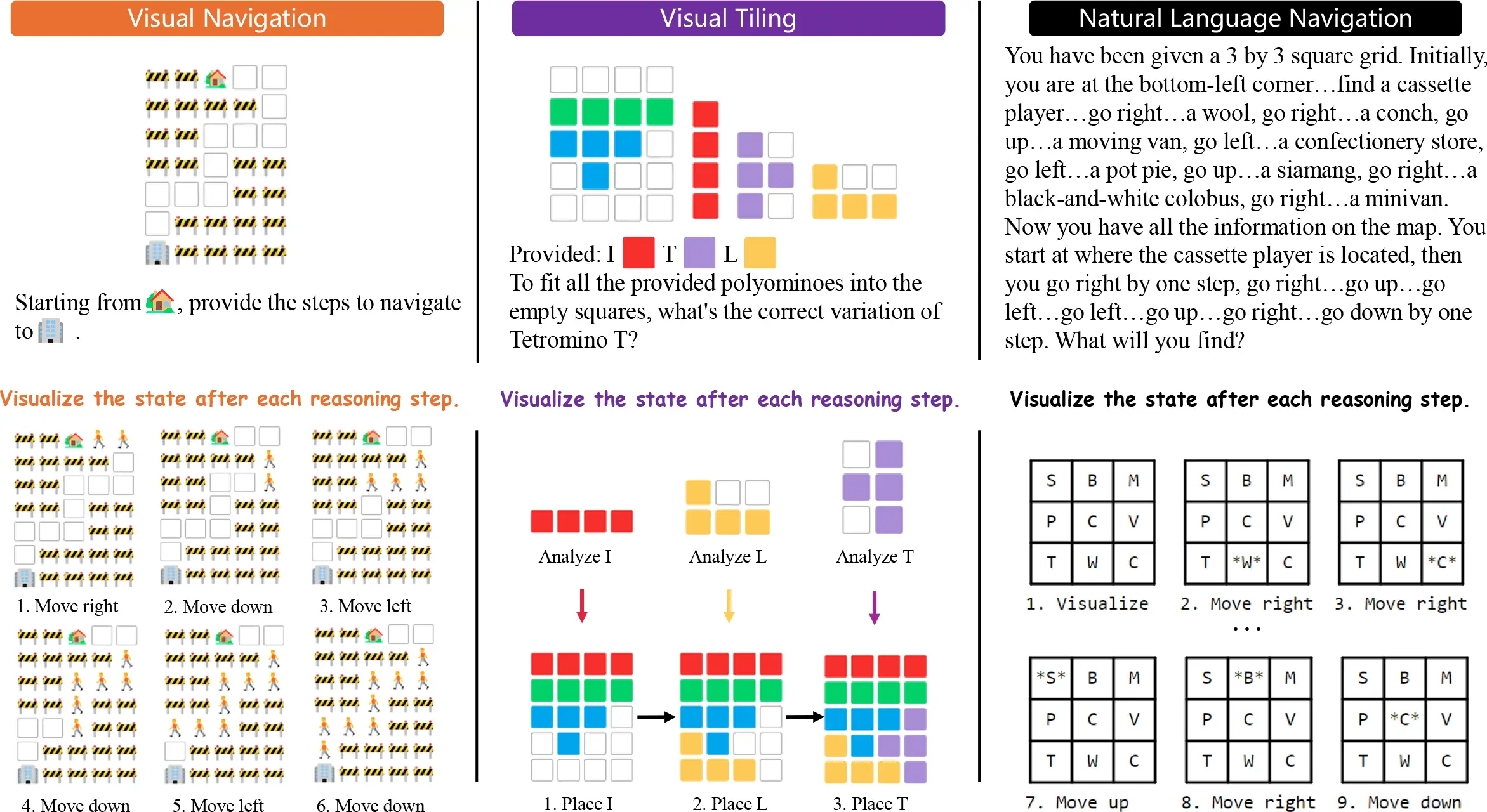

Я верю, что ключ к этому находится в пункте #4: стирание границы между обучением и выводом. Мы знаем, что это возможно, не только потому, что в мозгах такой границы нет, но и благодаря ряду открытий, которые проливают свет на основные свойства последовательного обучения и помогают понять, почему трансформеры работают так хорошо.

В 2020 году OpenAI анонсировала свою языковую модель GPT-3, предшественницу GPT-3.5, которая стала основой для ChatGPT. Анонс был представлен в виде статьи с любопытным заголовком: «Языковые модели — это обучающиеся с минимальным количеством примеров».

Это обучение было загадочным и, как казалось тогда, не имело отношения к обучению в привычном смысле, связанному с минимизацией ошибок через обратное распространение. Авторы указывали на то, что во время вывода — то есть в нормальном режиме работы после обучения — языковые модели все еще, похоже, способны учиться и делают это с необычайной эффективностью, несмотря на отсутствие изменений в параметрах нейронной сети.

В частности, они определили «обучение с несколькими примерами» как предоставление модели нескольких примеров задачи в контекстном окне и последующий запрос выполнить другую подобную задачу; «обучение с одним примером» подразумевало лишь один пример, а «обучение без примеров» включало в себя отсутствие примеров, только описание выполняемой задачи.

Мы уже сталкивались с несколькими такими ситуациями. Например, запрос модели, которая не была предварительно обучена или дообучена на задачах перевода, выполнить перевод — это задача нулевого обучения. То же самое касается запроса на рассуждение в цепочке мыслей. Или, для примера, который определенно не встречался в процессе предварительного обучения, рассмотрим следующий случай нулевого обучения: «‘Эквиантонимы’ — это пары слов, которые противоположны друг другу и имеют одинаковое количество букв. Какие ‘эквиантонимы’ вы можете назвать?»

Для ясности, эквиантонимы не существуют, или, по крайней мере, не существовали, пока мой соавтор Питер Норвиг и я не придумали этот запрос в 2023 году, чтобы проиллюстрировать нулевое обучение.

Это не совсем простая задача; на 2024 год ни один из популярных чат-ботов не справляется с ней надежно, хотя при некотором подталкивании Gemini Advanced удается выдать «давать/брать», добавляя с энтузиазмом, что он «настроен найти больше».

Можем ли мы действительно назвать это обучением, если параметры модели остаются неизменными? Обучение с помощью непрерывного ненадзорного или надзорного обратного распространения (т.е. дообучения) позволяет улучшить базовую модель в известных задачах, таких как перевод, или выполнять новые задачи, например, придумывать эквиантонимы. Затем мы могли бы сравнить производительность базовой модели с производительностью этих доработанных моделей. Эффективность должна измеряться с помощью запросов, то есть, задавая вопрос «Какие ‘эквиантонимы’ вы можете назвать?» без предисловий.

Предположительно, базовый уровень уже достаточно хорош для перевода, хотя постоянное обучение улучшит его; если модель не сделает очень удачное предположение о значении термина «эквивалентный антоним», её базовая производительность в этой новой задаче будет равна нулю, хотя с обучением она улучшится. Аналогично, мы можем провести сравнение между базовым уровнем без предварительного контекста и базовым уровнем с нулевыми, одно- или малочисленными подсказками. Все эти вмешательства приводят к улучшениям по сравнению с базовым уровнем. Таким образом, несмотря на фиксированные параметры, модели с подсказками кажутся такими, будто они учатся!

Авторы GPT-3 отметили, что эта способность учиться на лету, исходя из самой подсказки — «обучение в контексте» — является, как и математика, логика или любая другая способность модели, навыком, который улучшается с увеличением масштаба; более крупные модели справляются с этим лучше. В статье 2023 года, написанной исследователями из моей команды, наконец, начали проясняться механизмы этого процесса.

Они показали, что упрощённый трансформер с одним слоем внимания может, получив простую задачу и специально настроенный набор параметров, выполнить математический эквивалент одного шага обратного распространения на содержимом окна контекста. Другими словами, в этом несколько искусственном контексте модель способна реагировать на свою подсказку так, как будто она уже училась на этой подсказке перед тем, как предсказать следующий токен. Добавление второго слоя внимания позволяет модели эффективно сделать два шага обратного распространения, третий слой — третий шаг и так далее.

Если бы этот результат действовал только при заданных вручную параметрах, это было бы не более чем любопытством; действительно, недавно было обнаружено, что трансформер является вычислительно полным, так что он мог бы, теоретически, выполнять любые вычисления на своём окне контекста, при наличии правильных параметров. Однако, как оказалось, обычное предварительное обучение приводит к точно такому же поведению «обучения в контексте», как и в случае с заданными вручную параметрами. Другими словами, предварительно обученные трансформеры действительно учатся учиться.

На 2024 год проблема обучения в контексте еще не решена полностью, поскольку, хотя трансформеры делают это автоматически, они не запоминают ничего из того, что узнали, как только «тренировочные» материалы выходят за пределы контекстного окна. Отсутствующая часть механизма может напоминать гиппокамп, а возможно, и цикл сна для консолидации знаний и воспоминаний.

Тем не менее, обучение в контексте важно как теоретически, так и практически. Изучение его механики развеивает некоторые из более удивительных возможностей трансформеров. Оно раскрывает единство между обучением и предсказанием, которое становится очевидным при внимательном рассмотрении. В конце концов, предсказание всегда связано с моделированием изменяющейся среды (если только вы не находитесь в неизменной Темной комнате); обучение — это не что иное, как предсказание на длительных временных интервалах. На коротких временных интервалах, особенно когда то, что было изучено, быстро забывается, мы часто называем это «адаптацией».

Важный, связанный теоретический момент касается различия между причиной и корреляцией. Одной из критических замечаний, часто высказываемых в адрес машинного обучения, является то, что, поскольку оно обычно включает в себя пассивное обучение (как в случае предварительного обучения), оно может изучать только корреляции, а не причины. Согласно этой критике, пассивно обученная модель ИИ не может знать, что X является причиной Y, а лишь то, что X и Y коррелируют в тренировочных данных. Живые существа, такие как мы, с другой стороны, могут легко учиться причинности, проводя эксперименты. Возможно, когда ваша кошка, будучи активным учеником, беззаботно толкает вазу с высокой полки, она просто экспериментирует, чтобы выяснить, действительно ли толкание в этом направлении приведет к тому, что ваза упадет и разобьется.

Правда, что когда экспериментирование возможно, это предлагает мощный способ проверки причинности. Однако предположение о том, что причинность (в техническом смысле, «выводимость») не может быть выведена из пассивного наблюдения, и в частности, с помощью предварительно обученных языковых моделей, оказалось неверным. Это не всегда легко и не всегда возможно, но это можно сделать.

Действительно, исследователей, изучающих системы, на которых они не могут проводить причинные эксперименты, предостаточно — например, астрономы и макроэкономисты. В других случаях эксперименты этически запрещены, как в некоторых областях социальных наук и медицины. Таким исследователям приходится полагаться на «естественные эксперименты», то есть на наблюдения, которые явно указывают на причинные связи. Такие наблюдения никогда не могут полностью доказать причинность, но, в свою очередь, и эксперимент не способен на это. (Возможно, кошка просто добавляла еще один эксперимент, чтобы снизить неопределенность в своей причинной модели. Да, эта ваза тоже разбилась, когда упала. Верно. Снова.)

Исторически сложилось так, что утверждение о том, что машинное обучение изучает только корреляции, а не причины, стало популярным в эпоху сверточных нейронных сетей (CNN) в 2010-х годах. Поскольку большинство CNN не работали с временными последовательностями, а просто классифицировали изолированные стимулы, было трудно увидеть, как они могли бы узнать что-то кроме корреляций между этими стимулами. Прототип самоуправляемого автомобиля Nvidia DAVE-2, например, обучался под контролем, чтобы ассоциировать положение слева от центральной линии полосы с выводом «повернуть вправо», а положение справа — с «повернуть влево», но было бы преувеличением утверждать, что модель понимала, что эти действия управления впоследствии приведут к тому, что центральные линии окажутся ближе к середине. Они могли бы сделать и наоборот, или ничего не сделать. Действительно, у DAVE-2 не было внутреннего представления о «впоследствии». Если перемешать все кадры в видео вождения, его выводы по каждому кадру останутся прежними, и, действительно, во время обучения кадры перемешиваются случайным образом.

Однако обучение предсказанию меняет все. В частности, авторегрессионная модель последовательностей, обученная на той же задаче, будет учитывать влияние поворота налево или направо на последующие кадры, что подразумевает, что она будет учить, по крайней мере в пределах своего умвельта, что делает управление.

Он сможет использовать это понимание, чтобы внести коррективы в управление, даже если камера, смотрящая вперед, на мгновение будет закрыта. Он даже сможет смоделировать контрфакты — как изменится вид, если рулить влево или вправо. Обычного, пассивного предобучения будет достаточно, чтобы усвоить эти причинно-следственные связи. В этом нет ничего магического; требуется лишь моделировать время последовательно.

Но давайте вернемся к четырем ранее описанным проблемам и посмотрим, как обучение в контексте может помочь их преодолеть. Если трансформеры научатся учиться, они смогут обучать себя или друг друга так же, как это делаем мы. Они смогут запрашивать или искать информацию, а в некоторых случаях даже проводить эксперименты для обучения.

Такой активный подход к обучению, встроенный в агентное поведение, будет значительно эффективнее, чем пассивная случайная выборка, используемая в современном предобучении. Обучение могло бы быть куррикулумным, начиная с детских книг — как показали TinyStories, для этого не требуется огромного количества материалов. Затем, освоив основные человеческие концепции и язык, ИИ мог бы перейти к разделу для молодежи и двигаться дальше. Точно так же, как и мы.

Каждый обучающийся ИИ-агент мог бы специализироваться, изучая те области, которые наиболее полезны в его конкретном контексте, делая это индивидуально и на основе собственного опыта. Если данный агент взаимодействует с восемьюдесятью самыми увлеченными теоретиками чисел на планете, его обучение в конечном итоге будет сосредоточено на очень специфическом углу Мультифрактала Всего — углу, для адекватного разрешения которого потребовались бы колоссальные вычислительные мощности при случайной выборке. В качестве бонуса мы получили бы истинное разнообразие агентов, взаимодействующих с нами на социальном уровне, а не монолитные, универсальные и неспециализированные корпоративные модели, представляющие собой вершину технологий в 2024 году.

Сгоревший вопрос: будут ли эти индивидуализированные модели похожи на людей? И что, если вообще что-то, значит быть одним из них?

Комната Мэри

В 1982 году австралийский философ и самопровозглашённый «фрик качеств» Фрэнк Джексон предложил знаменитый мысленный эксперимент, известный как «Аргумент знания», который теперь чаще называют «Комнатой Мэри».

Суть эксперимента такова:

Мэри — блестящий учёный, который по каким-то причинам вынуждена исследовать мир из черно-белой комнаты через черно-белый телевизионный монитор. Она специализируется на нейрофизиологии зрения и получает [...] всю физическую информацию о том, что происходит, когда мы видим спелые помидоры или небо, и использует такие термины, как «красный», «синий» и так далее. Она выясняет [...] какие именно комбинации длин волн из неба стимулируют сетчатку, и как это приводит через центральную нервную систему к сокращению голосовых связок и выдоху воздуха из лёгких, что в итоге приводит к произнесению фразы «Небо синее». [...] Что произойдёт, когда Мэри выпустят из её черно-белой комнаты или дадут ей цветной телевизионный монитор? Узнает ли она что-то новое или нет? Кажется очевидным, что она узнает что-то о мире и нашем визуальном восприятии его. Но тогда становится неоспоримым, что её прежние знания были неполными. Но у неё была вся физическая информация. Следовательно, есть нечто большее, чем это, и физикализм ложен.

Сегодня, конечно, языковые модели — это Мэри, и аргумент знания снова стал актуальным.

Как бы мощно ни звучала басня Джексона, она, как и многие философские аргументы, основана на повествовании и народной интуиции. «Следовательно» завязывает ленту вокруг логического силлогизма, но ни одно из предикатов этого силлогизма не является однозначно истинным или ложным, как это должно быть в математическом доказательстве... и мы находимся на территории, где наши народные интуиции могут ввести нас в заблуждение.

Итак, давайте обновим наши интуиции, опираясь на то, что мы теперь знаем о восприятии и опыте, а это гораздо больше, чем знали в 1982 году.